DGX Spark で何ができる? 公式Playbookを整理してみた

はじめに

こんにちは、クラスメソッド製造ビジネステクノロジー部の森茂です。

DGX Spark 連載、開封の儀から Claude Code のローカル実行まで書いてきましたが、「そもそも DGX Spark でどんなことができるの?」というのが自分もまだよくわかっていません(完全に宝の持ち腐れです。。。)

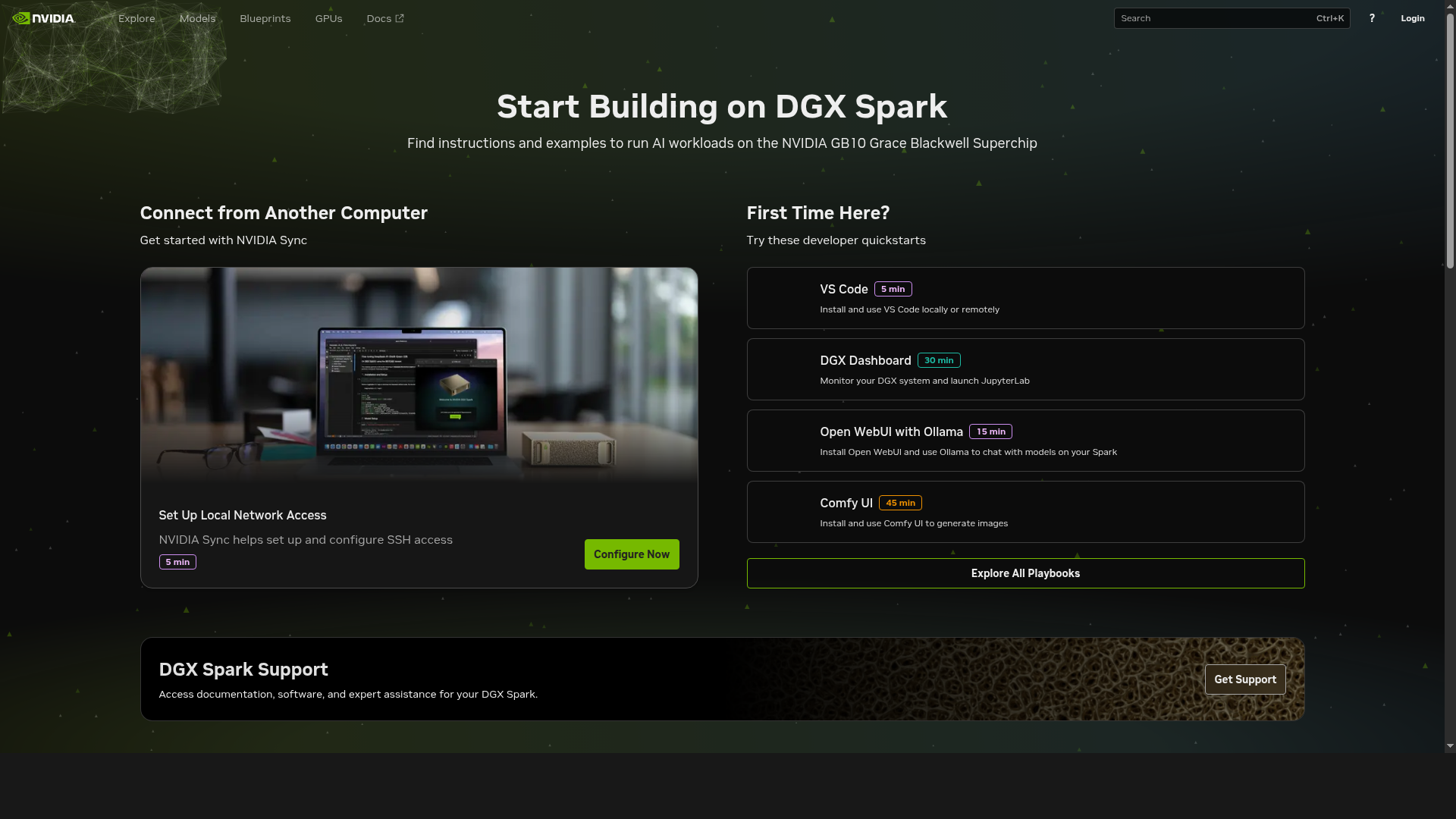

実は、NVIDIA が公式で「DGX Spark Playbooks」という 30 以上のガイド集を公開しています。

そこで、全 Playbook をカテゴリに整理して自分なりのカタログを作ってみました。全体感を掴む手がかりになれば幸いです。

Playbooksとは

DGX Spark Playbooks は NVIDIA が公式 GitHub リポジトリで公開しているステップバイステップガイド集です。推論エンジンからファインチューニング、ロボティクスシミュレーションまで幅広くカバーされています。

Apache-2.0 ライセンスで公開されていて、コミュニティからのコントリビューションも受け付けています。ほとんどの Playbook は NGC コンテナまたは Docker を使う構成なので、環境構築のハードルは低めです。公式ドキュメントサイト build.nvidia.com/spark から各 Playbook にアクセスできます。

CES 2025 で DGX Spark が発表され、2025 年 10 月の発売と同時期に Playbooks の公開が始まりました。その後、CES 2026 では NVFP4 量子化や推測デコーディングによる最大 2.6 倍の高速化が発表され、Playbooks も 30 以上に拡充されています。

カテゴリ別カタログ

2026 年 2 月時点で確認できた全 Playbook を、6 つのカテゴリに分けて紹介します。所要時間は公式サイトの記載を参考にしています。難易度は筆者の主観です。各 Playbook の安定度(Stable / Beta / Experimental)は後述の「安定度マップ」セクションにまとめています。

推論エンジン

DGX Spark で一番充実しているカテゴリです。開封の儀の記事で Ollama を実際に動かしたときも感じましたが、128GB の統合メモリで gpt-oss:120b クラスも動かせるのはやはり強い。prefill 282 tok/s、decode 39 tok/s と、読む速度と同じくらいの体感でした。

| Playbook | 難易度 | 所要時間 | 一言 |

|---|---|---|---|

| Ollama | 初級 | 10-15分 | 安定性が高い。開発者のファーストチョイス |

| Open WebUI with Ollama | 初級 | 10-15分 | ブラウザから即チャット。オンボーディングに最適 |

| TRT-LLM for Inference | 中級 | 45-60分 | 低レイテンシ特化。NVFP4量子化で8B〜120Bまで |

| vLLM for Inference | 中級 | 30分 | 高スループット・バッチ推論向け |

| SGLang for Inference | 中級 | 30-45分 | フロントエンド言語統合。SM121完全対応待ち |

| NIM on Spark | 初級 | 15-30分 | NGCカタログから選んでデプロイ |

| Speculative Decoding | 中級 | 30-45分 | EAGLE-3でgpt-oss:120Bを2-3倍高速化 |

| Nemotron-3-Nano with llama.cpp | 初-中級 | 30分 | Nemotron 3 Nano 30B-A3Bをllama.cppで実行 |

Ollama はセットアップの手軽さと安定性が魅力で、開発者のファーストチョイスとしておすすめです。

TRT-LLM と vLLM は NGC 公式コンテナが用意されていて、対応モデルも豊富です。一方で SGLang は SM121 アーキテクチャへの対応がまだ完全ではないため、Beta 的な位置付けです。

ファインチューニング

DGX Spark の 128GB メモリが本領を発揮する領域です。2 台を ConnectX-7 で接続すれば 256GB 構成になり、70B モデルの QLoRA ファインチューニングまで手が届きます。

| Playbook | 難易度 | 所要時間 | 一言 |

|---|---|---|---|

| LLaMA Factory | 初-中級 | 30-60分 | WebUI付きで迅速実験。入門に最適 |

| Fine-tune with PyTorch | 中-上級 | 1時間 | FSDP+LoRAで2台Spark 70B QLoRA対応 |

| Fine-tune with NeMo | 上級 | 45-90分 | プロダクションスケールの分散学習 |

| Unsloth on DGX Spark | 中級 | 30-60分 | 2倍高速化、メモリ効率が良い |

| FLUX.1 Dreambooth LoRA | 中級 | 30分+1-2h学習 | 画像生成モデルのFT。カスタムコンテナ |

| Vision-Language Model FT | 中級 | 15-20分+1-2h学習 | Qwen2.5-VL、InternVL3対応 |

手軽に始めるなら LLaMA Factory がおすすめです。WebUI から SFT/LoRA/QLoRA/RLHF を切り替えられるので、ファインチューニングの入門に向いています。本格的に取り組むなら、PyTorch FT の 2 台構成で 70B QLoRA に挑戦するのが面白そうです。

インフラ・接続

DGX Spark を「使える状態にする」ための Playbook 群です。リモートアクセスや VS Code での開発環境構築など、最初にセットアップするものが多いカテゴリかなと思います。

| Playbook | 難易度 | 所要時間 | 一言 |

|---|---|---|---|

| Set Up Local Network Access | 初級 | 5分 | ローカルネットワーク設定 |

| Set up Tailscale | 初級 | 15-30分 | VPN経由のセキュアなリモートアクセス |

| DGX Dashboard | 初級 | 15-30分 | システム監視とJupyterLab起動 |

| VS Code | 初級 | 5分 | リモート開発環境 |

| Vibe Coding in VS Code | 初級 | 15-30分 | Continue.dev、Nsight CUDA Copilot |

| Connect Two Sparks | 中級 | 1時間 | ConnectX-7 200Gbpsで2台接続 |

| NCCL for Two Sparks | 中級 | 30分 | 分散トレーニング用の通信設定 |

Tailscale を入れておくと外出先から手軽に SSH で接続できるので、かなり便利です。Vibe Coding の Playbook では Continue.dev と Nsight CUDA Copilot が紹介されていて、ローカル LLM を使ったコード補完環境を構築できます。

マルチモーダル

3 つと数は少ないですが、デモ映えする Playbook が揃っています。

| Playbook | 難易度 | 所要時間 | 一言 |

|---|---|---|---|

| ComfyUI | 初級 | 30-45分 | Stable Diffusion実行環境 |

| Live VLM WebUI | 初-中級 | 20分 | ウェブカメラ→VLMリアルタイム解析 |

| Multi-modal Inference | 中級 | 1時間 | マルチモーダル推論パイプライン |

Live VLM WebUI は個人的に気になっている Playbook の一つです。ウェブカメラの映像をリアルタイムで VLM(Gemma 3 や Llama Vision)に解析させて、ブラウザ上で結果を表示できます。「AI が何を見ているか」が可視化されるので、デモとしてのインパクトは大きいですね。

応用アプリケーション

RAG からナレッジグラフ、動画解析まで、LLM を活用したアプリケーション構築の Playbook です。

| Playbook | 難易度 | 所要時間 | 一言 |

|---|---|---|---|

| RAG in AI Workbench | 初級 | 30-45分 | 検索拡張生成の入門 |

| NVFP4 Quantization | 中-上級 | 45-90分 | TensorRT ModelOptでNVFP4量子化 |

| Text to Knowledge Graph | 中級 | 30分 | Ollama+ArangoDB+Three.jsで可視化 |

| Video Search & Summarization | 中-上級 | 30-45分 | VLM+LLM+RAG統合の動画解析 |

| Multi-Agent Chatbot | 中級 | 1時間 | マルチエージェントシステム |

Text to Knowledge Graph は、非構造化テキストから Ollama でトリプル(主語-述語-目的語)を抽出し、ArangoDB+Three.js でインタラクティブに可視化するという構成です。128GB メモリがあれば 70B モデルで高精度なトリプル抽出ができるので、DGX Spark の統合メモリが活きるユースケースかなと思っています。

その他(ロボティクス・データサイエンス・ドメイン特化)

ニッチながら気になる Playbook が集まっているカテゴリです。

| Playbook | 難易度 | 所要時間 | 一言 |

|---|---|---|---|

| Isaac Sim / Isaac Lab | 中-上級 | 30分+ビルド10-15分 | GPU加速物理シミュレーション・強化学習 |

| CUDA-X Data Science | 初級 | 20-30分 | RAPIDS、cuML、cuDFによるGPU加速 |

| Optimized JAX | 中級 | 2-3時間 | JAX開発環境の最適化 |

| Single-cell RNA Sequencing | 上級 | 15分 | ゲノミクスワークフロー |

| Quantitative Portfolio Optimization | 上級 | 20分 | 金融定量分析 |

Isaac Sim / Isaac Lab はロボティクス開発者にとって注目の Playbook です。PhysX ベースの GPU 加速物理シミュレーションと RL(強化学習)フレームワークが統合されていて、ANYmal、Unitree Go2、Franka Panda といったロボットの学習環境が 30 以上プリセットされています。DGX Spark でシミュレーション → Jetson で実機展開、という Sim2Real の流れが見えてきます。コミュニティでは Disney BDX ドロイドや低コスト自律レーシング、四足歩行ロボットのドア開閉など、Sim2Real 転送の成功事例も報告されていて、方向性としてはかなり面白いですね。

ドメイン特化の Playbook(ゲノミクス、金融)はかなり専門的な内容で、対象読者は限られます。ただ、こうした専門分野にも DGX Spark が使えるという可能性を示しているのは興味深いところです。

安定度マップ

ここからは私の勝手な解釈の範囲ではありますが、全 Playbook を 3 段階の安定度で分類しました。

| 安定度 | 定義 | 該当例 |

|---|---|---|

| Stable | NGC公式コンテナ提供、複数モデルで検証済み、トラブルシューティングが充実 | Ollama、TRT-LLM、vLLM、PyTorch FT、NeMo FT、LLaMA Factory |

| Beta | 動作するが「Beta」表記あり、またはDGX Spark固有の注意点が残る | NIM、SGLang、Speculative Decoding、NVFP4、Live VLM WebUI、Nemotron-3-Nano |

| Experimental | カスタムコンテナ使用、特定モデルでのみ検証 | FLUX FT、VLM FT、Multi-Agent、Isaac Sim、Knowledge Graph |

SM121アーキテクチャの課題

DGX Spark の GB10 チップは SM121 という新しいアーキテクチャを採用しており、ソフトウェア側の対応がまだ追いついていない部分があります。

- Triton(GPU 向けコンパイラ)が SM121 に未対応

- FP8 量子化の一部カーネルで CUDA エラーが発生する報告あり(ファインチューニングでは BF16 推奨)

- SGLang、vLLM の SM121 完全サポートはまだ道半ば

NVIDIA も CES 2026 で NVFP4+推測デコーディングによる FP8 比 2.6 倍の性能向上を発表しており、コミュニティベースでの対応も活発です。ただ、現時点では「Stable なものから始めて、徐々に範囲を広げる」のが無難かなと思っています。

具体的には、SM121 の課題に引っかかりやすいのは vLLM/SGLang での推論と FP8 でのファインチューニングです。Ollama での推論や BF16 でのファインチューニングは安定して動作します。

どこから始めるか

30 以上ある Playbook の中から何を試せばいいか迷うと思うので、3 段階のレベル別おすすめパスを提案します。

まずはここから(30分以内)

Ollama + Open WebUI のセットアップです。gpt-oss:20b を pull してブラウザからチャットできる状態まで、10-15 分で到達できます。詳しい手順は前述の開封の儀の記事を参照してください。

もう少し踏み込む

ここからは 2 つの方向性があります。

推論速度を追求するなら、TRT-LLM の Playbook がおすすめです。Ollama との速度差を体感できますし、NVFP4 量子化を使えば Llama 3.3 70B で 5.39 tok/s 程度という数値がコミュニティから報告されています。

ファインチューニングに興味があるなら、LLaMA Factory から始めるのが手軽です。WebUI からパラメータを調整して、自分のデータセットで SFT/LoRA/QLoRA を試せます。

本気で使い込む

2 台の DGX Spark を ConnectX-7 で接続する 256GB 構成です。この構成では以下のようなワークロードが可能になります。

- 70B QLoRA ファインチューニング(FSDP+LoRA、PyTorch FT Playbook)

- Qwen3-235B-A22B を NVFP4 で推論(11.73 tok/s 程度がコミュニティから報告されています)

- EAGLE-3 による推測デコーディングで 2-3 倍高速化

この領域はまだ自分でも試せていないので、実際に試したらあらためてレポートします。

まとめ

DGX Spark Playbooks の全体像をカテゴリ別に整理してみました。SM121 アーキテクチャのソフトウェア成熟度にはまだ課題が残っていますが、Ollama や TRT-LLM など Stable な Playbook から始めれば安定して使えますし、BF16 でのファインチューニングも実用的です。CES 2026 での NVFP4 最適化や Nemotron 3 Nano の追加など、エコシステムの拡充も続いています。

まずは Ollama + Open WebUI で 128GB メモリの恩恵を体感して、そこから興味のある方向に広げていくのがおすすめです。この記事が Playbook 選びの参考になれば幸いです。

DGX Spark連載?

| # | タイトル |

|---|---|

| 記事1 | DGX Sparkがやってきた |

| 記事1.5 | DGX Sparkの128GBメモリでClaude Codeのローカル実行に再挑戦してみた |

| 番外編 | DGX Sparkで何ができる? 公式Playbookを整理してみた(本記事) |

参考リンク

公式リソース

- DGX Spark Playbooks GitHub

- DGX Spark Playbooks ドキュメント

- DGX Spark Developer Forum

- DGX Spark Release Notes

- Isaac Sim / Isaac Lab

関連技術記事

- New Software and Model Optimizations Supercharge DGX Spark(CES 2026)

- Level1Techs DGX Spark Review

- Simon Willison DGX Spark Review