Ironwood TPU と AI 専用ハードウェア:ジェフ・ディーンが語る次なる展開

ウィスキー、シガー、パイプをこよなく愛する大栗です。

ラスベガスで開催された Google Cloud Next 2025 に参加してきました。Google の伝説的エンジニアであるジェフ・ディーンが登壇した唯一のセッションがあったのでレポートします。

Ironwood TPUs and specialized AI Hardware: Jeff Dean on what’s next

Ironwood TPUs and specialized AI Hardware: Jeff Dean on what’s next

このセッションは、Google の AI リーダであるジェフ・ディーンの対談です。また、Ironwood の詳細やデータセンターインフラ、Cloud TPU を AI ワークロードに適用するソフトウェアスタックなども解説します。

登壇者

- Jeff Dean

- Chief Scientist, Google DeepMind and Google Research

- Sabastian Mugazambi

- Senior Product Manager, Cloud AI Infrastructure

- Google Cloud

Google AI infrastructure innovation

Google は AI に特化したハードウェア分野でリーダーの地位にいます。特にカスタムデザインの AI アクセラレータである TPU に焦点を当てます。

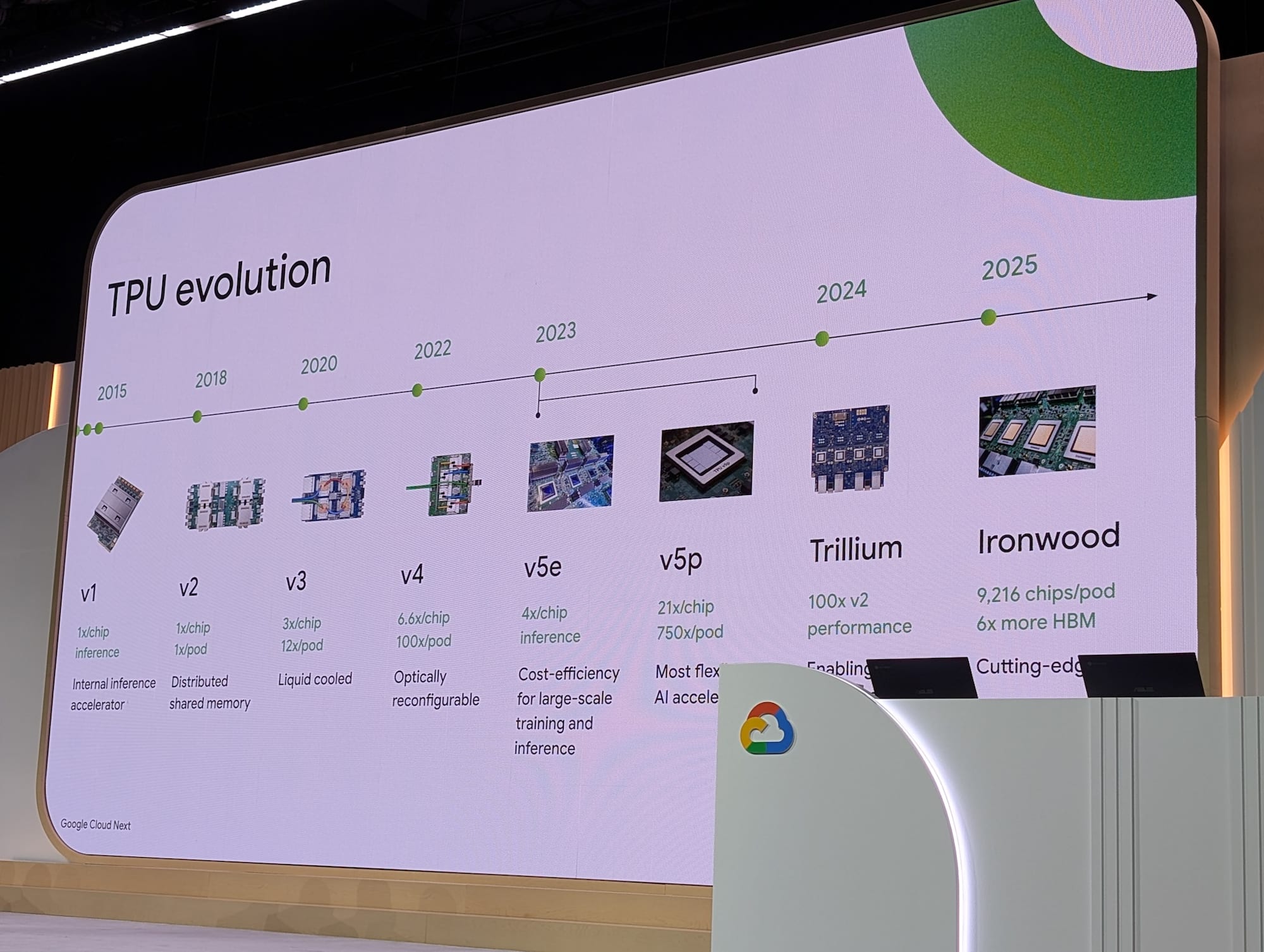

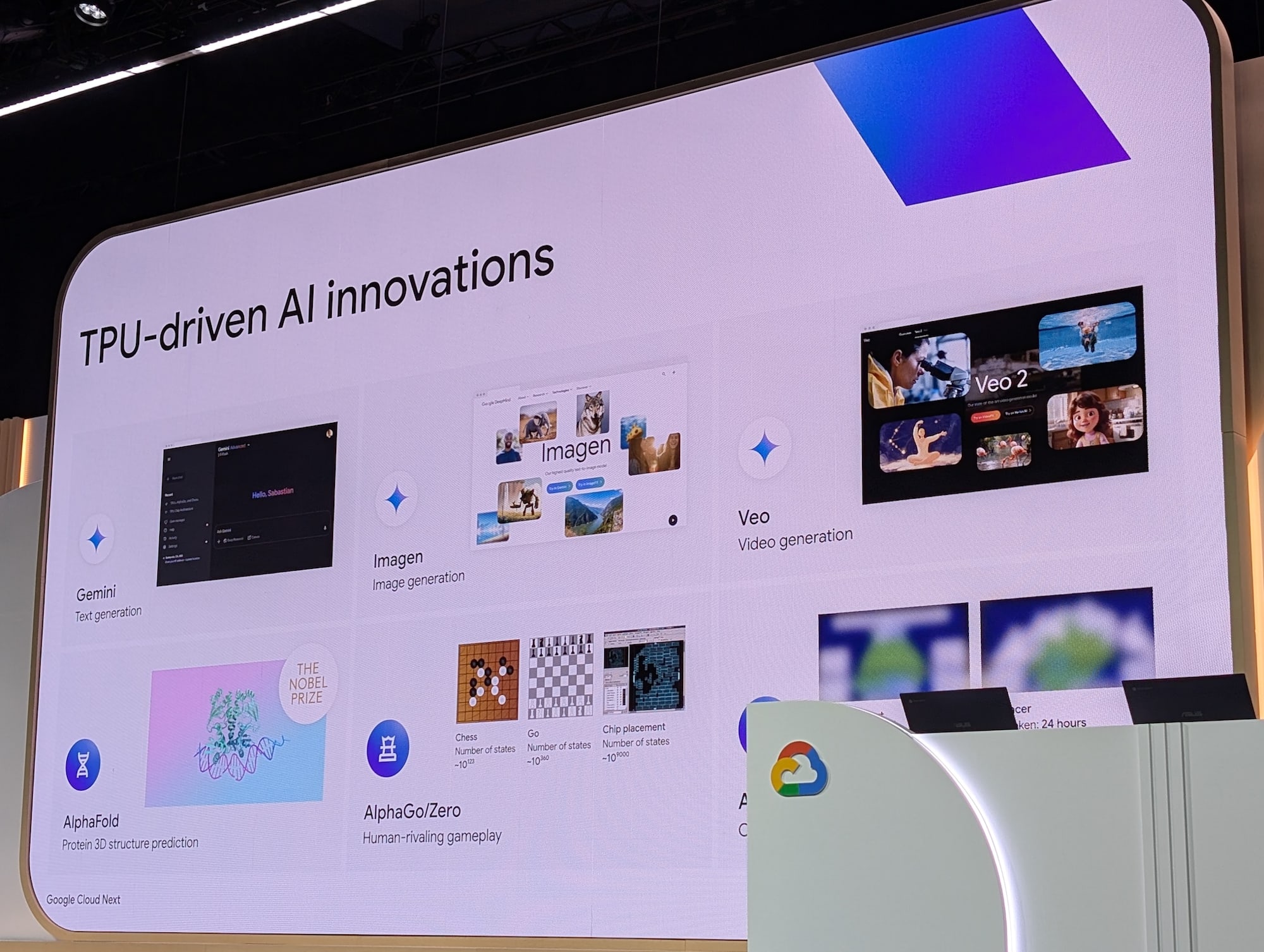

2015年に TPU v1 を発表して各世代の TPU で大幅に改良し、より高速でよりスケーラブルで効率的にしてきました。水曜日にはスンダー・ピチャイが第 7 世代 TPU の Ironwood を発表しました。TPU は翻訳、画像認識などを含む AI 主導のサービスを強化しており、Google Cloud Platform 経由で外部のお客様も利用できます。今週の Next で目にしたイノベーションの一部は TPU により強化され、生成 AI モデル、ビデオ、画像、Gemini モデルは TPU でトレーニングされて提供されています。

AlphaFold はタンパク質構造の予測など難しい問題を解決するために TPU でトレーニングを行いました。昨年、DeepMind のリーダーであるデミス・ハサビス卿とジョン・ジャンパー博士は、AlphaFold の研究でノーベル化学賞を受賞しました。チェスや囲碁のようなゲームをプレイする AI をトレーニングするために使用されたのと同じ原理が、チップ設計におけるワイヤの効率的な配置が可能なモデルの設計に使用されるようになると、事態は非常に興味深いです。

Google の AI ハイパーコンピューターは Gemini のトレーニングや Vertex AI のファインチューニングでも全体にわたって AI テクノロジーを支えています。2015 年以来 AI ワークロードについてデータセンター規模で専門の技術を導入してきました。

- 専用 TPU ASIC による機械学習コンピュートの高速化

- 高速行列演算のためのベクターユニットとスカラーユニット、シストリックアレイを備えています。シストリックアレイはメモリアクセスを最小化し、チップ間接続で HBM メモリを共有しています。

- 垂直電力供給による電力効率の向上

- APEC 2024 (Applied Power Electronics Conference) で 1,000A の大容量垂直電源ソリューションを発表して、配電損失を 70% 削減しました。

- 同期式高帯域幅インターチップ・インターコネクト(ICI)がスループットを向上

- チップ間相互接続ドメイン内でトーラストポロジネットワークで接続され、ポッドと呼んでいます。4 リンクの 2D や 6 リンクの 3D トポロジが構成でき、最大で 4x4x4 のキューブで構成され 9,000 個を超えるチップが相互接続されます。

- 光回線スイッチングによるフォールトトレランスと効率的なスケジューリングが可能

- 大規模で多様なトポロジでは光回路スイッチが必要であり、TPU v4 で導入しました。物理的な再配線を必要とせずに再構成可能なトポロジを実現でき、消費電力とレイテンシを少なく、チップ間でメモリを共有可能になります。

- 拡張性を高めるデータセンター ネットワーク

- 第 5 世代の Jupiter ネットワークでセクション帯域 16 ペタビット/秒まで拡張されています。Ironwood ポッドは単一ジョブで 400,000 チップ以上に拡張可能で FP8 で 1.8 Zeta Flops を実現するクラスタの構築が可能です。

- システム効率を最大化する液冷

- 効率的な冷却のために高密度ラックに直接液体冷却を行っています。PUE も低下し 1GW 以上が液冷式で、毎年 3 倍増加しています。

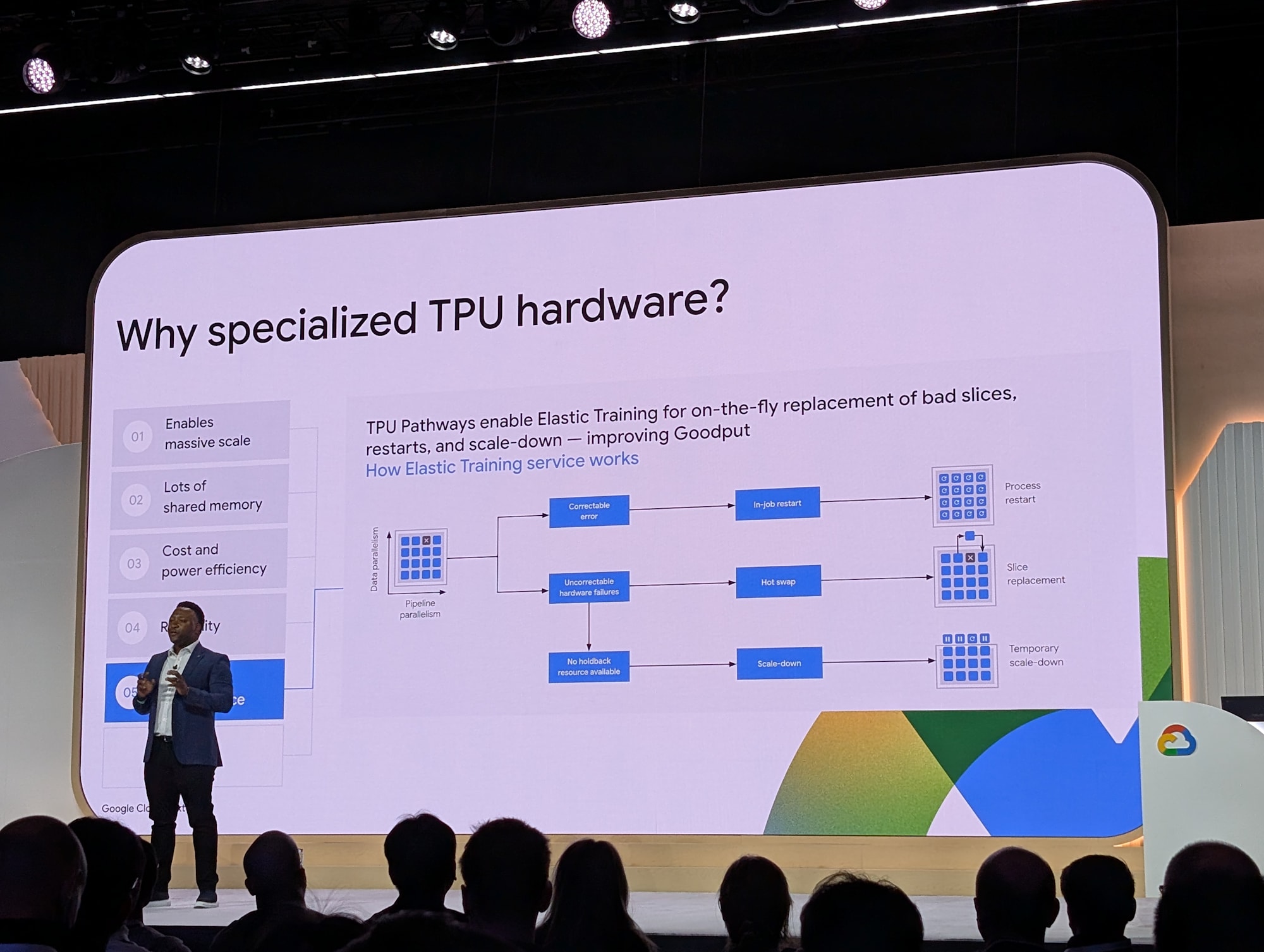

なぜ専用の AI ハードウェアが必要なのか 6 つのポイントがあります。大規模スケールの実現、大容量共有メモリ、コストと電力効率、信頼性、柔軟性と回復力、パフォーマンスです。

更に詳しくはエキスポにある AI ハードウェアブースで TPU ラックと Ironwood TPU チップをご覧下さい。

In conversation with Jeff Dean

Google のチーフサイエンティストであり、Gemini のコア技術責任者の Jeff Dean 氏をお呼びしてインタビューを行います。

Ironwood TPU のインパクト

Ironwood TPU は素晴らしいスペックで社内の Gemini のトレーニングなどに利用することを楽しみにしています。ディープラーニングで機能したレシピが、より多くのコンピューティングとデータで大規模なモデルとトレーニングできるのかを気にしています。実際に Ironwood TPU は低エネルギーで効率的なスケーリングを実現しており興奮しています。

25年間のアーキテクチャの課題から得た洞察

検索やクロール、インデックス作成などでは大規模なコンピュータシステムでは堅牢で信頼性が高く、大規模に処理を行うのに分散処理や並列化が必要になります。モデルへのクエリにいんた楽亭l部な応答をするには TPU インターコネクトが非常に優れています。

分散コンピューティング インフラストラクチャ システムの構築から学んだ教訓としては、大規模になると信頼性が問題になってくることです。一部が失敗した時に別のマシンへ移したり、過負荷になっているマシンから作業を移動してバランスを取ったり、エラスティック トレーニングを行っています。

AI ハードウェアの社会的利益への役割

AI の能力は高まっていて、以前には想像していなかった医療、意思決定、教育などに AI が役立っています。最適なスタイルの家庭教師をつけることなども眼の前に迫っています。AI ハードウェアはトレーニングと推論をより効率的にして多くの機能を低コストで提供できるようにすることです。

AIモデルを活かすためのアーキテクチャのイノベーション

推論モデルは高品質な結果を得られますが、大量のトークンを考慮するため多くの計算が必要です。トレーニング中の浮動小数点演算の精度を下げたり、推論中にパラメーターを量子化のレベルを下げるなどのテクニックは、コストを下げます。推論用に圃場に特殊なハードウェアを開発することがトレンドになると思います。

電力効率とスケーラブルな性能を実現するための超専門化

ハードウェアは特定のタスクに特化させることで大幅に効率化されます。TPU v1 では CPU や GPU よりも 30〜80 倍効率化できました。特に推論ワークロードをさらに特化して、さらなる成果を挙げられると思います。

モデルとチップの開発のための協調設計

ML の急速な進歩に対して、チップ設計には時間がかかります。チップ設計への AI 活用はより早く結果を得ることができると考えています。チップ設計に参加していない事による高レベルの自動合成の不使用や検証が大きな問題になっています。ハードウェア設計をソフトウェア コンパイラに近づけばより自動化して室の高い設計が可能になるでしょう。

AIインフラストラクチャにおける未解決の課題

推論が非常に重要になります。有能なモデルは大きく扱いにくいため、上流や量子化などでより小さなモデルに変換しています。変換のために ML アルゴリズムが必要になります。小さな要素に組み込まれて、日常生活を通じて利用できるようになります。

さいごに

Google 最高のエンジニアである Jeff Dean の名前は様々な場面で聞きますが、本セッションで初めて本人を目撃できました。彼が今後 Google にとって最重要である AI 分野のトップにいるため、さらなる AI の進化に期待しています。