Azure Machine Learning Studioで使って理解を深めるResponsible AI (Part 1) #Azure #AzureMachineLearning

この記事は公開されてから1年以上経過しています。情報が古い可能性がありますので、ご注意ください。

こんにちは、Mr.Moです。

AI/MLの活用がどんどん進んでいる世の中ですが、一方で導入した後に倫理問題などの壁が立ちはだかることがあるようです。こういった問題には機械学習モデルに関するさらに深い理解・把握などが必要になります。そこで今回はMicrosoftが考えるResponsible AIについて見て行こうと思います。 (本エントリーの内容は個人的な解釈や見解が含まれますのであらかじめご了承ください。)

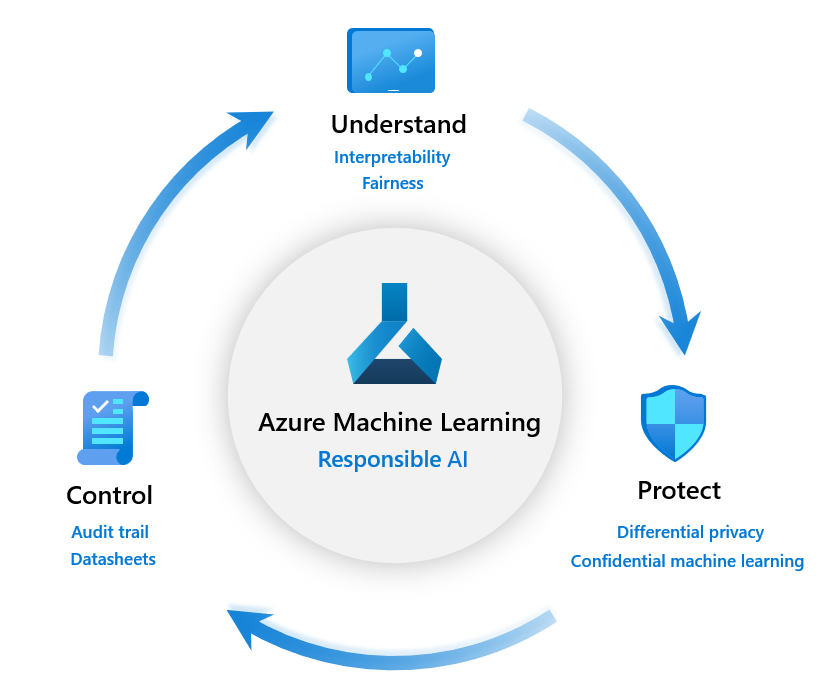

MicrosoftのResponsible MLとは

Microsoftでは信用できるAI/MLの構築に必要な要素として下記の点をあげています。

- 機械学習モデルを理解する

- モデルの動作を解釈して説明する

- モデルの不公平性を評価して軽減する

- ユーザーとそのデータを保護する

- 差分プライバシーによりデータの漏えいを防ぐ

- 準同型暗号を使用して暗号化されたデータを操作する

- エンドツーエンドの機械学習プロセスを制御する

- データシートで機械学習のライフサイクルを文書化する

機械学習モデルの中身への深い理解、データの気密性を担保し、そして一連の処理を統合・管理する。そうすることでAI/MLのテクノロジが引き起こす可能性があった、望ましくない結果を事前に察知して防ぐことができるようになるというものです。

今回はこの要素のうち、「機械学習モデルの理解」について見て行こうと思います。 Microsoftでは機械学習モデルのより深い理解のため、下記のオープンソースなどを作り出し実現しています。

InterpretML

InterpretMLは機械学習モデルを説明・解釈可能にするため、下記の機能が提供されています。

- モデルパフォーマンス

-

データエクスプローラー

-

特徴量の重要度(グローバル)

-

個別の特徴量の重要度(ローカル)とwhat-if分析

Fairlearn

Fairlearnでは、機械学習モデルに潜む、偏りやバイアスによって不公平なモデルになっていないかを可視化します。

Error Analysis

そしてエラー分析です。予測結果との誤差がなぜ起きているのかを深く理解し、機械学習モデルに潜むエラーの根本的な原因を診断します。

まとめ

まずはざっと紹介してみました。次回以降でさらに1つ1つ掘り下げて見ていきたいと思います。

ちなみに下記は私の方で実際に「InterpretML」、「Fairness」、「Error Analysis」を使ってみているところになります。「InterpretML」、「Fairness」に関してはプレビューではありますが既にAzure Machine Learning Studioの実験に組み込まれていますね。 (下記は、AML Studio Notebooks上 → AML Studio 実験上 → Webアプリ版 の順番で見ています。)

参考

- https://azure.microsoft.com/ja-jp/services/machine-learning/responsibleml/

- https://docs.microsoft.com/ja-jp/azure/machine-learning/concept-responsible-ml

- https://docs.microsoft.com/ja-jp/azure/machine-learning/how-to-machine-learning-interpretability

- https://docs.microsoft.com/ja-jp/azure/machine-learning/concept-fairness-ml

- https://github.com/microsoft/responsible-ai-widgets

- https://www.youtube.com/watch?v=Ts6tB2p97ek

- https://www.youtube.com/watch?v=kIOZOYZ8_es

- https://techcommunity.microsoft.com/t5/azure-ai/responsible-machine-learning-with-error-analysis/ba-p/2141774