Amazon Connect AIエージェントでOpenAIの gpt-oss-120b と gpt-oss-20bが利用できるようになりました

はじめに

What's NewやAWSドキュメントには記載されていませんが、東京リージョンのAmazon ConnectのAIエージェントで、OpenAI社のオープンウェイト言語モデル「gpt-oss-120b」と「gpt-oss-20b」が選択できるようになりました。

従来、東京リージョンのAmazon Connectで選択できるモデルは以下の9つでした。

- anthropic.claude-3-haiku-20240307-v1:0

- apac.amazon.nova-lite-v1:0

- apac.amazon.nova-pro-v1:0

- apac.amazon.nova-micro-v1:0

- apac.anthropic.claude-3-5-sonnet-20241022-v2:0

- apac.anthropic.claude-3-haiku-20240307-v1:0

- apac.anthropic.claude-sonnet-4-20250514-v1:0

- global.anthropic.claude-haiku-4-5-20251001-v1:0

- global.anthropic.claude-sonnet-4-5-20250929-v1:0

今回、以下のモデルが選択できるようになりました。

- openai.gpt-oss-20b-1:0

- openai.gpt-oss-120b-1:0

本記事では、以下の記事を参考に、東京リージョンのAmazon Q in Connectセルフサービスにて、AIプロンプトを利用したAIエージェントでモデル別のレスポンス速度を検証します。

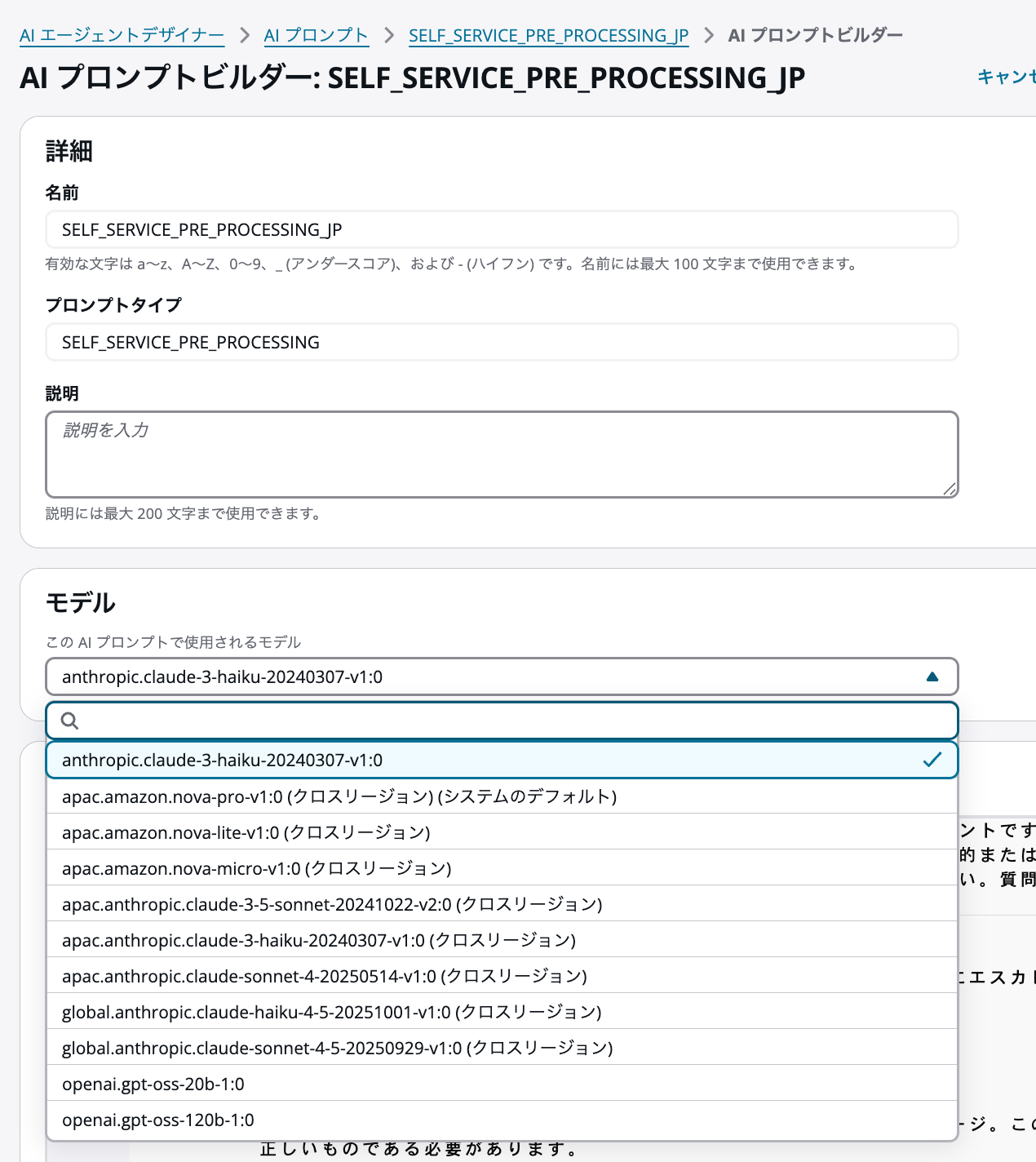

利用可能なモデルの確認

プロンプトタイプSELF_SERVICE_PRE_PROCESSINGにて、各モデルを選択できることを確認しました。

今回のアップデートで追加された以下のモデルも選択可能です。

- openai.gpt-oss-20b-1:0

- openai.gpt-oss-120b-1:0

レスポンス速度の検証

参考記事で紹介されているFOLLOW_UP_QUESTIONツールを利用して検証を行いました。このツールは、デフォルトツールやカスタムツールと連動し、適切なアクションを実行する前に必要な情報を段階的に収集できます。

今回は、1つずつヒアリングすると速度計測の差が出にくかったため、「複数情報の一括入力(5項目を一度に伝える)」で検証しました。使用チャネルはチャットです。自動回答は行わず、FOLLOW_UP_QUESTIONツールを選択した際のレスポンス速度を計測しました。

以下の記事を参考に、Amazon Q in Connectのログを有効化し、ログからレスポンス時間を算出しました。

ここでのレスポンス時間は「Q in Connectへの発話から回答が生成されるまで」を指し、Amazon Lexとのやり取りにかかる時間は含みません。

検証結果

今回のアップデートで利用可能になったモデルを含め、Amazon Q in Connectのエージェントで応答速度の比較を行いました。結果は以下のとおりです。

約2秒

- openai.gpt-oss-120b-1:0

約3秒

- global.anthropic.claude-haiku-4-5-20251001-v1:0

約2秒〜4秒(ばらつきあり)

- openai.gpt-oss-20b-1:0

約4.5秒

- apac.anthropic.claude-sonnet-4-20250514-v1:0

検証の結果、今回追加された gpt-oss-120b が約2秒台前半と、今回比較した中では最も高速かつ安定している という結果になりました。一般的にパラメータサイズが大きいモデルの方が推論に時間がかかる傾向にありますが、今回の検証環境下では120bの方が高速でした。

一方で、gpt-oss-20b については、1.9秒で応答する場合もあれば、約4秒近くかかる場合もあり、レスポンス速度が安定しない 傾向が見られました。タイミングによって応答時間に2倍近くの開きが出ることがある点には注意が必要です。

今回の結果は、あくまで特定のプロンプト(5項目の一括入力)を用いた一例に過ぎません。本検証は5項目の一括入力によるヒアリング時の計測結果であり、自動回答時などでは応答速度が異なる可能性があります。記載した秒数はあくまで参考値として捉えてください。

最後に

Amazon ConnectのAIエージェントで、OpenAIの gpt-oss-120b と gpt-oss-20b が利用可能になりました。

今回の検証では、gpt-oss-120bが非常に高速なレスポンスを示しました。電話やチャットでの対話において、レスポンス速度は顧客体験(CX)に直結する重要な要素です。

Amazon Q in Connectではモデル選択による追加コストは発生しないため(Q in Connectの利用料金に含まれる)、これらの新しいモデルの採用を検討してみても良いかもしれません。