AWS で NVIDIA GB300 NVL72 が利用できる P6e-GB300 UltraServers が一般提供開始されました

はじめに

大規模言語モデル(LLM)のトレーニング、生成 AI の推論ワークロードのためにハイエンドの GPU 要求が爆発的に高まっています。2025 年 12 月 2 日 AWS 上で NVIDIA GB300 NVL72 が利用可能となるAmazon EC2 P6e-GB300 UltraServers の一般提供を発表しました。72 個の GPU を搭載しており GPU の合計メモリは約 20TB にもなります。

現在、AWS から公開されている情報が少ないため、NVIDIA GB300 NVL72 を中心にご紹介します。

P6e-GB300 UltraServers とは

P6e-GB300 UltraServers は、AWS が提供する最新のハイエンド GPU インスタンスです。肝心の GPU はNVIDIA Blackwell Ultra GPU を搭載しています。

インスタンスは、Amazon EC2 UltraServersを採用しています。UltraServer とは、複数の EC2 インスタンスを専用の高帯域・低レイテンシアクセラレータインターコネクトで接続し、複数の EC2 インスタンスを密結合させてスケール可能な仕組みです。単一インスタンスの制約を超えた大規模な計算リソースを利用可能となっています。

GPU メモリサイズ

気になる GPU メモリはというと、P6e-GB300 は前世代の P6e-GB200 と比較すると 1.5 倍増となっています。

| 項目 | P6e-GB200 | P6e-GB300 | 比較 |

|---|---|---|---|

| GPU メモリ(1 GPU あたり) | 192 GB HBM3e | 288 GB HBM3e | 1.5 倍 |

| 合計 GPU メモリ(72 GPU 構成) | 約 13.4 TB | 約 20 TB | 1.5 倍 |

主要スペック

P6e-GB300 UltraServers スペックは現時点では公開されておりません。(2025/12/2 7:00 時点)

公式ページにアップされると思いますので以下のページをご確認ください。

提供リージョン・利用方法

AWS の営業担当へお問い合わせくださいとアナウンスされています。

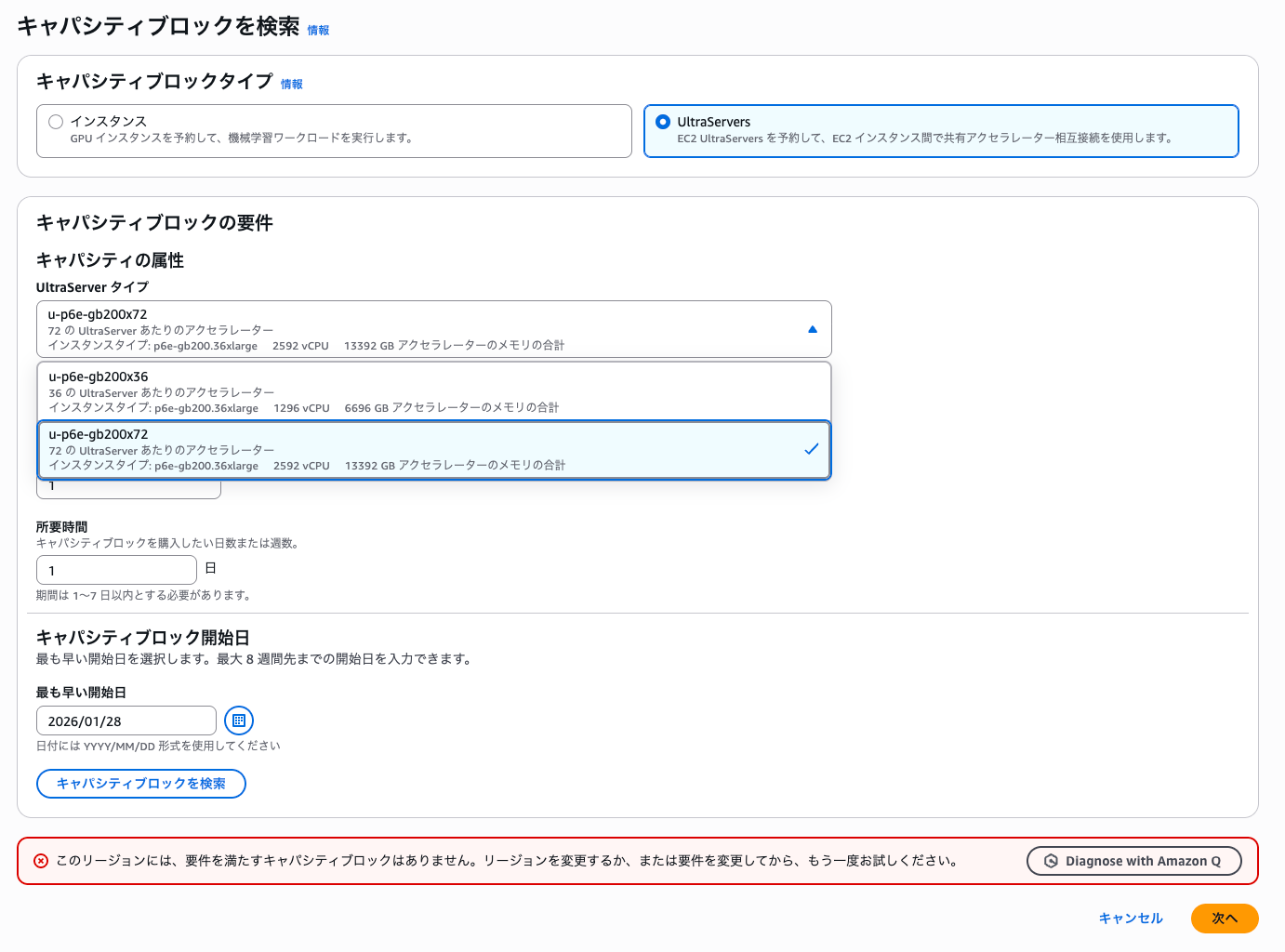

過去には Capacity Blocks for ML で予約できないけど、名前の表示だけ確認できることはありました。今回は問い合わせしないと提供リージョンも、利用方法も不明です。

提供リージョンの可能性が高いのは、P6e-GB200 UlterServers と同じくバージニア北部リージョン(us-east-1)のローカルゾーンであるダラス(us-east-1-dfw-2a)です。NVIDIA GB300 NVL72 は液体冷却のみのサポートのため、既存で IRHX(AWS の液体冷却システム)が導入を確認できているのはダラスのみです。

まとめ

Amazon EC2 P6e-GB300 UltraServers は、NVIDIA GB300 NVL72 を搭載した最新のハイエンド GPU インスタンスです。ご利用には AWS の営業担当様へのお問い合わせが必要となっております。 クラスメソッドメンバーズのご利用のお客様でしたら弊社営業担当からお繋ぎ致しますのでご連絡ください。

おわりに

P6e-GB300 UltraServers の GPU を中心に紹介しました。追って情報が公開されると思いますので待ちましょう。

AWS は OpenAI との 380 億ドル規模の戦略的提携を発表しており、GB200 と GB300 を数十万チップ規模で提供する予定となっています。一般提供開始(要問い合わせ)の現状ですと一般ユーザー向けにどの程度 GPU を解放されるのかわからないですね。

GB200 も依然として、1 リージョン(1 ローカルゾーン)での提供のため、利用したくてもキャパシティの確保が課題となっています。GB300 の一般提供によりハイエンド GPU の絶対数は増えたのは間違いないので利用できるユーザーが少しでも増えるといいなと願っています。