เจาะลึก ! Amazon Nova เทคโนโลยีสร้างข้อความอัจฉริยะ ที่คุณต้องรู้ ! #AWSreInvent

この記事は公開されてから1年以上経過しています。情報が古い可能性がありますので、ご注意ください。

สวัสดีค่า สาลี่ จาก Classmethod เองค่ะ 😄✨

วันนี้มีโอกาสได้แปลบล็อก เกี่ยวกับ Amazon Nova ที่เป็น โมเดล AI น้องใหม่ไฟแรงจาก AWS นั่นเอง

ซึ่งขอบอกเลยว่า เจ้าของบล็อกอย่าง คุณ @TakaakiKakei ได้เจาะลึกข้อมูลของ Amazon Nova

ในเรื่องของเทคโนโลยีสร้างข้อความได้ไว้ดีสุด ๆ หากใครสนใจเรื่อง เทคโนโลยีสร้างข้อความ (Text Generation Models) อยู่แล้ว บล็อกนี้ก็ตอบโจทย์สุด ๆ ค่ะ

บทความนี้แปลมาจากบล็อก คุณ @TakaakiKakei โดยมีการดัดแปลงจากต้นฉบับเล็กน้อย

สามารถอ่านบทความต้นฉบับได้ที่ -> Amazon Novaのテキスト生成モデルについて調査してみた #AWSreInvent

⭑・゜゜・⭑・゜゜・⭑・゜゜・⭑

สวัสดีครับ @TakaakiKakei เองครับ

วันนี้ ผมจะพาทุกคนมาเจาะลึกเกี่ยวกับ Amazon Nova - เทคโนโลยีสร้างข้อความอัจฉริยะรุ่นล่าสุด ที่พึ่งประกาศเปิดตัวไปในงาน AWS re:Invent 2024 เมื่อวันที่ 2-6 ธันวาคม 2024 ที่ผ่านมานี้ ให้ทุกคนได้อ่านกันครับ !

หลักการวิเคราะห์

โดยโมเดลสร้างข้อความอัจฉริยะ (Text Generation Models) ที่วิเคราะห์ มีดังนี้

- Nova Micro

- Nova Lite

- Nova Pro

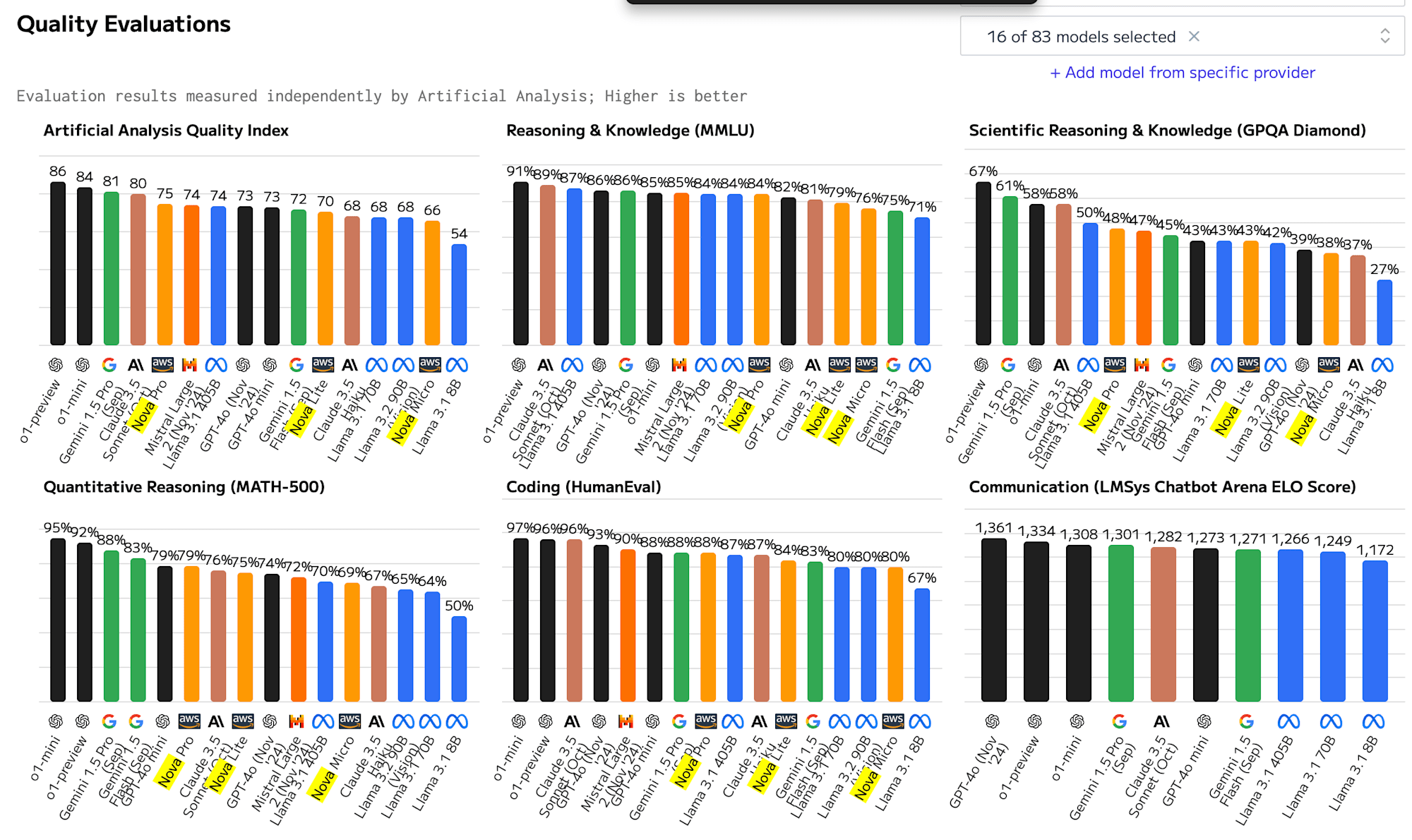

ในการเปรียบเทียบโมเดลแต่ละรุ่น ได้อ้างอิงข้อมูลมาจากเว็บไซต์ Artificial Analysis ที่เผยแพร่เรื่องการเปรียบเทียบโมเดล AI เป็นหลัก

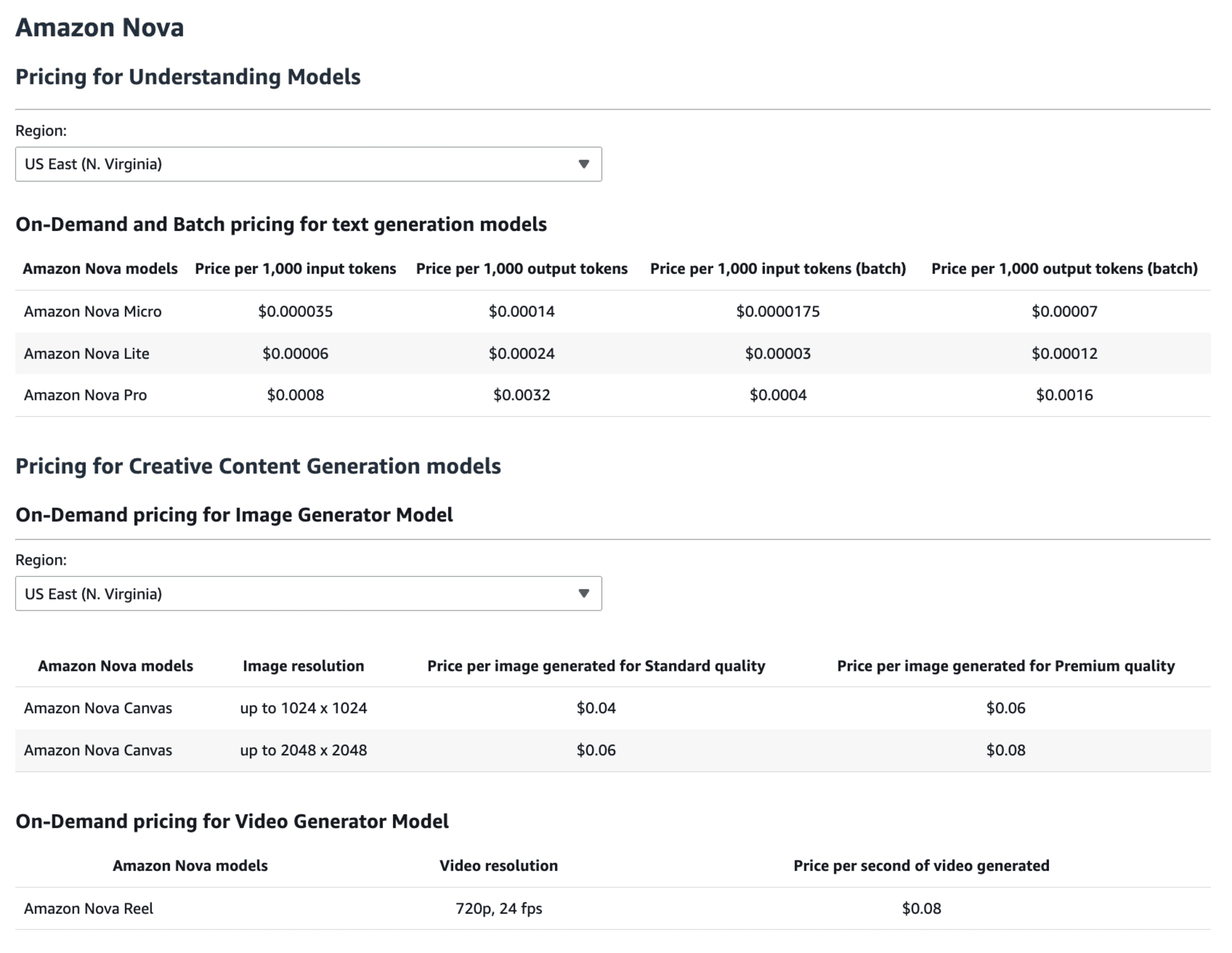

เกี่ยวกับราคา

ราคาแบบ On-demand มีดังตารางด้านล่างนี้ ซึ่งเมื่อเปรียบเทียบเทียบกับโมเดลคู่แข่งในเรื่องของราคา ถือว่าถูกมาก

ราคาแบบ On-demand มีดังตารางด้านล่างนี้ ซึ่งเมื่อเปรียบเทียบเทียบกับโมเดลคู่แข่งในเรื่องของราคา ถือว่าถูกมาก

| โมเดล | ค่าใช้จ่ายในการ Input (ต่อ 1,000 ตัวอักษร) | ค่าใช้จ่ายในการ output (ต่อ 1,000 ตัวอักษร) |

|---|---|---|

| Amazon Nova Micro | $0.000035 | $0.00014 |

| Amazon Nova Lite | $0.00006 | $0.00024 |

| Amazon Nova Pro | $0.0008 | $0.0032 |

| Claude 3.5 Haiku | $0.0008 | $0.004 |

| Claude 3.5 Sonnet | $0.003 | $0.015 |

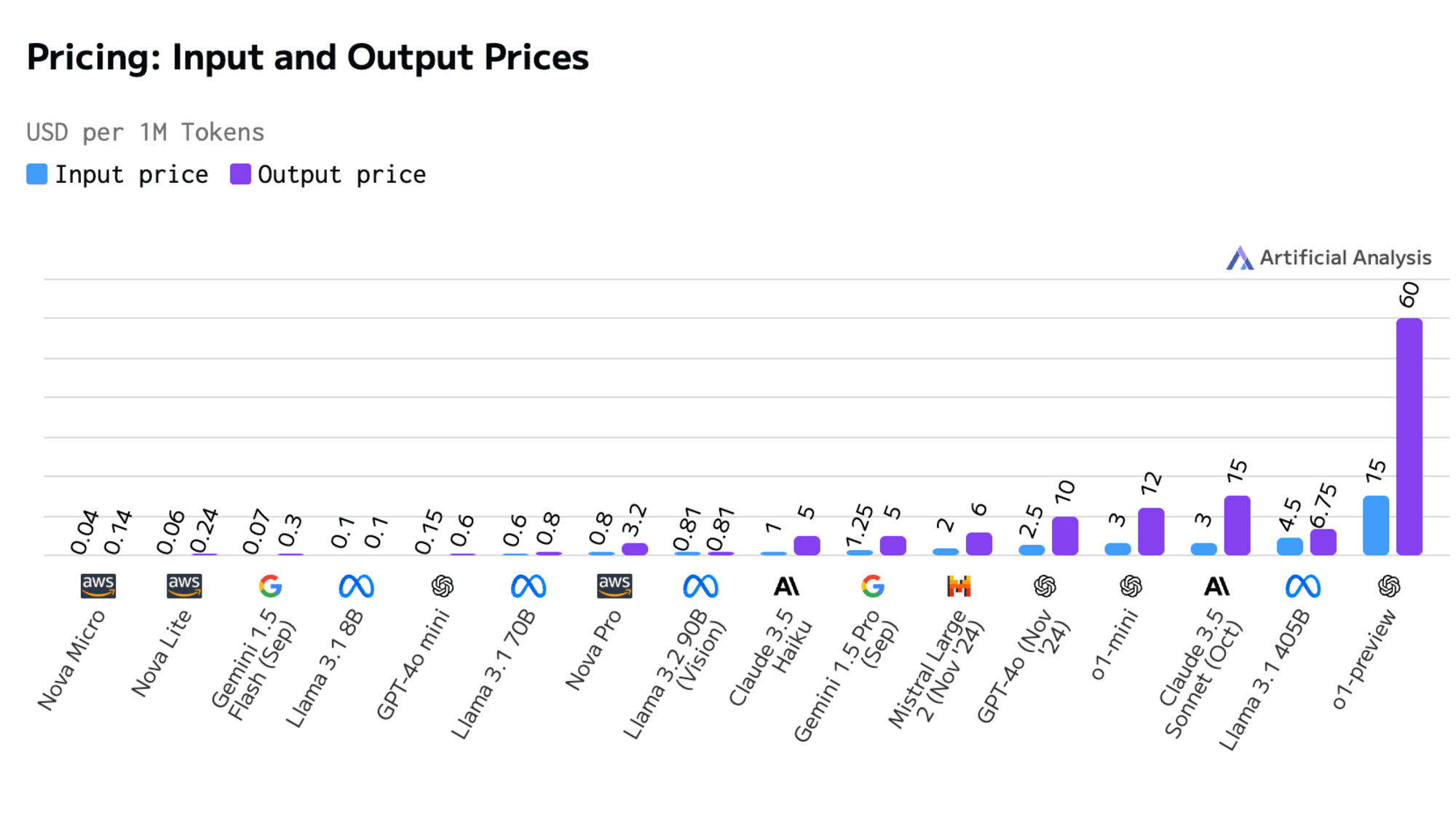

จากภาพด้านบน คือกราฟเปรียบเทียบระหว่าง Input Price (การป้อนข้อความ) และ Output Price (การตอบกลับข้อความ) ของ Tokens ต่างๆ จากเว็บไซต์ Artificial Analysis หากดูจากภาพ จะเห็นได้ว่า ราคาโมเดล AI ที่อยู่ทางซ้ายสุดของภาพจะมีราคาต่ำสุด

ซึ่งจุดที่น่าสนใจคือ Nova Pro ซึ่งเป็นโมเดล AI ที่มีประสิทธิภาพสูง แต่กลับมีราคาถูกกว่า Claude 3.5 Haiku อย่างน่าประหลาดใจ

เกี่ยวกับความเร็ว

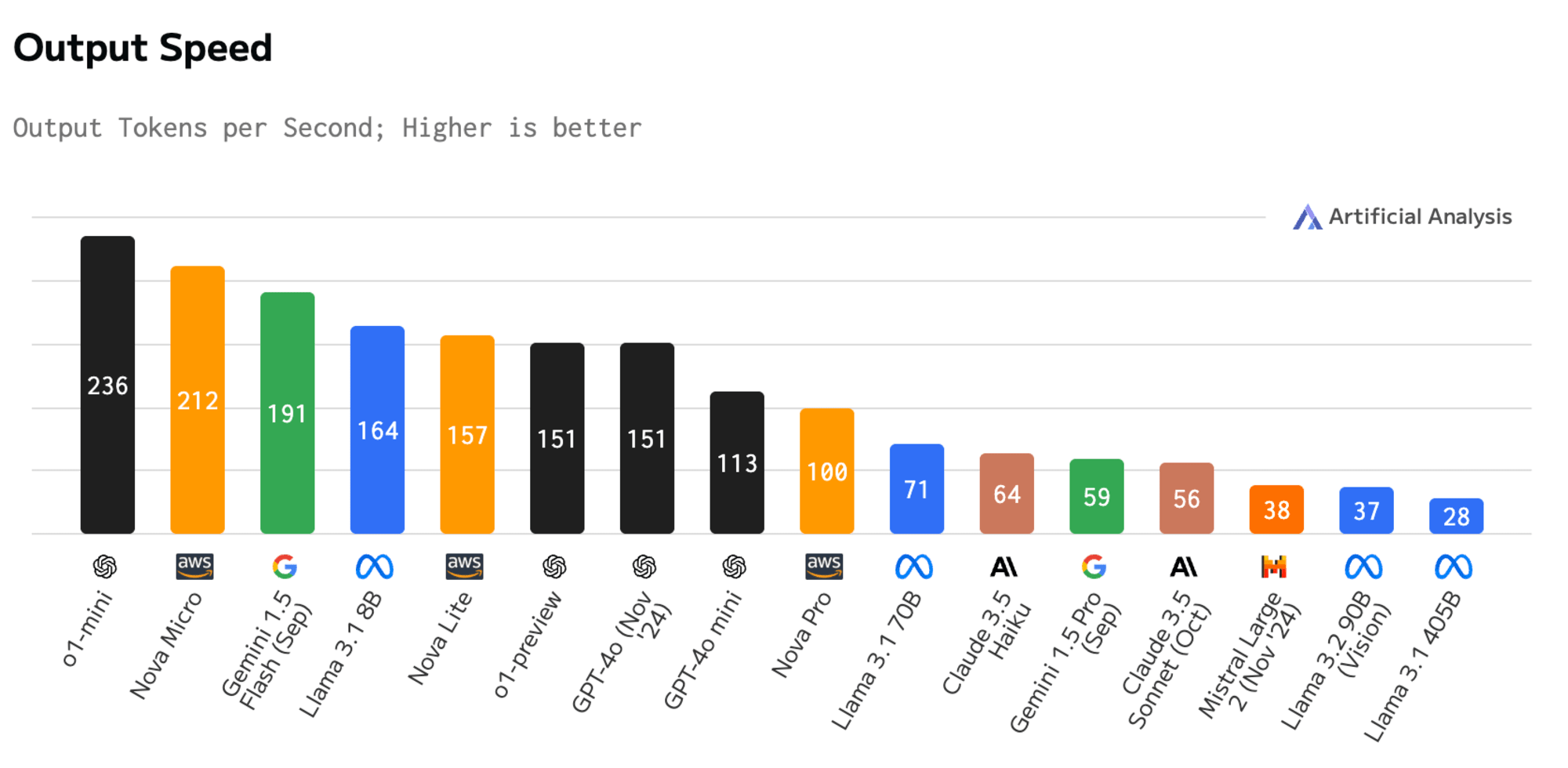

ความเร็วของ output

ดัชนีชี้วัดตัวนี้ แสดงความเร็วในการสร้างข้อความของโมเดล AI แต่ละตัว โดยวัดจากจำนวนคำที่สร้างได้ในหนึ่งวินาที

โดยโมเดล AI ที่อยู่ทางซ้ายสุดของภาพ จะมีความเร็วในการสร้างข้อความสูงสุด

จากการทดลองใช้ พบว่า Nova Micro สามารถประมวลผลได้เร็วและให้ข้อมูลได้จำนวนมาก

ทั้งนี้ ถ้า Nova Micro มีประสิทธิภาพในการตอบคำถามได้ดีพอ ๆ กับ o1-mini แต่สามารถทำงานได้เร็วกว่า คนก็อาจจะเลือกใช้ Nova Micro มากขึ้น โดยเฉพาะในงานที่ต้องการความเร็วในการตอบสนอง

ยกตัวอย่างง่าย ๆ

o1-mini = รถยนต์ที่มีกำลังแรงกว่า 🚘⚡

Nova Micro = รถยนต์ที่เบากว่า คล่องตัวกว่า 🏎️✨

ถ้าทั้งสองคันพาเราถึงจุดหมายได้เหมือนกัน แต่คันที่เบากว่าทำได้เร็วกว่า เราก็อาจเลือกใช้คันที่เบากว่านั่นเอง

นอกจากนี้ Nova Pro ก็มีประสิทธิภาพดีไม่แพ้กัน โดยติดอันดับ 1 ใน 10 ของโมเดล AI ที่มีความเร็วในการสร้างข้อความสูงสุด

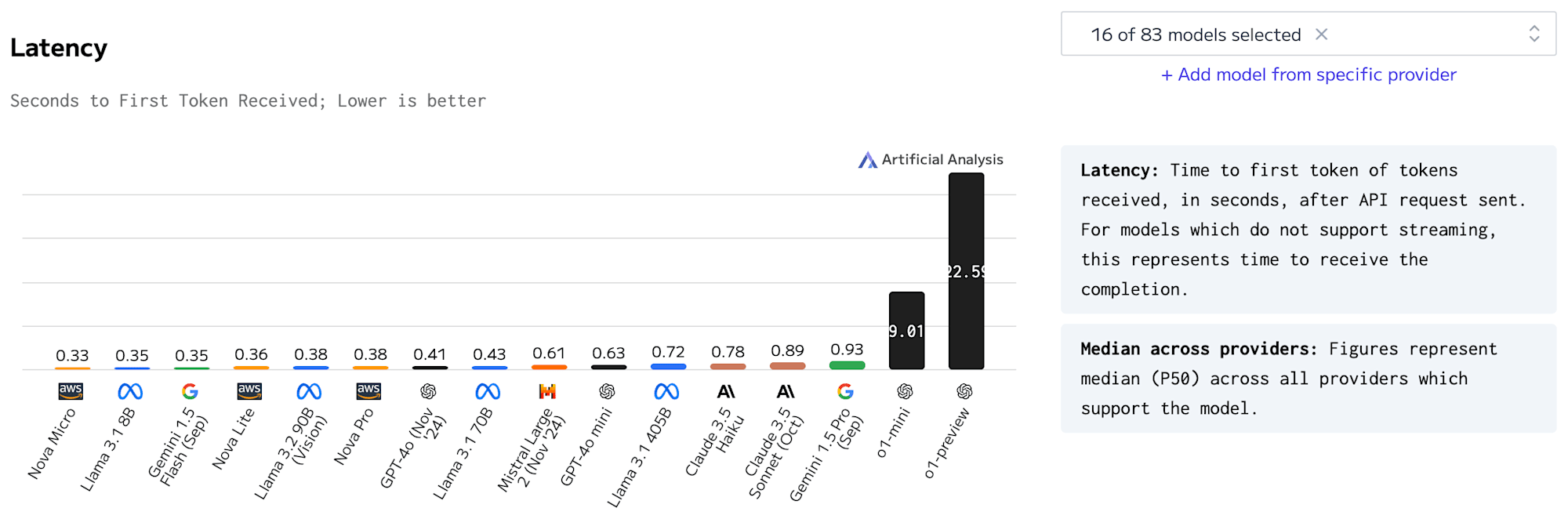

ความหน่วง

นี่คือดัชนีชี้วัด ที่วัดเวลาเป็นวินาทีตั้งแต่ส่งคำขอ API จนกระทั่งได้รับ Tokens แรก (ส่วนของTokens)

หรืออธิบายให้เข้าใจง่าย ๆ คือ เป็นการวัดความเร็วในการตอบสนอง โดยจับเวลาตั้งแต่เราส่งคำสั่งไป จนถึงได้รับคำตอบกลับมานั่นเอง

นอกจากนี้ หากดูจากภาพ จะเห็นได้ว่า Nova Micro มีค่าความหน่วงเวลา (Latency) ที่ต่ำกว่าโมเดล AI ตัวอื่นอย่างเห็นได้ชัด

Context Window

ดูข้อมูลเพิ่มเติมเกี่ยวกับโมเดลที่เรารองรับ

นี่คือ Context Window หรือขนาดความยาวสูงสุดของข้อความที่โมเดล AI สามารถประมวลผลได้ในครั้งเดียว โดยแต่ละโมเดลจะมีขนาด Context Window ที่แตกต่างกัน กล่าวคือ ยิ่ง Context Window มีขนาดความยาวมากเท่าไหร่ ก็จะสามารถประมวลผลข้อความที่ยาวขึ้นได้ในคราวเดียว และช่วยเพิ่มความต่อเนื่องของการสนทนาได้มากขึ้น

ทั้งนี้ ได้รวบรวมข้อมูลขนาด Context Window ของโมเดล AI แต่ละตัว ไว้ตามด้านล่างนี้

- Nova Micro : 130,000 Tokens

- Claude 3.5 Haiku : 200,000 Tokens

- Claude 3.5 Sonnet : 200,000 Tokens

- Nova Lite : 300,000 Tokens

- Nova Pro : 300,000 Tokens

- Gemini 1.5 Flash : 1,000,000 Tokens

- Gemini 1.5 Pro : 2,000,000 Tokens

จะเห็นได้ว่า ถึงแม้ Nova Lite และ Nova Pro จะมีขนาด Context Window ไม่เยอะเท่า Gemini 1.5

แต่ก็มีความสามารถในการรับข้อความยาว (Context Window) ถึง 300,000 Tokens ซึ่งถือว่าเยอะเลยทีเดียว

ประสิทธิภาพในการตอบคำถาม

หากดูจากภาพ ถึงแม้ว่า Nova Pro จะไม่ได้ถูกจัดให้อยู่ในโมเดลที่มีระดับประสิทธิภาพในการตอบคำถามสูงสุด แต่ก็ยังถูกจัดให้อยู่ในระดับต้น ๆ จึงประเมินได้ว่า Nova Pro มีประสิทธิภาพในการตอบคำถามที่ค่อนข้างดี

อย่างไรก็ตาม ประสิทธิภาพในการตอบคำถามจะขึ้นอยู่กับภาษาที่ใช้ และ Use case ต่าง ๆ ทำให้แสดงผลออกมาแตกต่างกัน เพราะฉะนั้น ก่อนตัดสินใจว่าโมเดลตัวไหนมีประสิทธิภาพในการตอบดีกว่ากัน ก็อยากให้พิจารณาในส่วนตรงนี้ด้วยเช่นกัน

เอกสารอ้างอิงเพิ่มเติม

เว็บไซต์ตรวจสอบภูมิภาค (Regions) ที่รองรับการใช้งานโมเดล AI (ปัจจุบันมีเฉพาะภูมิภาคเวอร์จิเนียตอนเหนือเท่านั้น)

คู่มือการใช้งาน โดยเว็บไซต์ทางการของ AWS

การเข้าถึงบริการสามารถทำได้ผ่านช่องทาง API ซึ่งประกอบด้วย

API สำหรับการเรียกใช้แบบพื้นฐาน (InvokeModel และ InvokeModelWith ResponseStream) และ API สำหรับการสนทนาแบบต่อเนื่อง (Converse และ ConverseStream)

โดยทั้งสอง API นี้สามารถนำไปประยุกต์ใช้งานได้ตามความต้องการของผู้ใช้

มีการรวบรวมข้อมูลเกี่ยวกับประเภทของเนื้อหาที่รองรับ และข้อจำกัดต่างๆ ในระบบ Multimodal

โดยสามารถอ่านเพิ่มเติมได้ที่เว็บไซต์นี้

บทส่งท้าย

ในบทความนี้ ได้เจาะลึกเกี่ยวกับ Amazon Nova - เทคโนโลยีสร้างข้อความอัจฉริยะ โดยอ้างอิงข้อมูลจากเว็บไซต์ Artificial Analysis ในด้านราคา, ความเร็ว, context window และประสิทธิภาพในการตอบคำถาม และวิเคราะห์จนมาเป็นบทความให้ทุกคนได้อ่าน

- ด้านราคา : เมื่อเปรียบเทียบเรื่องราคากับ โมเดล AI อื่น ๆ ที่เป็นคู่แข่ง พบว่า โมเดล AI Nova มีราคาที่ต่ำกว่าคู่แข่งมาก โดยเฉพาะ Nova Pro ที่เป็น โมเดล AI ประสิทธิภาพสูงแต่กลับมีราคาที่ต่ำอย่างน่าประหลาดใจ

- ด้านความเร็ว : Nova Micro สามารถทำงานด้วยความเร็วที่สูงมาก

นอกจากนี้ Nova Pro ก็ยังติดอันดับ 1 ใน 10 ในด้านความเร็วของ Output Speed

ซึ่งถือเป็นข้อได้เปรียบที่สำคัญสำหรับ Use case ที่ต้องการความเร็วในการตอบสนอง - Context Window : Nova Lite และ Nova Pro มีความยาวของ context window ถึง 300,000 Tokens ซึ่งสะดวกในการประมวลผลข้อความที่ยาวขึ้นได้ในคราวเดียว

- ประสิทธิภาพในการตอบคำถาม : Nova Pro ถูกจัดอันดับ ว่ามีประสิทธิภาพในการตอบคำถามอยู่ในอันดับต้น ๆ จึงประเมินได้ว่า Nova Pro มีประสิทธิภาพในการตอบคำถามที่ค่อนข้างดี อย่างไรก็ตาม ประสิทธิภาพในการตอบคำถาม จะขึ้นอยู่กับภาษาที่ใช้ และ Use case ต่าง ๆ ทำให้แสดงผลออกมาแตกต่างกัน เพราะฉะนั้น ก่อนตัดสินใจว่าโมเดลตัวไหนมีประสิทธิภาพในการตอบดีกว่ากัน ก็อยากให้พิจารณาในส่วนตรงนี้ด้วยเช่นกัน

⭑・゜゜・⭑・゜゜・⭑・゜゜・⭑

แม้นี่จะเป็นจุดจบของบทความ แต่การเจาะลึกเกี่ยวกับ Amazon Nova ของเรายังไม่จบแค่นี้แน่นอน ติดตามกันต่อได้ในครั้งหน้าครับ

แล้วพบกันใหม่ !