Amazon Q in ConnectでLLMがGUIで設定可能になりました

はじめに

Amazon Q in ConnectのAIプロンプトで選択する大規模言語モデル(LLM)がGUIで設定可能になりました。What's New with AWS などのAWSアップデート情報には記載されていませんが、実際の利用で確認できました。

2025年5月にAmazon Q in Connectで選択できるLLMが増えましたが、以下の記事で紹介したとおり、当時はモデルの変更をGUIで行うことができませんでした。

本記事では、このアップデート内容について確認します。

モデルの設定方法

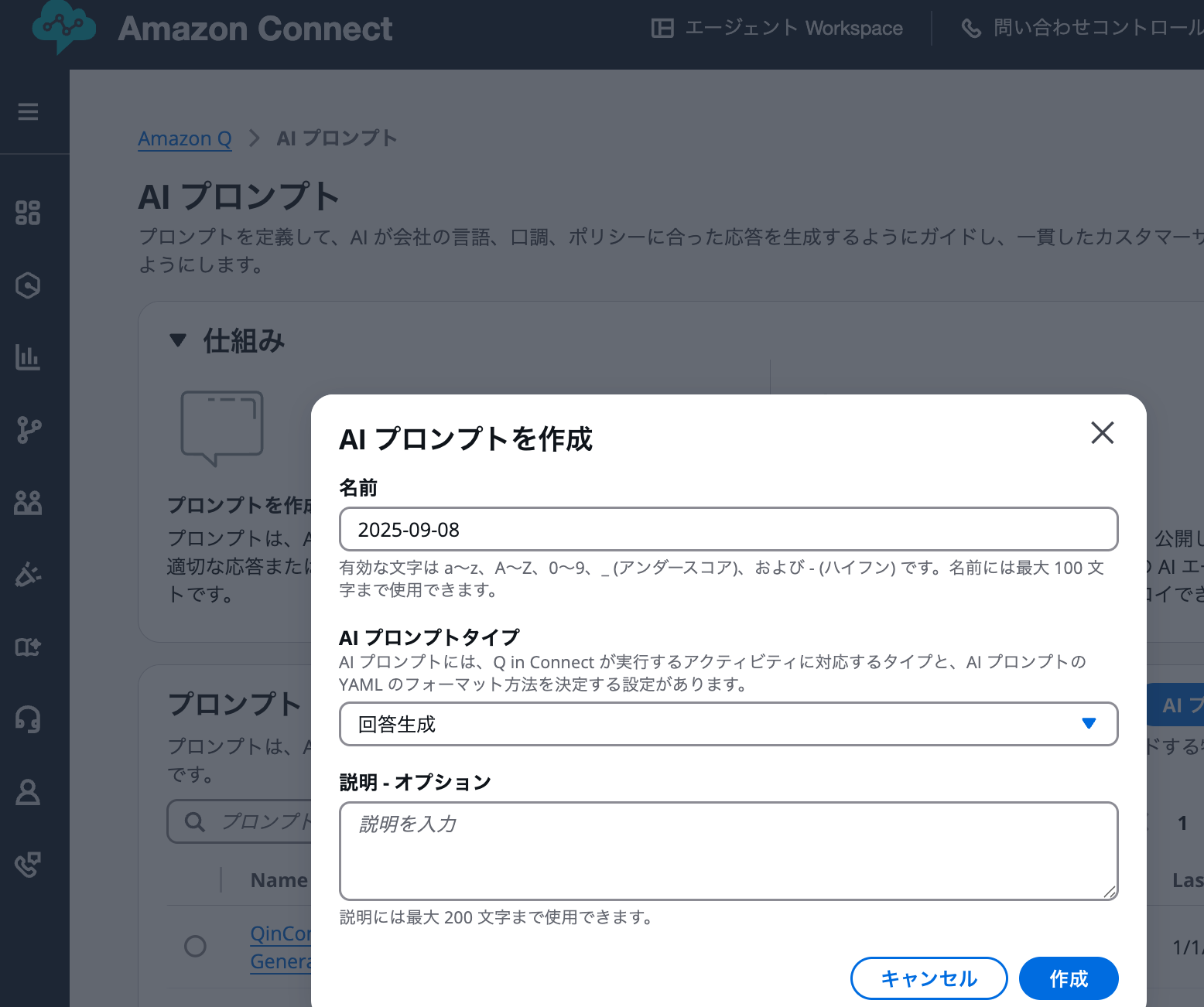

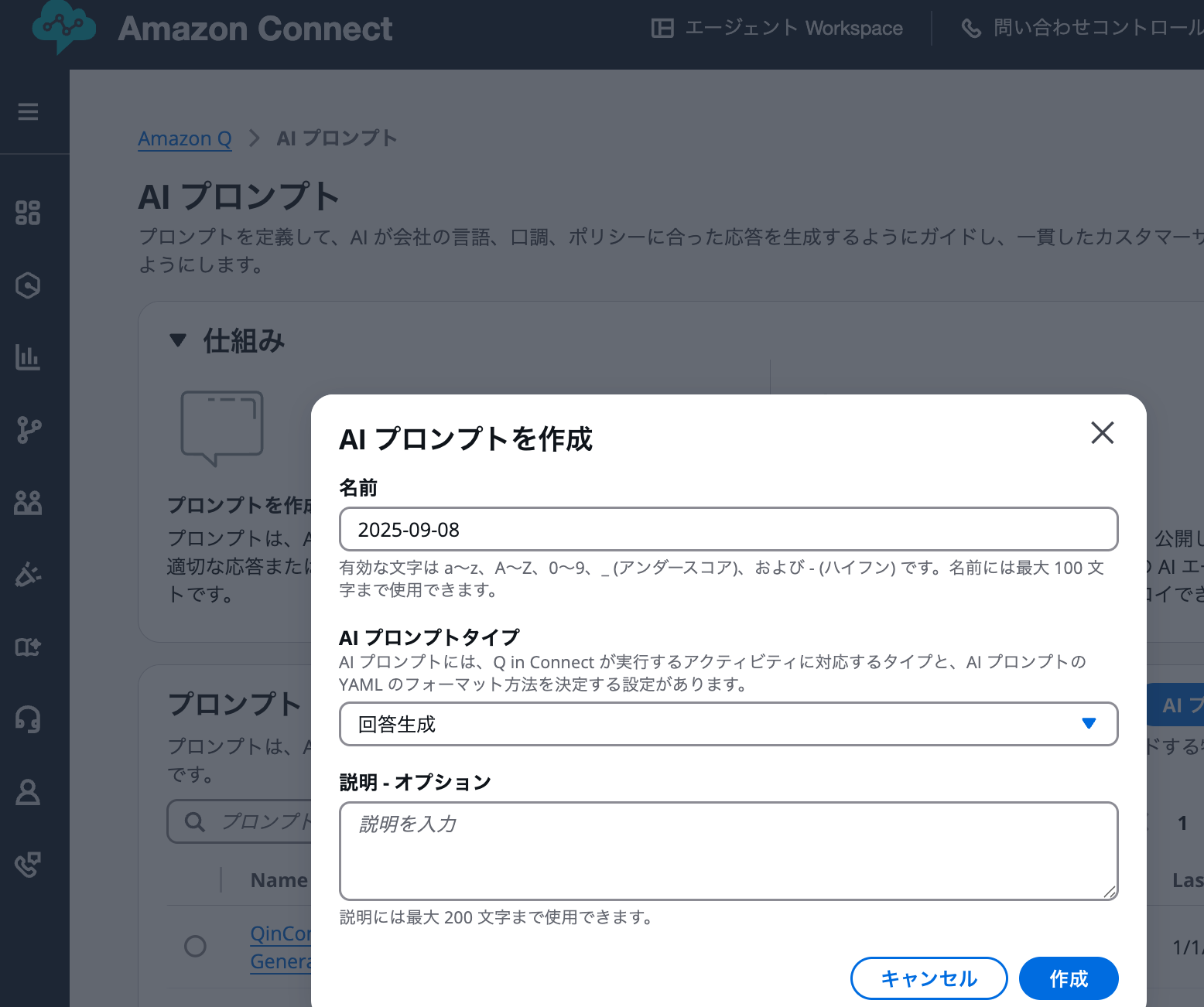

新規作成の場合

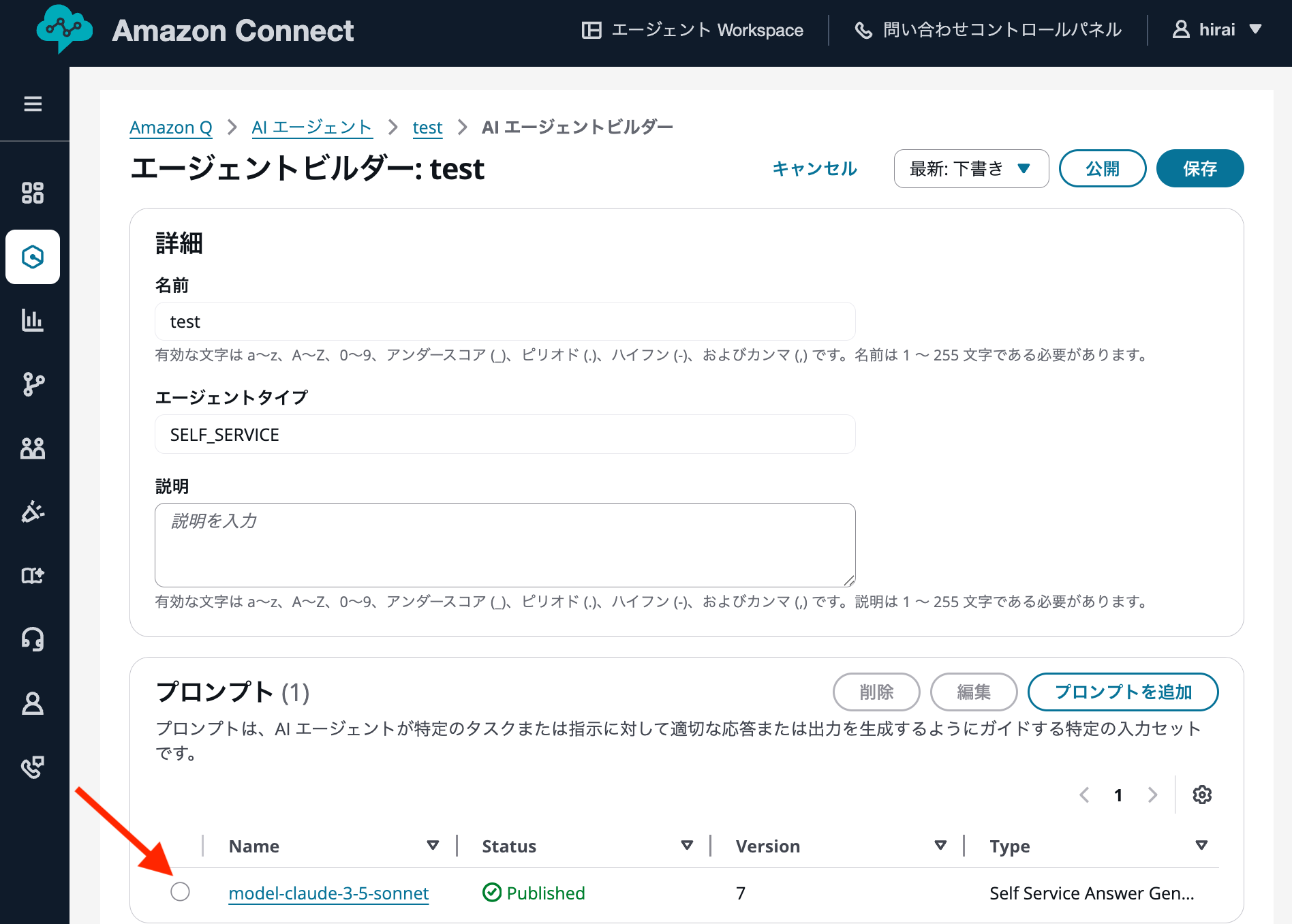

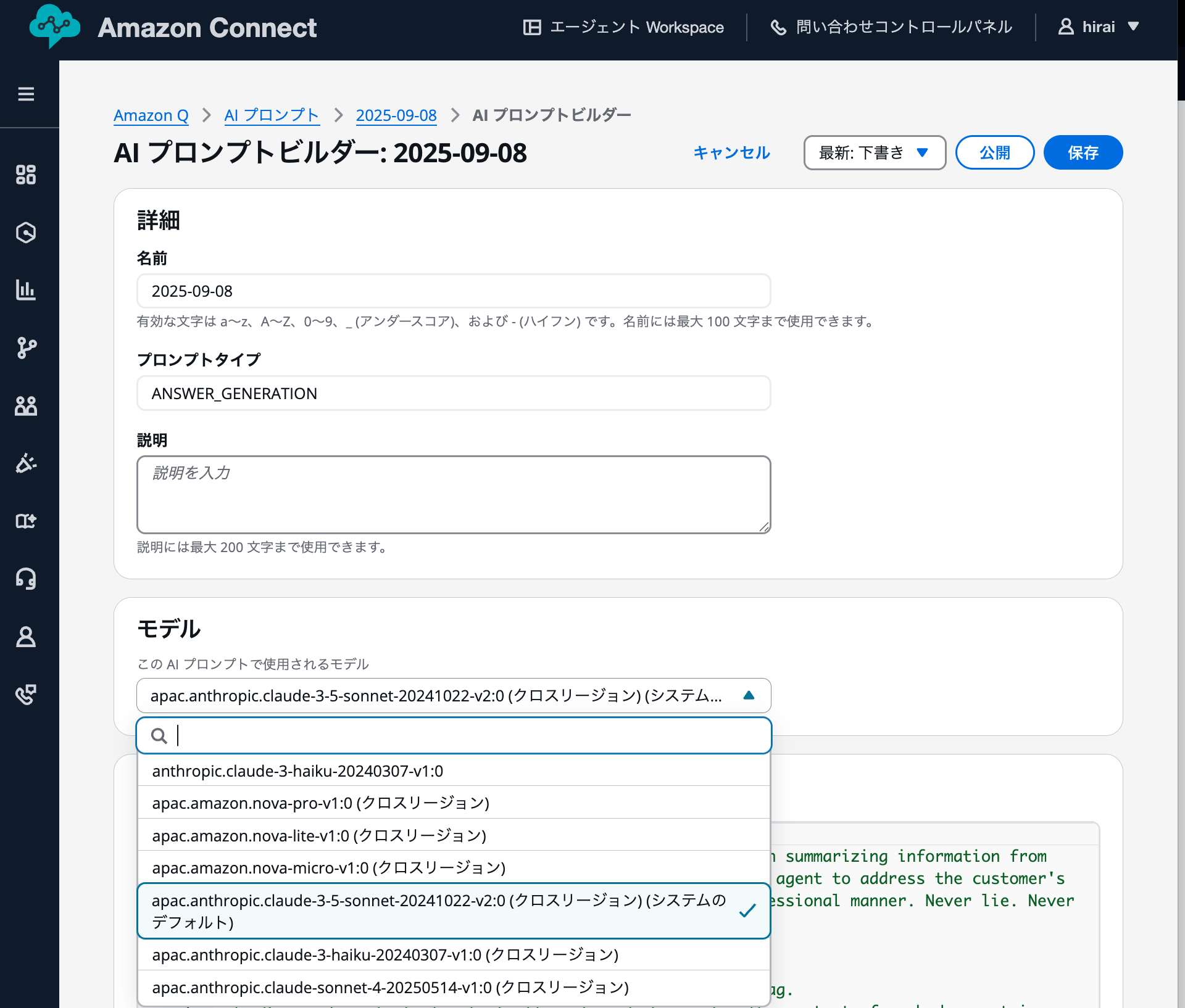

新規作成の場合、AIプロンプト作成後、AIプロンプトビルダーでGUIによるモデルが指定できました。

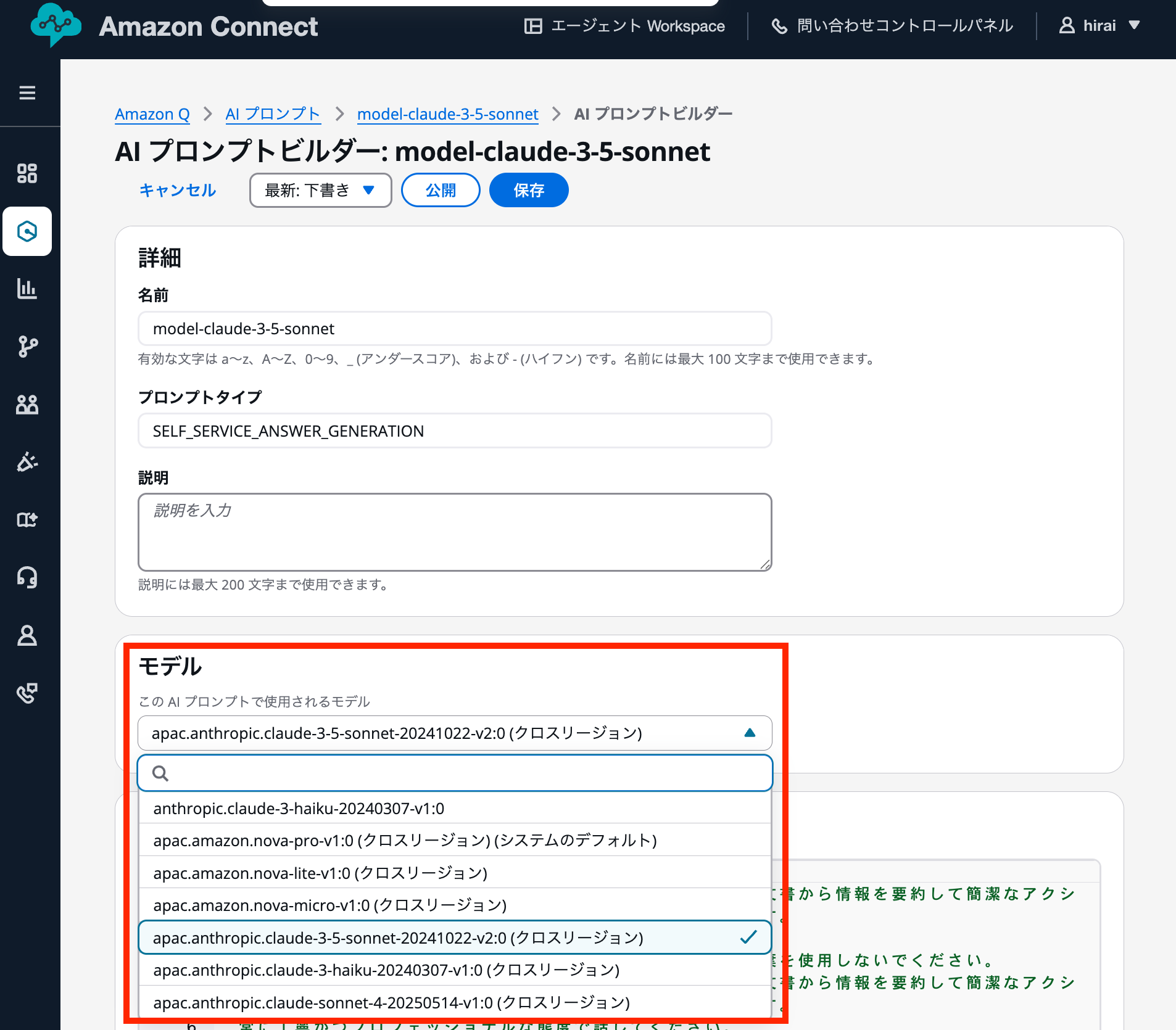

既存の場合

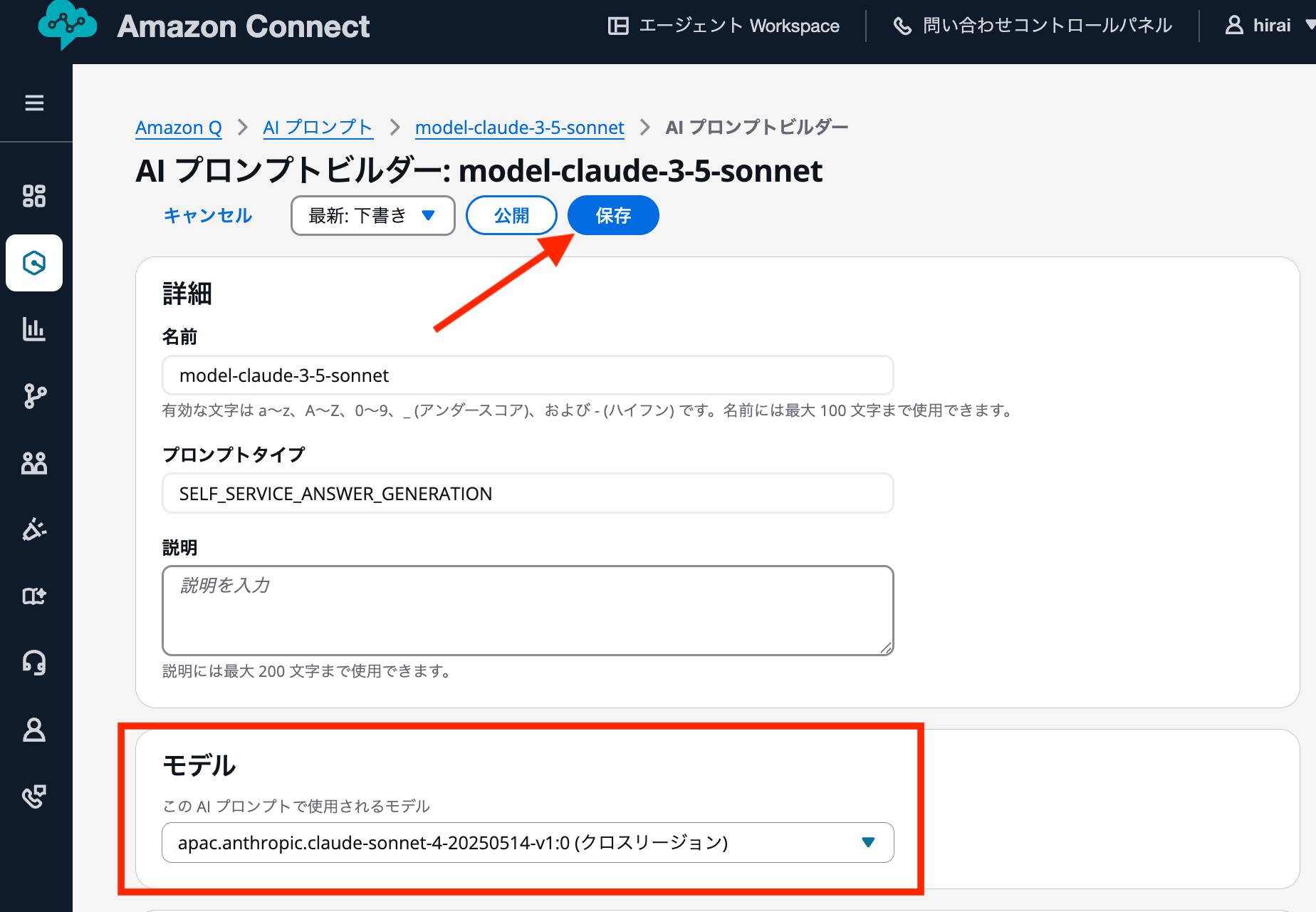

作成済みのカスタムAIプロンプトの場合も同様に、AIプロンプトビルダーでGUIでモデルを指定できました。

カスタムAIプロンプトでモデルを指定後、保存、公開します。(新しいバージョンが自動作成されます。)

カスタムAIエージェントで、作成したカスタムAIプロンプトのバージョンを指定し、保存、公開します。(新しいバージョンが自動作成されます。)

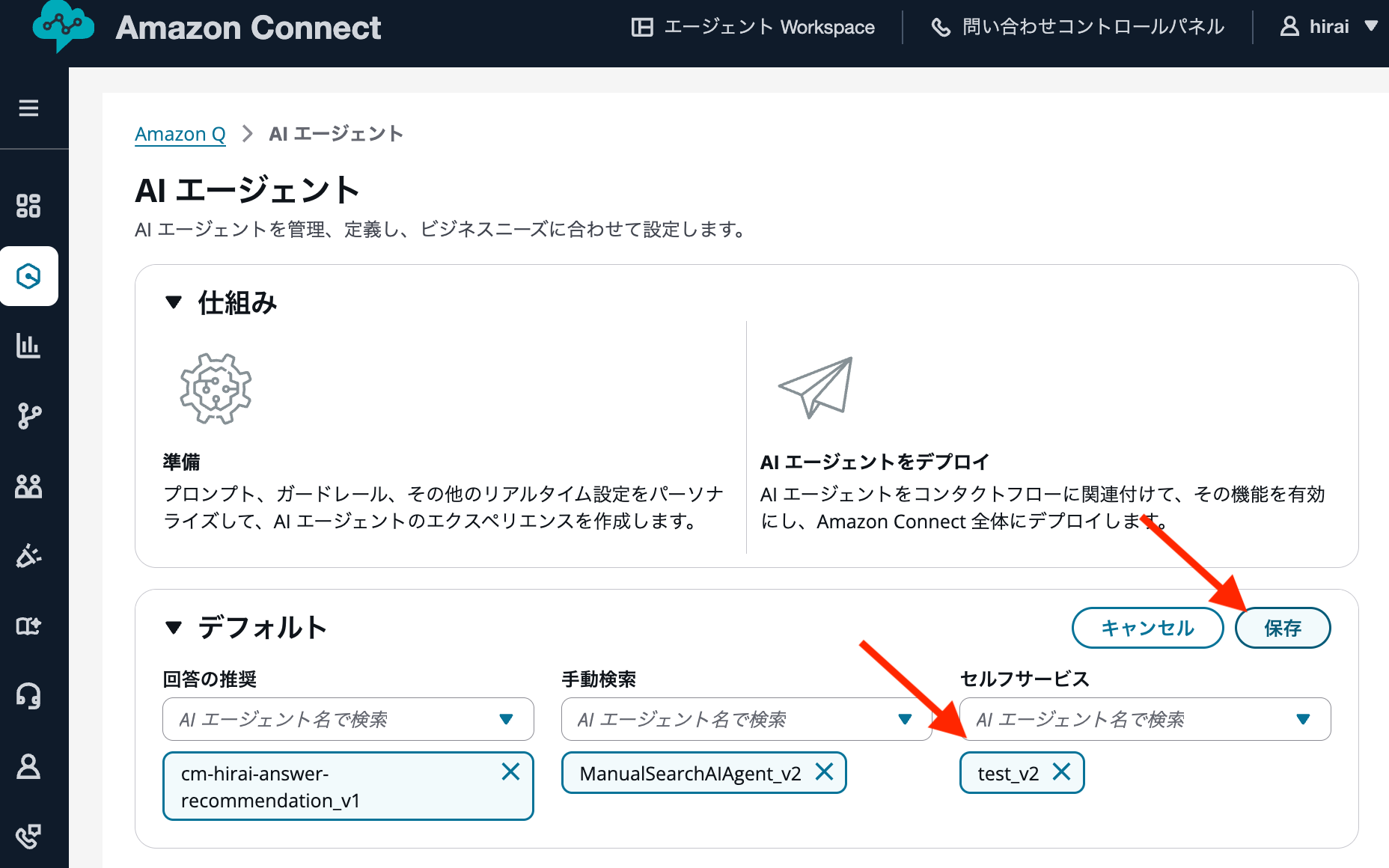

カスタムAIエージェントの最新バージョンを、デフォルトに設定することで、反映できます。

デフォルトのAIプロンプト

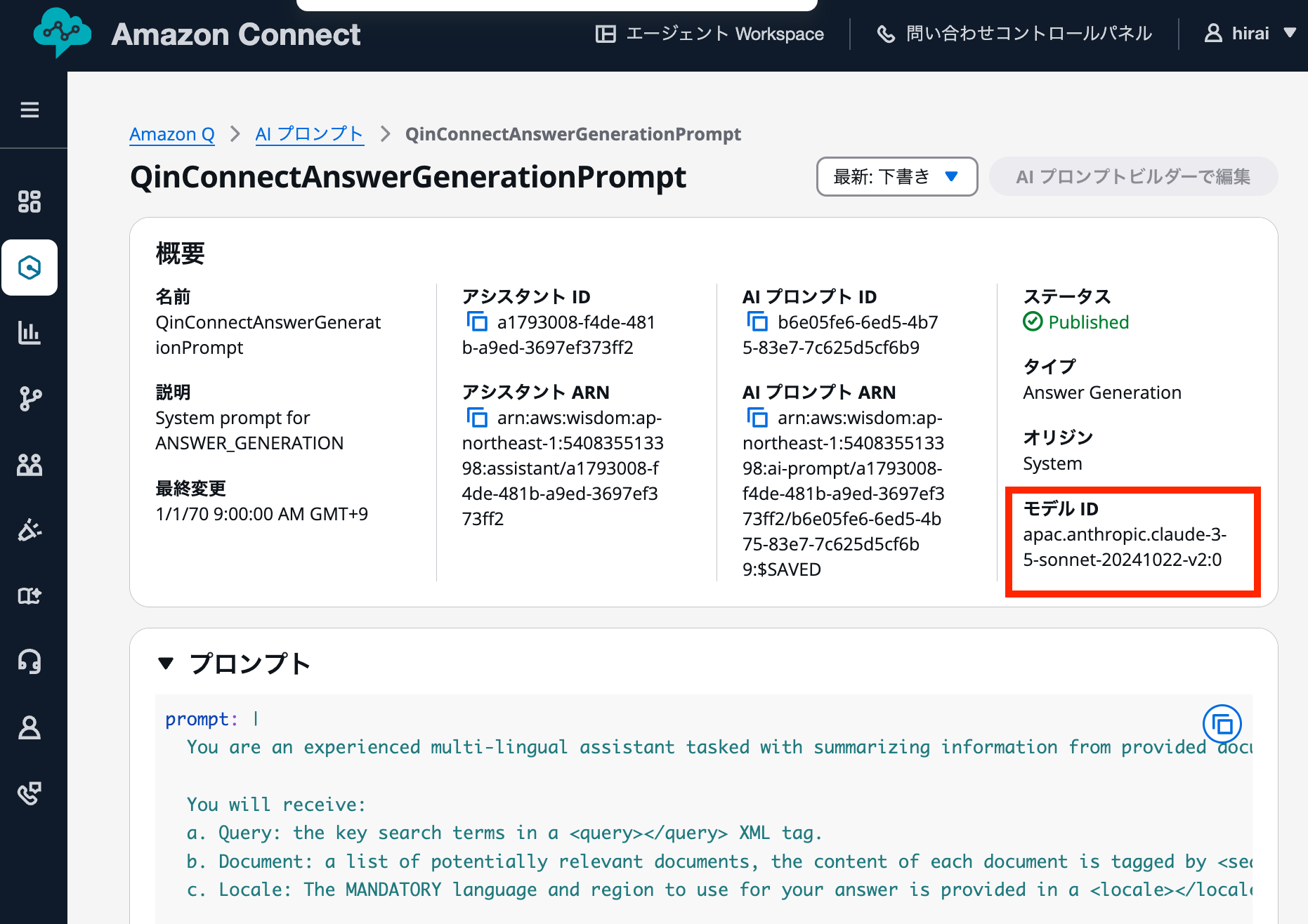

執筆時点でのデフォルトのAIプロンプトでは、AWSドキュメントには記載されていませんが、プロンプトごとに異なるモデルIDが設定されていました。

回答の推奨

- QinConnectAnswerGenerationPrompt

- タイプ:Answer Generation

- モデルID:apac.anthropic.claude-3-5-sonnet-20241022-v2:0

- QinConnectIntentLabelingGenerationPrompt

- タイプ:Intent Labeling Generation

- モデルID:apac.amazon.nova-lite-v1:0

- QinConnectQueryReformulationPrompt

- タイプ:Answer Generation

- モデルID:apac.amazon.nova-lite-v1:0

コンテンツ検索

- QinConnectAnswerGenerationPrompt

- タイプ:Answer Generation

- モデルID:apac.anthropic.claude-3-5-sonnet-20241022-v2:0

セルフサービス

- QinConnectSelfServiceAnswerGenerationPrompt

- タイプ:Self Service Answer Generation

- モデルID:apac.amazon.nova-pro-v1:0

- QinConnectSelfServicePreProcessingPrompt

- タイプ:Self Service Pre Processing

- モデルID:apac.amazon.nova-pro-v1:0

回答生成の部分にはAnthropic社のモデルが設定されており、その他はAmazon社のモデルが設定されています。

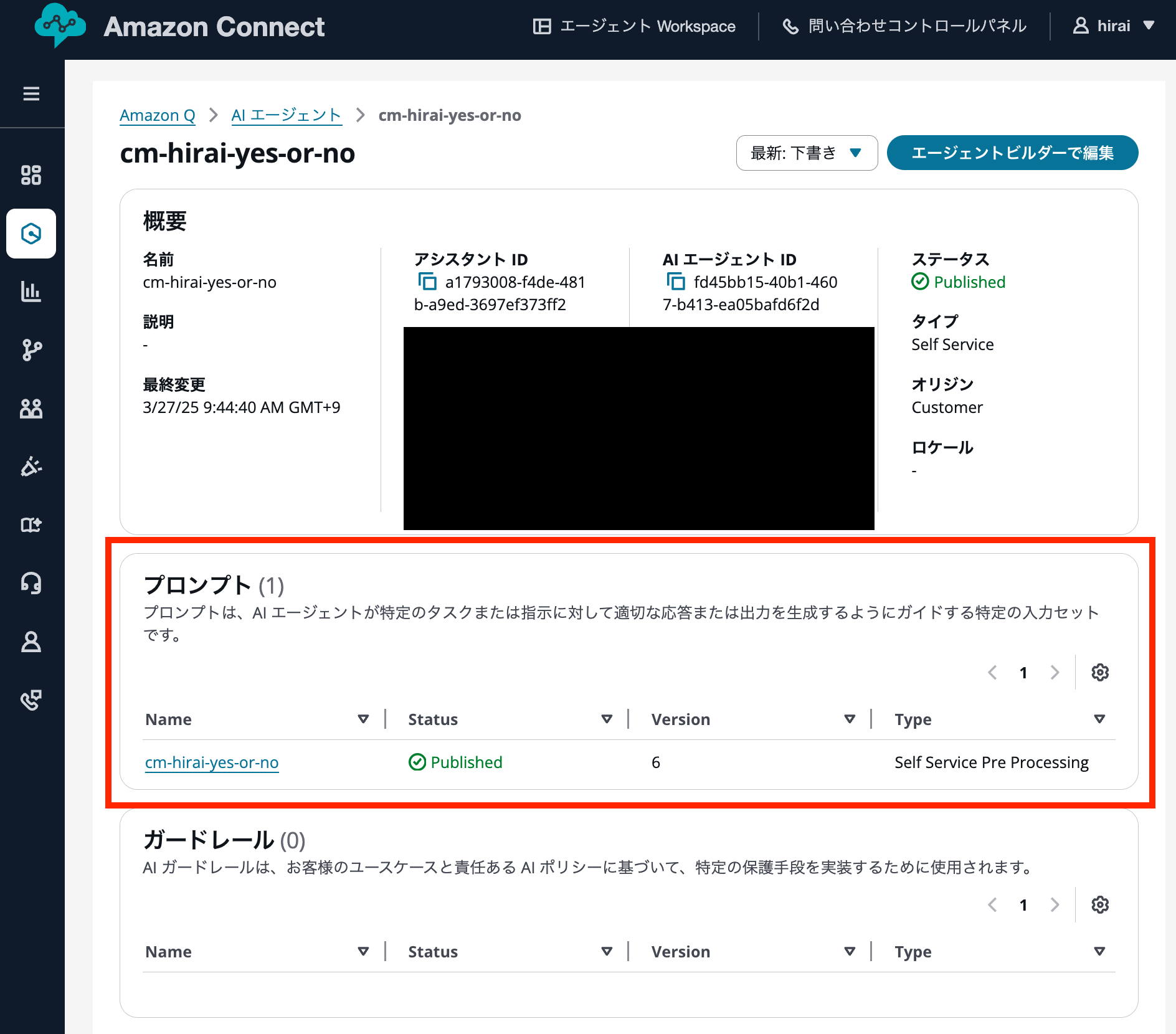

カスタムAIエージェントでの注意点

カスタムAIエージェントの場合、AIプロンプトを指定していないプロンプトタイプには上記のデフォルトAIプロンプトが適用されるため、設定内容を確認することをお勧めします。

デフォルトAIプロンプトはプロンプト内容が変更されることがあるため、基本的にはカスタムAIプロンプトですべて指定することを推奨します。

例えば、セルフサービスタイプのカスタムAIエージェントで「Self Service Pre Processing」はカスタムAIプロンプトを指定し、「Self Service Answer Generation」は指定していない場合を考えます。この場合、「Self Service Answer Generation」プロンプトタイプには上記のデフォルトAIプロンプトが適用されます。

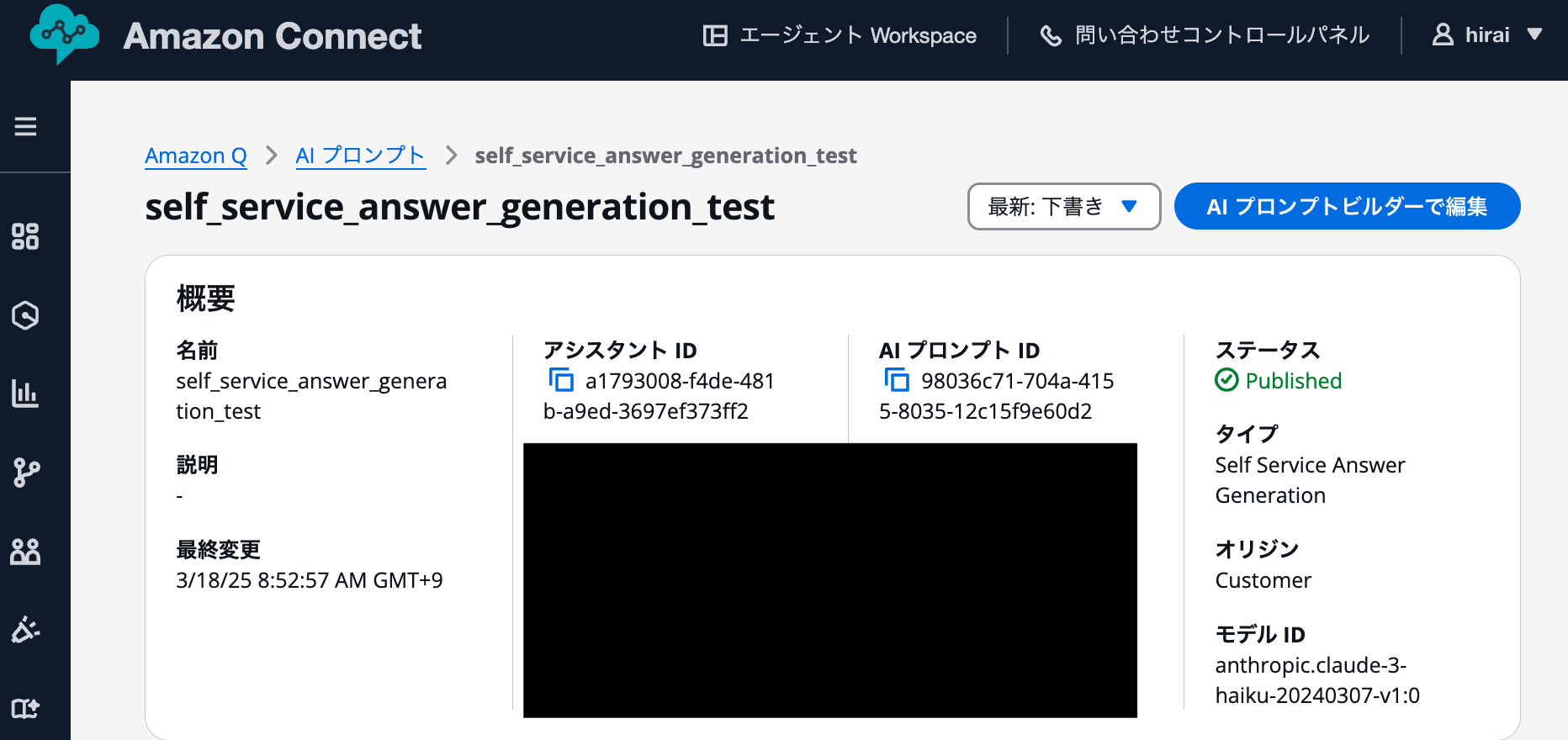

アップデート前のカスタムAIプロンプトの確認

LLMがanthropic.claude-3-haiku-20240307-v1:0のみだった2025年3月頃の「Amazon Q in ConnectのAIプロンプトなどの設定が管理画面からカスタマイズできるようになりました」という記事で作成したカスタムAIプロンプトは、当然ながらLLMがanthropic.claude-3-haiku-20240307-v1:0でした。

現在のカスタムAIプロンプトのデフォルトモデル

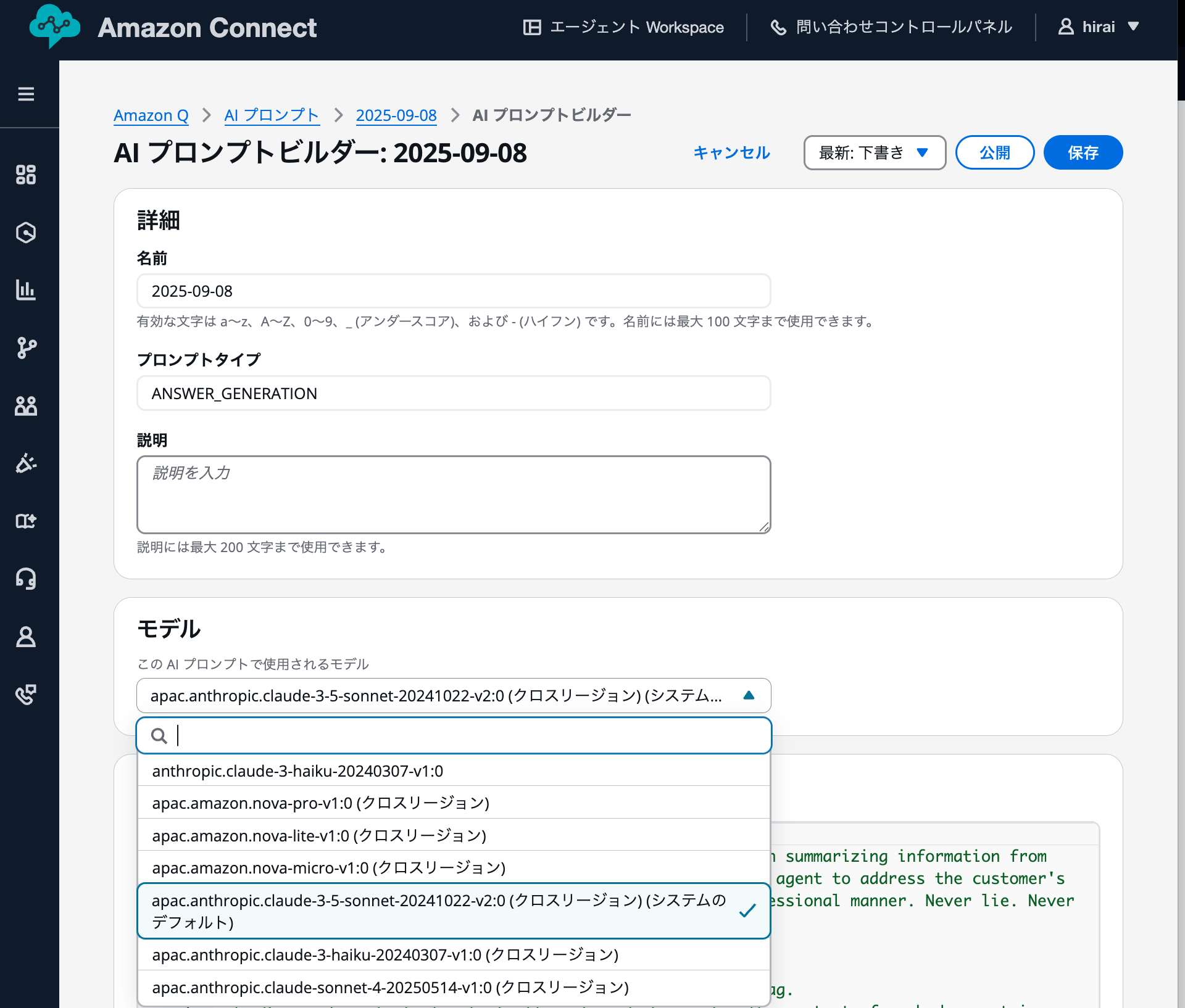

複数のLLMが選択できるようになった現在、カスタムAIプロンプトを作成する際のデフォルトモデルを確認しました。

例えば、プロンプトタイプがANSWER_GENERATIONの場合、デフォルトのAIプロンプトと同様にClaude 3.5 Sonnetが設定されていました。

- apac.anthropic.claude-3-5-sonnet-20241022-v2:0 (クロスリージョン) (システムのデフォルト)

他のAIプロンプトタイプも確認しましたが、デフォルトAIプロンプトと同じモデルが指定されていました。

回答の推奨

- QinConnectAnswerGenerationPrompt

- タイプ:Answer Generation

- モデルID:apac.anthropic.claude-3-5-sonnet-20241022-v2:0

- QinConnectIntentLabelingGenerationPrompt

- タイプ:Intent Labeling Generation

- モデルID:apac.amazon.nova-lite-v1:0

- QinConnectQueryReformulationPrompt

- タイプ:Answer Generation

- モデルID:apac.amazon.nova-lite-v1:0

コンテンツ検索

- QinConnectAnswerGenerationPrompt

- タイプ:Answer Generation

- モデルID:apac.anthropic.claude-3-5-sonnet-20241022-v2:0

セルフサービス

- QinConnectSelfServiceAnswerGenerationPrompt

- タイプ:Self Service Answer Generation

- モデルID:apac.amazon.nova-pro-v1:0

- QinConnectSelfServicePreProcessingPrompt

- タイプ:Self Service Pre Processing

- モデルID:apac.amazon.nova-pro-v1:0

なお、以下の記事で紹介したとおり、現在はapac.anthropic.claude-sonnet-4-20250514-v1:0 (クロスリージョン)が利用できるため、apac.anthropic.claude-3-5-sonnet-20241022-v2:0ではなく、こちらを選択することをお勧めします。

最後に

GUIでLLMモデルを選択できるようになったことで、検証時のモデル比較が容易になり、開発効率が向上しました。

カスタムAIエージェントを使用する場合は、AIプロンプトを指定していないプロンプトタイプにはデフォルトAIプロンプトが適用されるため、設定内容を必ず確認してください。

デフォルトAIプロンプトはプロンプト内容が変更される可能性があるため、基本的にはカスタムプロンプトですべて指定することを推奨します。

また、基本的には次世代バージョンのモデル(Claude Sonnetの場合、3.5から4など)を選択することで、より高い性能を期待できます。