DevelopersIO 2025 Sapporo で「今、GPU が熱い それを冷やす技術」というタイトルで登壇させていただきました #devio2025

2025 年 9 月 26 日開催された DevelopersIO 2025 Sapporo にて「今、GPU が熱い それを冷やす技術」をテーマにお話させていただきました。

セッションスライド

セッション内容概要

当日お話させて頂いた点を掻い摘んで紹介します。

GPU の温度が熱い

生成 AI ブームの中、多くの人たちが生成 AI を使ったり、とある人たちは生成 AI のモデルを作ったりすると GPU は大忙しです。その GPU を使うと生まれる熱をどう冷やしているのか、別に知らなくても良いことを紹介しました。

最近の GPU サーバー

1 ラックに 72 個の最新の GPU を搭載しており、ラック全体が 1 つの巨大な GPU として動作します。GPU メモリが 13TB もあるモンスタースペックになっています。

AWS をはじめ、Google Cloud、Azure 主要なパブリッククラウドでこの GPU マシンが利用可能となっています。

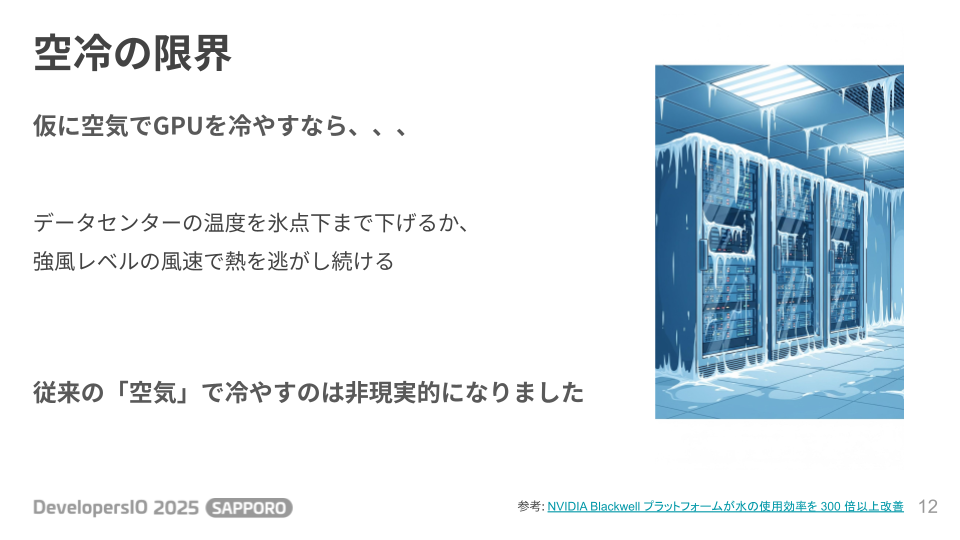

最新のハイエンド GPU を 72 個も動かすとなると消費電力が 1 ラックで約 120kW もあります。

120kW を身近なもので例えると、家庭用ドライヤーおよそ 100 台分に相当します。これが常にフルパワーで稼働している感じです。

この熱量を従来の空気で冷やすのは厳しくなりました。もし空冷するならデータセンターを氷点下にするか、強風レベルの風を当て続けるしかなく、物理的に難しい状況です。

液体冷却

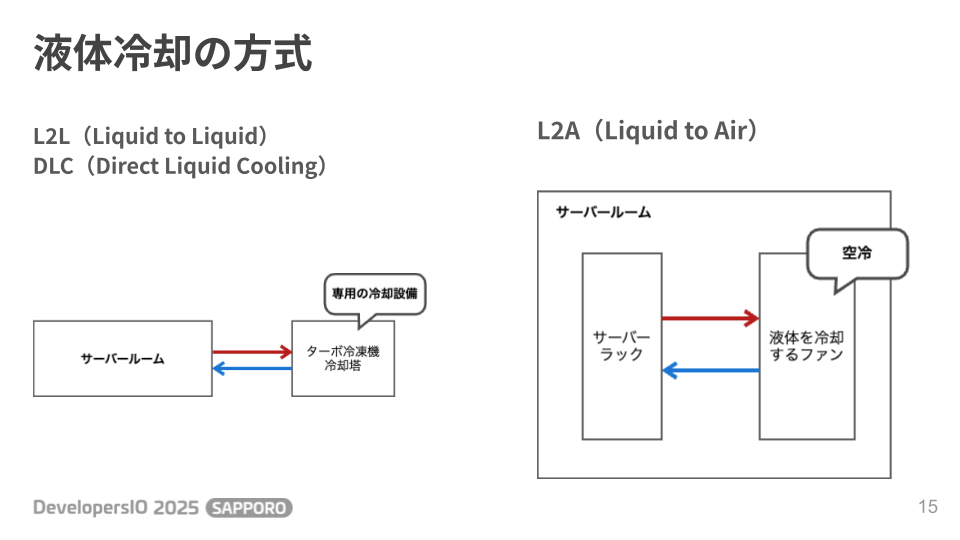

今、GPU の冷却に採用されているのは液体冷却です。液体の種類にもよるのですが、液体は空気の約 1000 倍の密度を持ち、運べる熱は空気の 3560 倍もあり圧倒的に効率が良いです。液体冷却にはいくつか方式があります。1 つは液体を液体で冷やす L2L や DLC です。これはサーバールームの外に専用の冷却設備があって実現できる、大掛かり仕組みです。これはデータセンター側が設備を持っていないと導入できないです。もう 1 つは、熱源を液体で冷やして、熱くなった液体自体は空気で冷やす L2A という方式です。これは機材を用意すればサーバールーム内で完結します。冷却効率が高いのはもちろん大掛かりな仕組みが必要な左側の L2L です。今回は右側の L2A 方式に注目します。

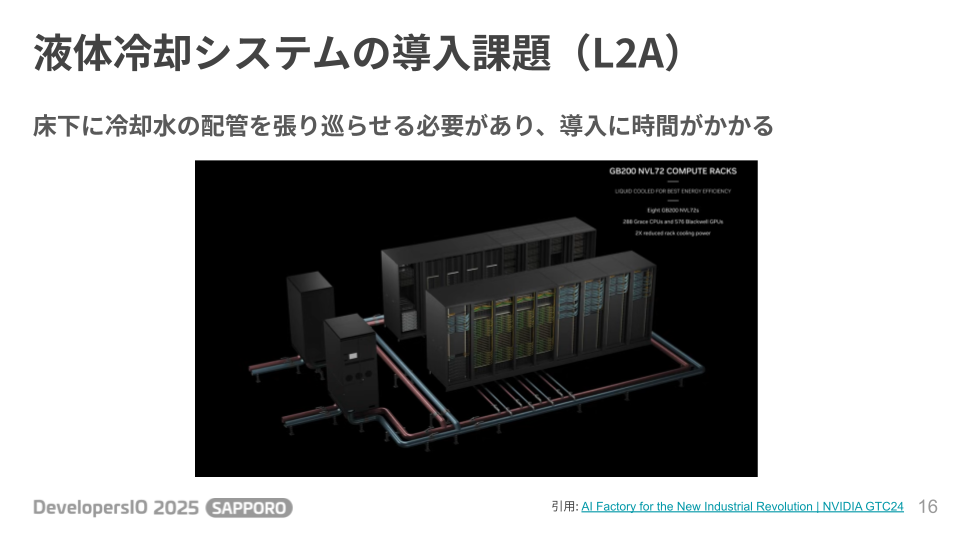

従来の L2A の液体冷却方式は、この図のように冷却水用の配管を床下に通す必要があり、導入には時間もコストがかかります。

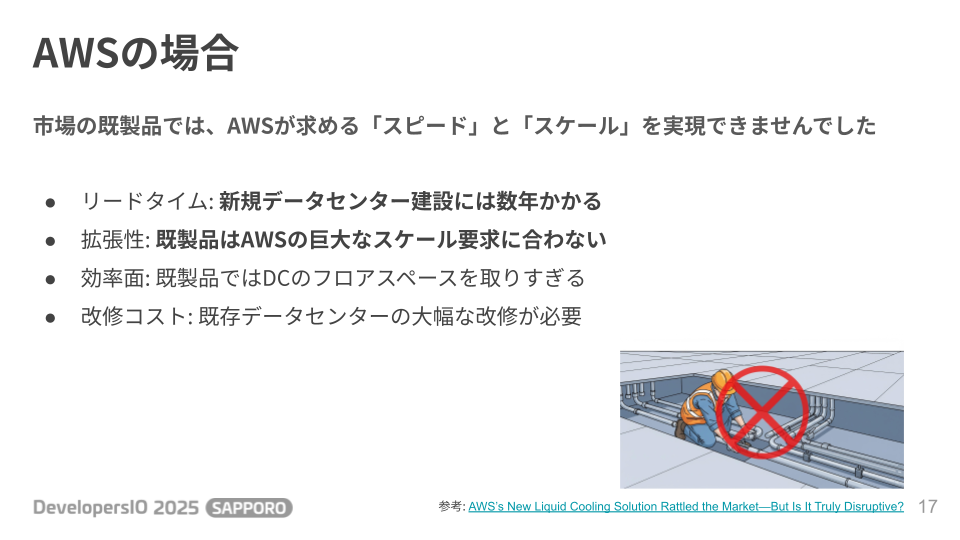

AWS さんの場合は市場の既製品では、彼らが求めるスピードと、スケール要件を満たせませんでした。

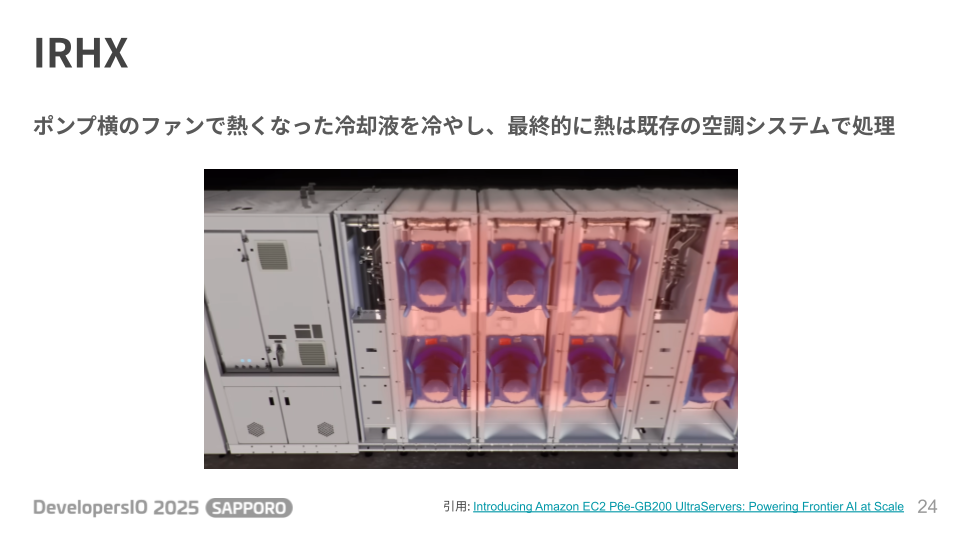

AWS さんは液体冷却システムを自作する道を選びました。それで生まれたのが今回紹介したい IRHX(In-Row Heat Exchanger)です。

設計思想としては、ラックのためにデータセンターを設計する必要がないと紹介されていました。データセンター側の設備を手を加えるのではなく、液体冷却システムのハードウェアをデータセンター側に最適化していく方向性でした。パブリッククラウドベンダーの場合は、世界各国のデータセンターを借りている都合、既存のデータセンターを上手く活用できないと GPU サーバーの導入が進まない背景があるように思えました。

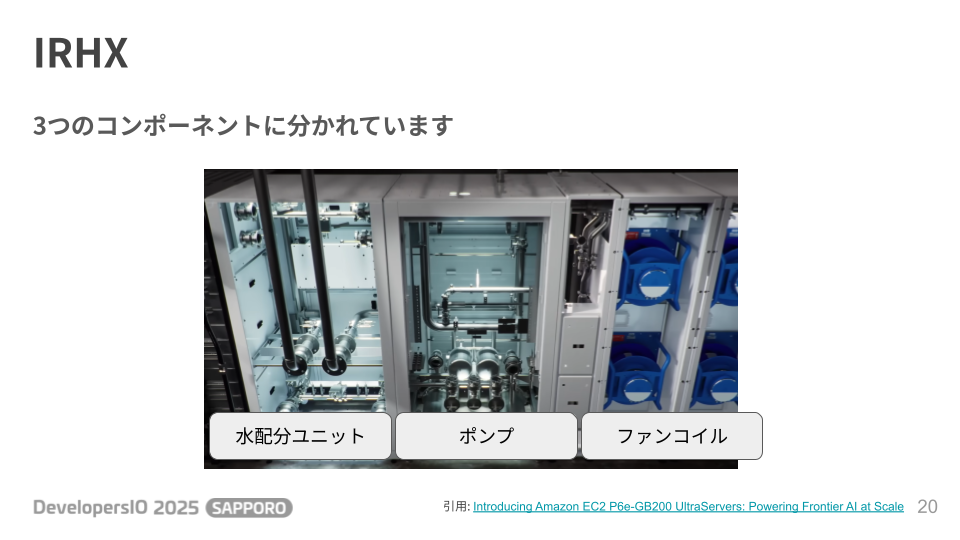

3 つのコンポーネントに分かれていて、水配分ユニットと呼ばれる冷たい液体と、温まった液体を流れるハイプを持っています。あとは、ポンプと、冷却用のファンです。これらは標準的なラック寸法に合わせて設計されているので導入の手間も少ないそうです。

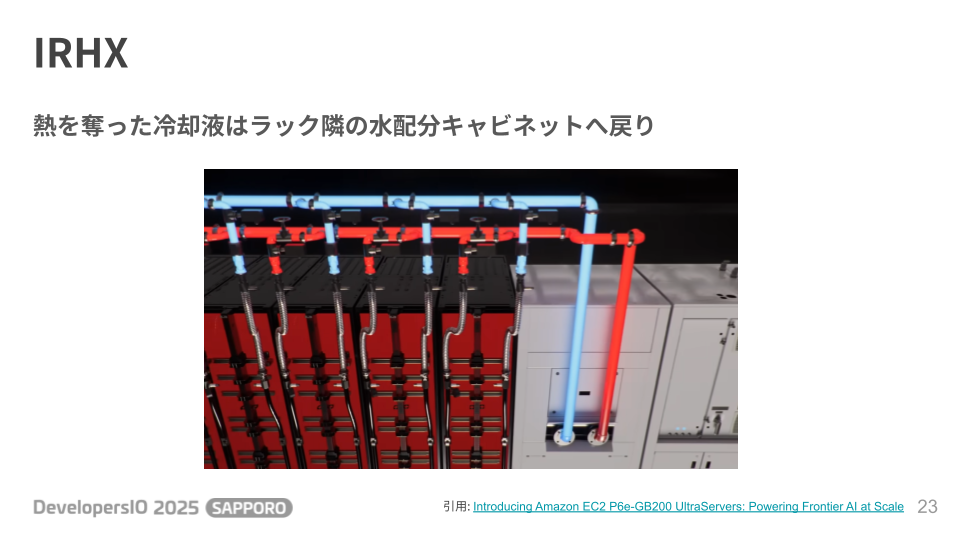

サーバラック横の水配分キャビネットからサーバーラックへ直接配管しています。私はここ 10 年データセンターに行ってないので最近の事情がわからないのですが、こんな大胆な設備が許されるなら床下に配管通したくないのは誰だってそうなのではというお気持ちです。

ポンプから送り出された冷たい冷却液はコールドプレートと呼ばれる、GPU のチップに熱伝導率の高い金属を接触させ、金属内部に設けた管状の流路に冷却液を通して熱を素早く奪います。ここだけが液体冷却です。ピンポイントで GPU のチップだけに液冷冷却システムが使われています。 このサーバー自体は GPU 以外にも CPU や、ネットワークスイッチが搭載されているのですが、一般的なサーバーと同じ様にファンがついていて空冷も併用されています。

熱を奪い温まった冷却液は水配分ユニットへ戻ってきます。

ポンプ横の専用の大型ファンで冷却液を冷やします。最終的に熱はファンでラック外に排出するので、あとはデータセンターの空調設備に任せることになります。データセンター側の空調設備が大量の排熱に耐えられるかはまた別の問題になるのですが、GPU の発熱だけは液体で素早く熱を奪い続け、あとは従来の空冷式で冷やすという、既存のデータセンター設備を活かした効率良い仕組みになっています。

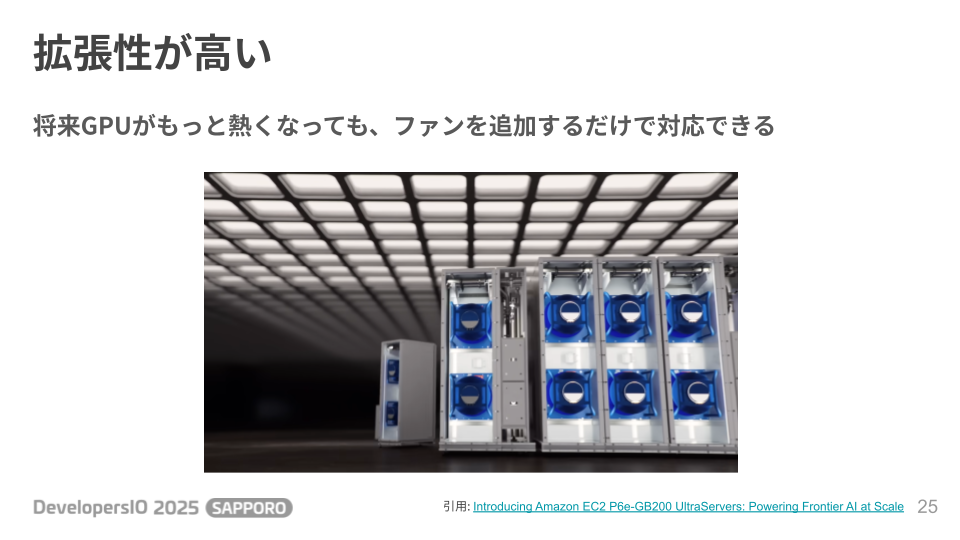

個人的に興味深かったのは、このファンはモジュール式で後から増減可能です。将来もっと発熱がすごい GPU がでてきてもファンを追加すれば冷却力をあげて対応できるし、技術革新がおきて省電力でハイパワーな GPU がでてきてもファンを減らせば、スペースを削減できる液体冷却システムになっています。ハードウェアもスケーラブルな設計でさすが AWS さんと思いました。

生成 AI ブームにより GPU の需要が高くなり、その結果 GPU は高性能化し、消費電力と発熱が上がり、空冷では排熱が追いつかなくなりました。

最新の GPU には液体冷却システムが必要となり、AWS の場合は独自設計の IRHX と呼ばわれる液体冷却システムを開発して導入している状況です。

おわりに

登壇時間は 10 分ということで駆け足しでの紹介になりました。ご来場いただいた皆さまありがとうございました。久々にデータセンターを調べていたら、最新のデータセンターへ見学行きたくなりました。

参考

- サーバーの「液体冷却」技術、GPUの消費電力急増で不可欠な存在に(2ページ目) | 日経クロステック(xTECH)

- CTCの水冷ソリューション|AIサーバなどの効率的な冷却方式をご提案

- エクイニクスのTY15は低遅延も電力密度も液冷も全部入り 安定の横綱相撲だった - 週刊アスキー

- AWS’s New Liquid Cooling Solution Rattled the Market—But Is It Truly Disruptive? - Dell'Oro Group

- Economy | The 2025 AI Index Report | Stanford HAI

- NVIDIA、GB200 NVL72と液冷システムでデータセンターの水使用効率が300倍向上 - PC Watch

- AI基盤/GPUサーバーに対応した「高電力データセンター」の選び方|ICT Digital Column 【公式】NTTPCコミュニケーションズ