![[2025年7月23日号]個人的に気になったModern Data Stack情報まとめ](https://images.ctfassets.net/ct0aopd36mqt/wp-thumbnail-4c47f61cc8c1b97c00c0efcc68eab01b/ebc4f0c0223a249eae2f9de257dedbcd/eyecatch_moderndatastack_1200_630.jpg?w=3840&fm=webp)

[2025年7月23日号]個人的に気になったModern Data Stack情報まとめ

さがらです。

Modern Data Stack関連のコンサルタントをしている私ですが、Modern Data Stack界隈は日々多くの情報が発信されております。

そんな多くの情報が発信されている中、この2週間ほどの間で私が気になったModern Data Stack関連の情報を本記事でまとめてみます。

※注意事項:記述している製品のすべての最新情報を網羅しているわけではありません。私の独断と偏見で気になった情報のみ記載しております。

Modern Data Stack全般

「Data Engineering Study #30~祝30回!過去登壇者と振り返るデータエンジニアの技術とキャリアのこれまでとこれから~」が開催

Data Engineering Study #30が開催されました。30回目の節目ということで、過去に登壇いただいた方々10名を再びお迎えし、当時語っていただいた技術的な取り組みやご自身のキャリアの「その後」について5分間のLT形式で開催されました。

Data Engineering Study #30の詳細としては、以下のイベントレポートが大変参考になると思います。こちらも併せてご覧ください。

また、これまでゆずたそさんがData Engineering Studyのアドバイザーを務められていたのですがこの#30をもって勇退されることになり、新しくアドバイザーチームが以下3名で発足しました。私、さがらも新しいアドバイザーチームの一員となりました!

- Yasuhisa Yoshidaさん

- ikkiさん

- さがら

私もData Engineering Studyを見てデータエンジニアリング界隈の技術・キャリアのことを多く学んできた人間ですので、これまで以上にData Engineering Studyを盛り上げていけるように頑張っていきます!!

次回、#31ではアドバイザーチーム3名によるLT&公開企画会議が行われますので、ぜひご参加ください!

Summer Data Engineering Roadmap

MotherDuckのブログにおいて、データエンジニアリングをどのように身に着けていくべきか、ロードマップをまとめた記事が出ていました。

Foundation・Core・Advanced、と3つのレベルに分けて述べられているため、どこから始めていけばよいかわかりやすくまとまっていると思います。

また、これまでMotherDuckのブログでは、どういったツールがデータエンジニアリングに役立つかまとめた記事が出ています。こちらも体系的にまとめられており、参考になると思います。

Databricks vs. Snowflake: The Final Chapter

Orchestra社のブログより、DatabricksとSnowflakeの競合関係は終わり、両社はそれぞれ異なる戦略(開発者向け対ビジネス向け)で、新たな市場へ進むという今後の展望を解説した記事が出ていました。

以下は記事の内容を抜粋して要約しただけですが、このような予想について本記事で述べられています。

- Databricks → 開発者プラットフォームへ

- 強固な開発者コミュニティを武器に、Azureのようなハイパースケーラー上で最高の開発環境を提供することを目指すのではないか

- Snowflake → ビジネスアプリ市場へ

- ビジネスユーザーという顧客基盤を活かし、Salesforceのような巨大SaaSを置き換える「コンポーザブル(構成可能)」なアプリケーション基盤を目指すのではないか

Data Extract/Load

Fivetran

Fivetran社によるAirbyteとの比較記事

Fivetran社の公式ブログにより、Airbyteとの比較を行った記事が出ていました。

「Fivetran社が書いている」ということの考慮は必要でありAirbyteの記述内容で一部古い印象は受けました。(例として、AirbyteのSchema Change ManagementやConnector Builderについての言及がなかった)

ただ、ざっくりと両社の違いを理解する上では参考になると思います。

Data Warehouse/Data Lakehouse

Snowflake

Snowflake内で実行したクエリのパフォーマンス分析・改善提案の情報がまとまった「QUERY_INSIGHTS」ビューがリリース

Snowflake内のクエリの実行状況を分析し、パフォーマンスに影響がありそうな箇所を自動で検出した結果を保持する新しいACCOUNT_USAGEのビューとして、「QUERY_INSIGHTS」ビューがリリースされました。

実際に私も試してみましたが、Snowflake側で自動で検出を行ってくれるため、ユーザーが行うことは「QUERY_INSIGHTSビューを見て指摘事項を確認して処置を行う」だけで済むのがとても良いなと感じました!

Snowflake公式からCortex AI機能に対応したMCP Serverがリリース

Snowflake公式からCortex AI機能に対応したMCP Serverがリリースされました。現在はCortex SearchとCortex Analystに対応しています。

このリリースに関して公式ブログも出ていましたが、今後Snowflakeがインフラを管理するSnowflake managed MCP serversもリリース予定とのことです。

BigQuery

CREATE EXTERNAL TABLEとLOAD DATAにおいて「source_column_match」と「null_markers NULL」のオプションが追加

BigQueryで外部ストレージ上のデータをクエリ・ロードする際に用いるCREATE EXTERNAL TABLEとLOAD DATAにおいて、「source_column_match」と「null_markers NULL」のオプションが追加されました。

Databricks

DatabricksリリースノートのRSSフィード

Databricksのリリースノートについて、製品の最新情報やその他の機能リリースノートを含んだRSSフィードが提供開始となりました。

再帰CTE(Recursive CTE)がDatabricksでパブリックプレビュー

Databricksの新機能として、再帰CTE(Recursive CTE)がパブリックプレビューとなりました。

MotherDuck/DuckDB

MotherDuckが、大規模で複雑なデータ処理向けの新インスタンス「Mega」と「Giga」を発表

MotherDuckは、既存の「Jumbo」ducklingsでは対応しきれない、より要求の厳しいデータ処理の需要に応えるため、新たに2つの大きなインスタンスサイズ「Mega」と「Giga」を発表しました。

記事によると、Megaは大規模なワークロード向け、Gigaは他に代替手段がないような極めて複雑で巨大な変換処理向けに設計されているとのことです。

MotherDuckが提供しているインスタンスタイプの一覧については、以下の公式ドキュメントをご覧ください。

Data Transform

dbt

dbt-bigqueryにおいてBigLake Metastoreを介してIcebergテーブルを構築できるように

dbt-bigquery 1.10リリースから、BigLake Metastoreを介してIcebergテーブルを構築できるようになりました。

まだプレビュー機能ではありますがBigLake MetastoreはApache Iceberg REST Catalogの機能も提供しているため、「dbtでBigLake MetastoreをカタログとしたIcebergテーブルを構築し、外部エンジンからIcebergテーブルをクエリする」ということが机上論では出来るようになりました!(これはどこかで私も試してみたいですね…)

Business Intelligence

Tableau

Generative AI on Vertex AI と Tableau でプロレスの試合動画を分析してみた

rtamaさんにより、プロレスの試合動画を構造化データに変換し、Tableauで分析したという記事が公開されました。

どのようなプロンプトを渡すことで動画を分析に適した構造化データに変換できるか、非常に参考になる記事です!(プロレスという題材選定もさすがです!!)

Lightdash

Lightdashがdbt Fusionとdbt 1.10をサポート

Lightdashがdbt Fusionとdbt 1.10をサポートしました。

注意点としては、dbt 1.10以降は「config:の配下でmeta:を記述」するようになっているため、Lightdashユーザーにとってはこの部分の移行が1つの大きなハードルとなります。

Lightdash側もこのハードルを認識してか、Migration GuideとMetaMoveという移行用のツールをリリースしています。

Omni

Omni公式のMCP Serverがリリース

Omniから、公式のMCP Serverがリリースされました。Omniで構築したセマンティックモデルを別のツールと連携してより正確な回答を得ることに繋げることもできるため、Omniの可能性が更に広がる機能拡張だと思います!

Data Catalog

Select Star

Select StarがMCP Serverをリリース

Select Starが新しくマネージドのMCP Serverをリリースしました。Select StarのAPIトークンを用いて認証する仕様となっています。

OpenMetadata

Collate社がシリーズAで1000万USDの資金調達を実施

OpenMetadataのプロジェクトを支援しSaaS版も提供しているCollate社が、シリーズAで1000万USDの資金調達を実施しました。

Data Activation (Reverse ETL)

Census ※Fivetran傘下

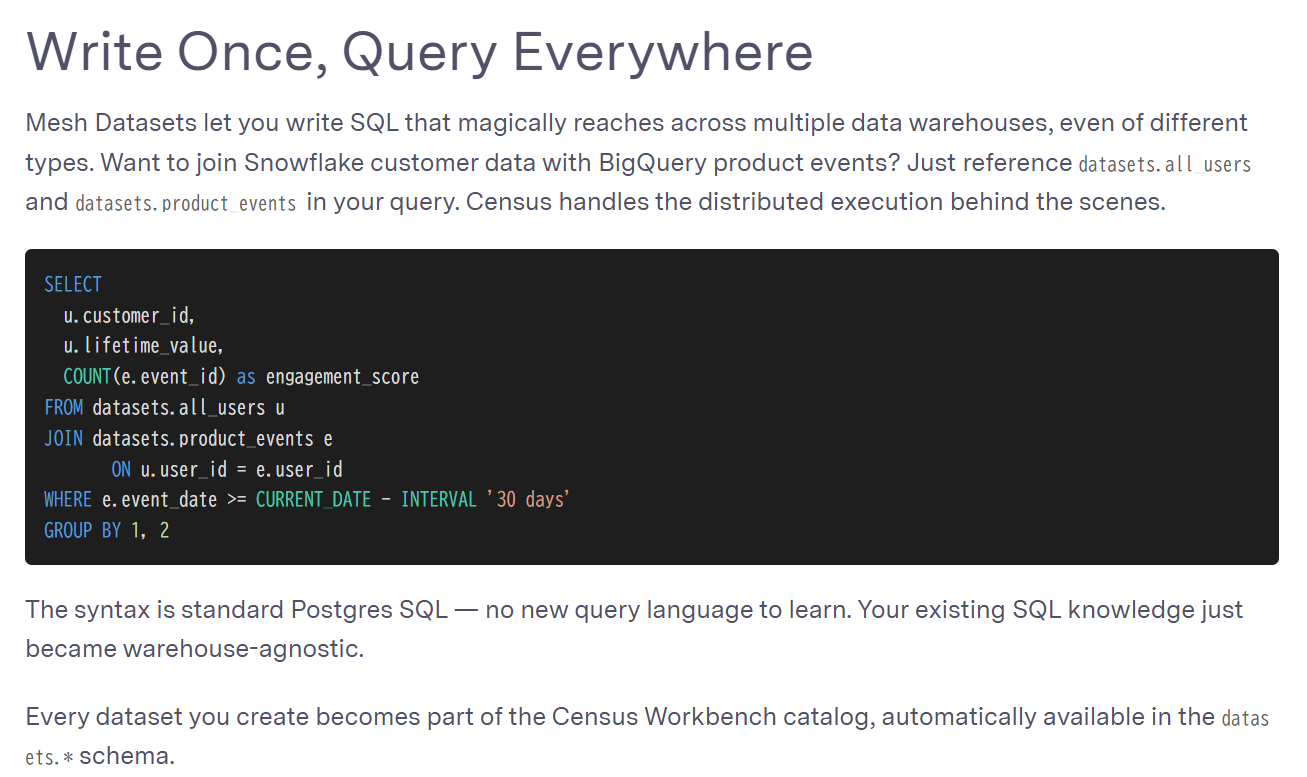

Census上で複数のDWHを跨いだクエリを実行できる「Mesh Datasets」をリリース

Censusの新機能として、複数のDWHを跨いだクエリを実行できる「Mesh Datasets」をリリースしました。

使い方としてはPostgreSQLの構文でクエリを記述するだけで良いようです。(下図はリンク先のブログより)