![[アップデート] P6e-GB200 UltraServer の登場と、巨大な GPU インスタンスを支える AWS の技術について](https://images.ctfassets.net/ct0aopd36mqt/wp-thumbnail-bac3d29aa65f45576f73094798087ee5/039ad6f8a7d8f18da47986d21c447f48/amazon-ec2?w=3840&fm=webp)

[アップデート] P6e-GB200 UltraServer の登場と、巨大な GPU インスタンスを支える AWS の技術について

はじめに

昨今の生成 AI 需要の爆発的な計算要求に応えるための新しい EC2 インスタンス P6e-GB200 UltraServers がリリースされました。ラック 1 本が丸ごと 1 つのサーバーの NVIDIA GB200 BVL72 が EC2 インスタンスとなったとのことで気になることが多いアップデートでした。 今回新登場の液体冷却システムについても説明します。

P6e-GB200 UltraServers とは

P6e-GB200 UltraServers は、NVIDIA GB200 NVL72 を採用した AI/ML 向けインスタンスタイプです。1 台で 36 個または、72 個の Blackwell GPU を単一の巨大 GPU として機能する GPU モリモリのインスタンスです。また、EC2 インスタンス間を高帯域幅、低レイテンシーでスケールアウトな構成となっており、数万 GPU までスケーリングが可能です。

スペックは以下のリンクを参照ください。

提供リージョンと提供形式

現在はバージニア北部リージョン(us-east-1)のローカルゾーンであるダラス(us-east-1-dfw-2a)でのみ提供されています。リージョン選択はバージニア北部リージョンを選択すれば問題ありません。

インスタンスの利用には ML for Capacity Block で事前予約&前払いが必要です。今回新たに予約画面で UltraServers の項目が追加され、u-p6e-gb200x[36 or 72]が選択可能となっています。

予約するには

現時点では、予約するには AWS サポートへ申請が必要でした。

なぜかというとサービスクォータの画面には P6e の項目がないため、制限に引っかかってしまうようです。

残念ながら費用感は確認できませんでした。

P6e-GB200 UltraServers を支える AWS の技術

ここからは私の趣味です。AWS は NVIDIA GB200 NVL72 をどのように私たちユーザーへ提供しているのか紹介している動画ありました。個人的に興味深かった点の抜粋と、動画で説明されていなかった点を調べたことをまとめておきます。

NVIDIA GB200 NVL72 とは

NVIDIA GB200 Grace Blackwell Superchip が 36 基搭載されています。 1 つの NVIDIA Grace CPU(Arm)と、2 つの NVIDIA Blackwell Tensor Core GPU がセットになっています。GPU と CPU 間は NVIDIA NVLink-C2C インターコネクトを使用して接続され、帯域幅が太いチップセットです。

NVIDIA GB200 NVL72 は、1 ラックに 18 台のデュアル GB200 コンピューティングノードを収めるパターンと、36 台のシングル GB200 コンピューティングノードを 2 ラックに分けて構成する 2 パターンがあります。P6e-BG200 が採用しているのは後者の 2 ラック構成の様でした。

NVIDIA NVLink

ラック内では、第 5 世代の NVIDIA NVLink により 72 個の GPU を接続され、総帯域幅 132TB/s の単一の GPU として機能します。これが 1 台の UltraServer として提供されています。1 台のサーバーの中でスケールアップを担っている技術です。

EC2 UlsterCluster

次はスケールアウトを担っている技術です。サーバー間の通信には、Elastic Fabric Adapter (EFAv4)を採用され、最大 28.8 Tbps の帯域幅があります。

高速な EFA で相互接続された環境は EC2 UltraCluster と呼ばれます。今回の P6e-GB200 UltraSever は EC2 UlsterCluster 上にあります。そのため、サーバー間の通信が高速通信が実現でき、数万 GPU までのスケーリングが可能な構成です。

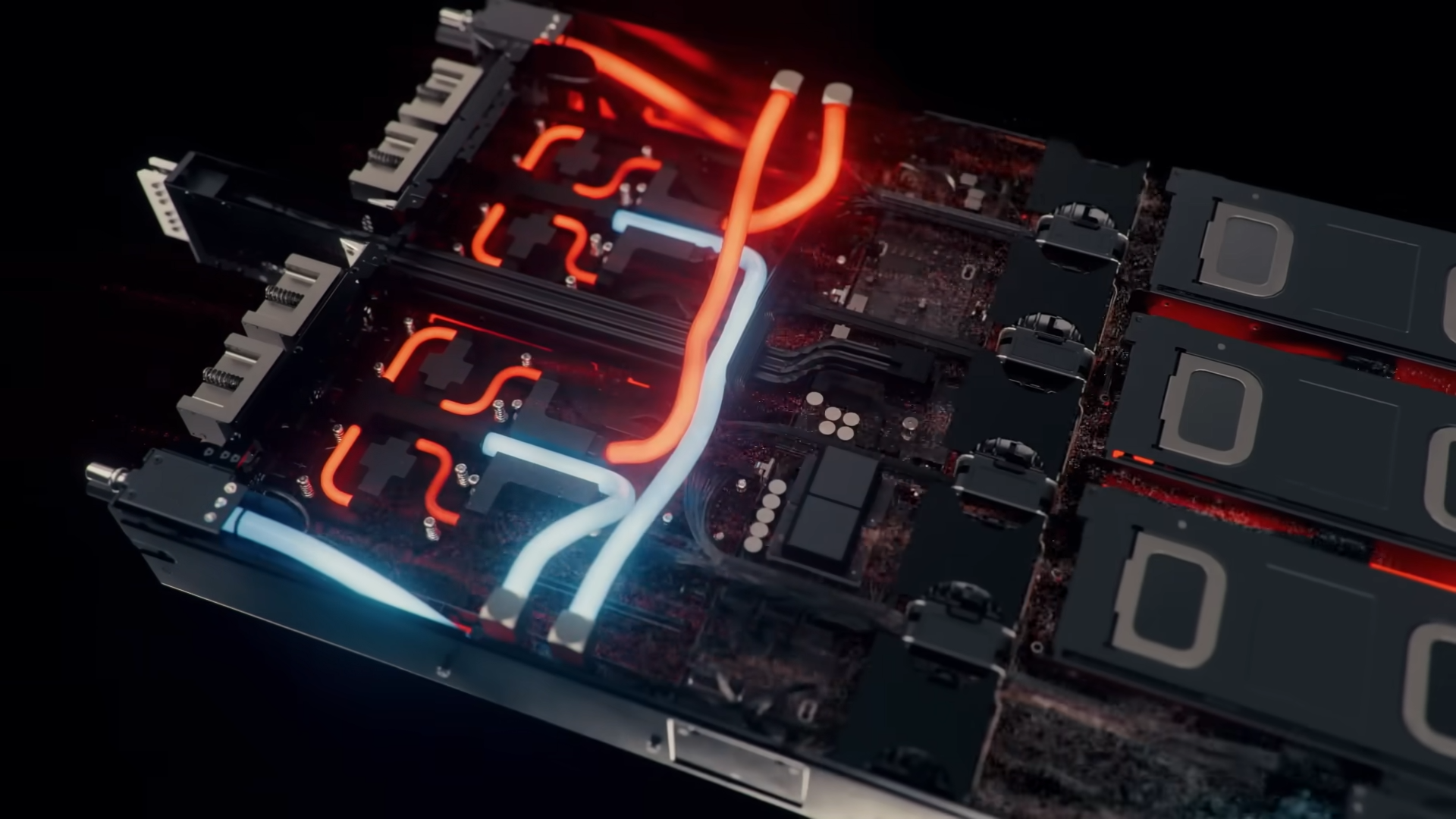

新登場: 液体冷却システム IRHX

Amazon が独自設計した液体冷却システムIn-Row Heat Exchanger (IRHX) が利用されています。最大の利点は、大規模な液体冷却システムを既存のデータセンターにある空冷式のシステムに最小限の変更で導入できる点です。ここが一番興味深かったです。

ポンプから送られた冷却液が、AWS と NVIDIA が共同開発したコールドプレートを通り、発熱源であるチップを直接冷却します。

温まった液体は IRHX に戻りファンによって冷却され、熱はデータセンター内のホットアイルへ排出されます。面白いのは冷却量に応じてファンコイルユニットを追加、撤去することで拡張性も抜群です。

今後より発熱量の大きな GPU が開発されても、ファンコルユニットを追加すれば冷却が追いつく模様です。ハードウェア設計も AWS のソフトウェアサービスレベルに拡張性高く素晴らしいですね。

おわりに

IRHX は AWS 上で大規模に導入された最初の液体冷却ハードウェアプラットフォームとのことです。次の re:Invent で IRHX の紹介されないでしょうかね。re:Invent 2023 のときの Amazon Time Sync で原子時計をラック内に設置している話みたく「そんなことやってるの!?」という面白い話がありそうなので液体冷却システム特集して欲しいです。