re:Invent2025で体感したフィジカルAIの現在

概要

こんにちは、クラスメソッド製造ビジネステクノロジー部の田中聖也です。

re:InventにはExpoと呼ばれる展示会があります。

生成AI系の展示が多いですが、工場では物理的な作業を代わりににやってくれるようなフィジカルAIが必要だと考えています。

Expoで展示されていたフィジカルAIを見てきたので、それをまとめたいと思います。

そもそもフィジカルAIとは?

Geminiに聞くと以下のような回答が返ってきました。

フィジカルAIとは、「現実世界で物理的に行動する体を持ったAI」のことです。従来の画面の中にいるAIとは異なり、ロボットや自動運転車、ドローンとして実社会に存在します。センサーで周囲を認識し、自ら判断して物を運んだり、組み立てなどの複雑な作業を行ったりするのが特徴です。人手不足の解消や、危険な場所での作業代行など、私たちの生活や仕事を直接助けてくれる技術として注目されています。

自分なりの言い方をすると「現状の生成AIを拡張して現実世界の物に干渉できるロボット」です。

展示物

そもそも、Expoの会場時代もめっちゃでかくて人も多いです。3日目の開場と同時に行ったのですが、人に溺れそうでした。

AWS

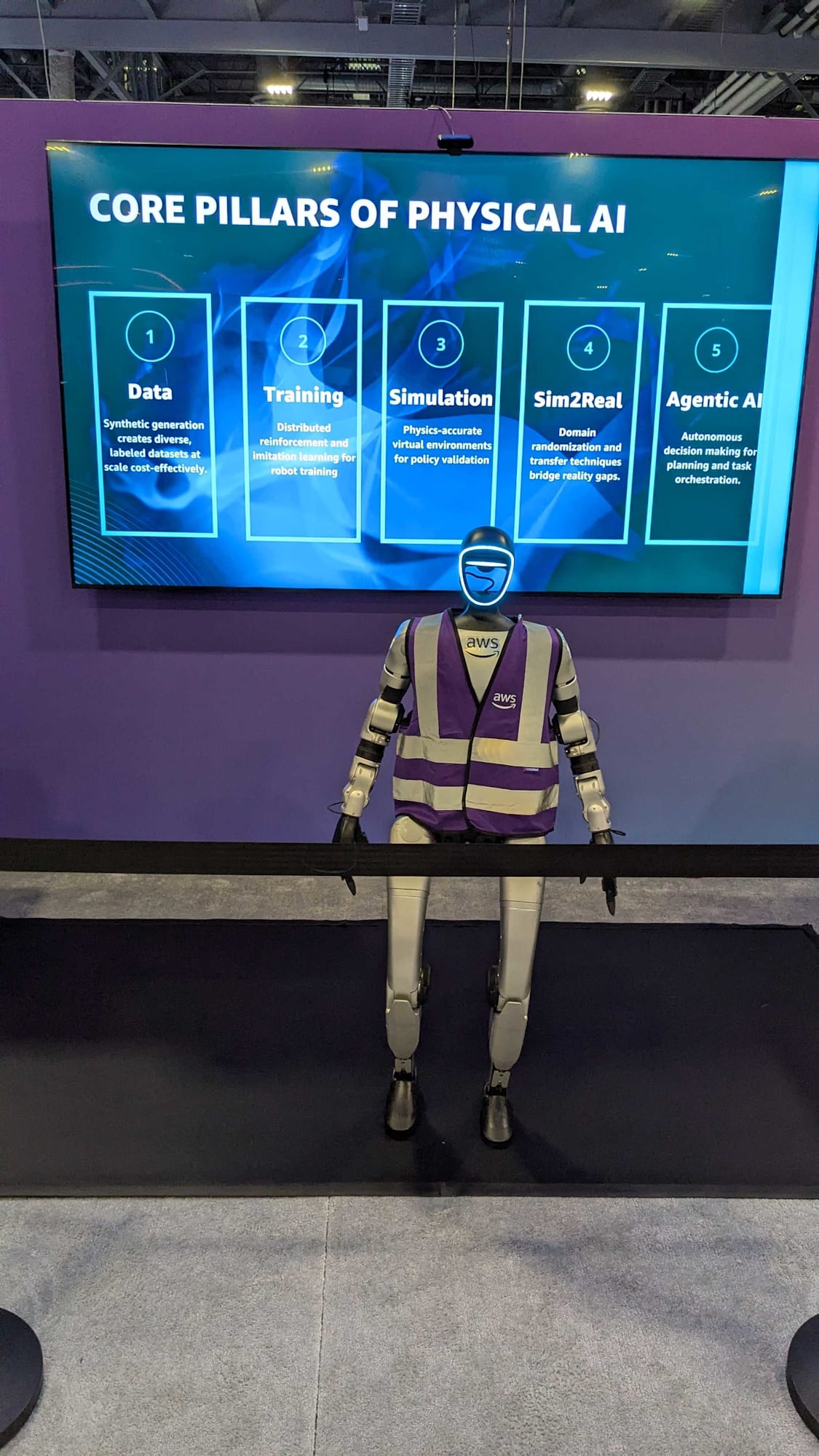

人型の運搬ロボット

AWSを使って学習されていたロボットが展示されていました。

身長は1.2mぐらいです。

2mぐらい離れた机が2つあり、片方に置かれている箱をつかんで、反対側の机の上にある段ボールに掴んだ箱を入れるというデモをやっていました。

動作はかなりゆっくりで、1つの箱を運ぶために3分ぐらいかかってました。

デモを見ていると箱を握りやすい位置に微妙に移動していたり、箱を掴むのに失敗しても、腕の位置を変えて再挑戦しているのが分かりました。

人間がVRゴーグルをかけてロボットを操作した記録を学習データにしているようです。

次にどんな動作をするかはクラウド側で計算して、その結果をロボットに指示しているようでした。

現場でのユースケース

現段階では使い物にならないと思います。

ただ、2年もすれば現場で以下のようなユースケースがあると考えています。

- 3kg ~ 10kg程度の段ボールを持ち上げて決められた場所に持っていく

- 台車を押して決められた場所に持っていく

このぐらいのレベルでも現場では助けにもなりますし、労災なども防げると思います。

Intel

Intelは大きく3つほどを展示をしていて、2つはフィジカルAIでした。

そのうち1つを紹介します。

ロボットアーム

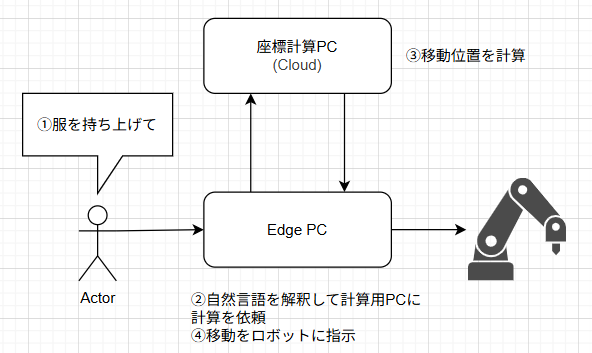

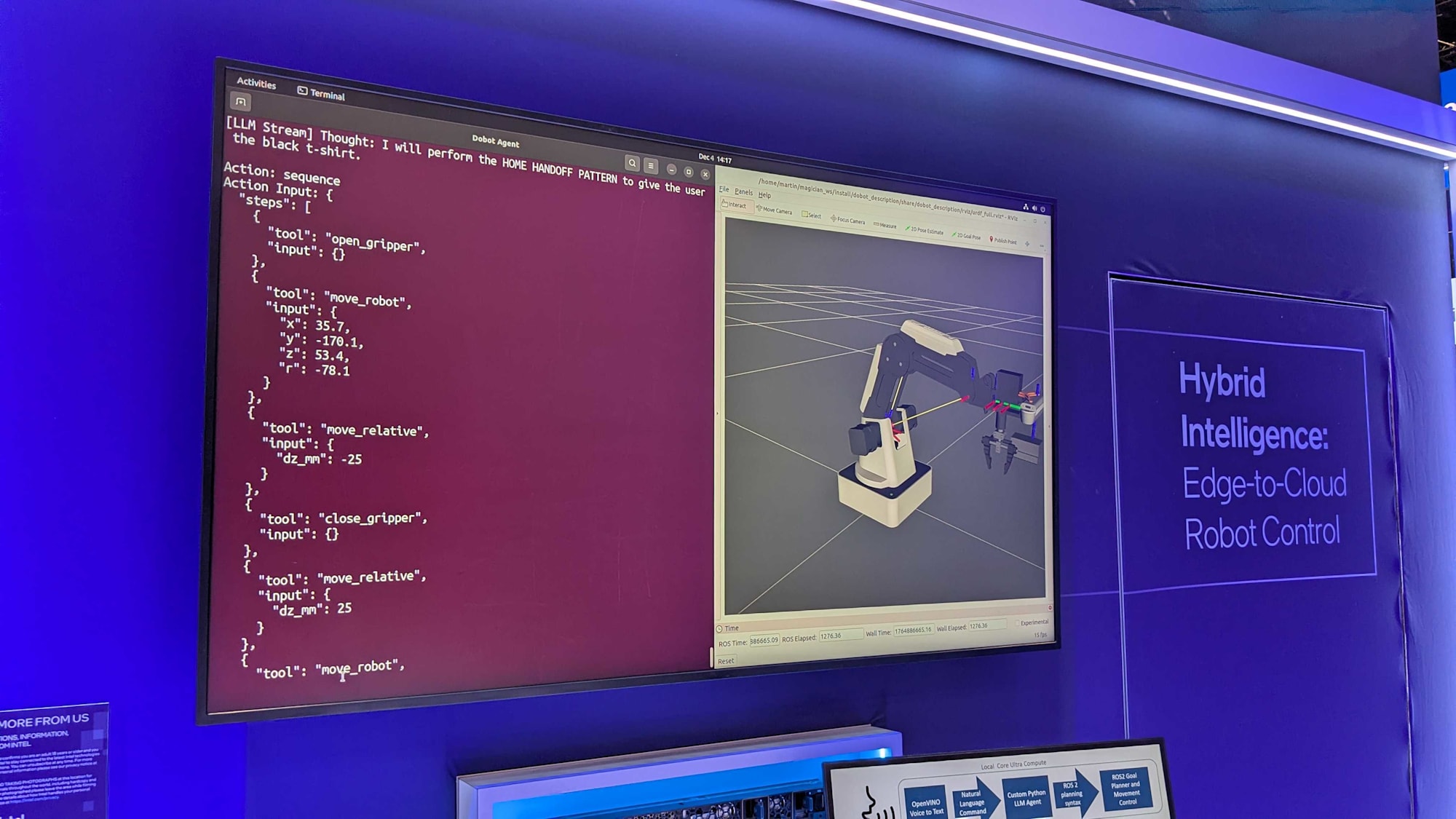

自然言語で命令した内容通りにロボットアームを操作するという内容でした。

自然言語を解釈してロボットアームを操作するというデモでした。

イメージ図は以下のような感じです。

以下は実物です

これがアームですね。自然言語で命令すれば服を掴んだり離したりします。

これが自然言語を処理するEdgeコンピューターです。

これがEdgeコンピューターの画面出力です。座標計算用のコンピューターから計算結果を受け取っているのが分かります。

現場でのユースケース

工場で自然言語で命令をするといったユースケースはあまり思い浮かばないですが、カメラを取り付けることができるようで画像認識で物を判別して掴むことができるようです。

コンピュータービジョンが使えるようになると以下のようなユースケースがあると考えています。

- コンベア等で流れてきた仕掛かり品 or 完成品を画像認識して品番ごとの次の箱に入れ替える

- 今までは品番に段取り替えが必要であったが、画像認識で自動で品番を認識できる。つまり小ロット生産につながると考えています。

感じたこと

現状は現場に投入するのは難しいですが、あと2年あれば現場投入可能なフィジカルAIが開発されると思います。

人間と違うのは1台のフィジカルAIに作業内容を教えたら、他のフィジカルAIはその経験値を引き継ぐことができるので教育コストが圧倒的に下がると思います。

今は値段も高いですが、どこかで1桁下がると思われます。

フィジカルAIが工場現場の様々な工程に投入されて、運搬作業による労災や属人化といった課題が少しでも早く来るようにキャッチアップしていく必要があると思いました。