![[アップデート] AgentCore Evaluations(Preview)がリリースされました! #AWSreInvent](https://images.ctfassets.net/ct0aopd36mqt/33a7q65plkoztFWVfWxPWl/a718447bea0d93a2d461000926d65428/reinvent2025_devio_update_w1200h630.png?w=3840&fm=webp)

[アップデート] AgentCore Evaluations(Preview)がリリースされました! #AWSreInvent

はじめに

re:InventでAgent Coreの新しい機能であるEvaluationsが公開されました!今回はこの機能について解説します。AWS公式からもブログがでているのでこちらもご参照ください。

どんな機能なのか

Agent Core Evaluationsは、AIエージェントの実際の行動に基づいてパフォーマンスを継続的に監視・分析できるサービスです。AIエージェントは従来だと、手動や自作したツールによる性能評価を行っていました。この機能によって、正確性、有用性、ツール選択の正確性、安全性、目標達成率、コンテキストの関連性でAIエージェントを評価できます。多角的な評価を定期的に行うことで、性能劣化にいち早く気付くことが可能になります。また、プロジェクトごとに独自の評価ツールを理解する手間が減ることも期待できます。

対応リージョン

現状はプレビューとして以下のリージョンで利用可能になっています。

- us-east-1

- us-east-2

- us-west-2

- ap-southeast-2

- eu-central-1

使ってみた

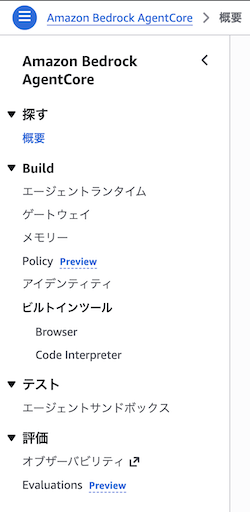

実際にどんな画面なのか確認してみます。us-east-1でAgent Coreにアクセスすることで機能が確認できます。添付画像の下の部分です。

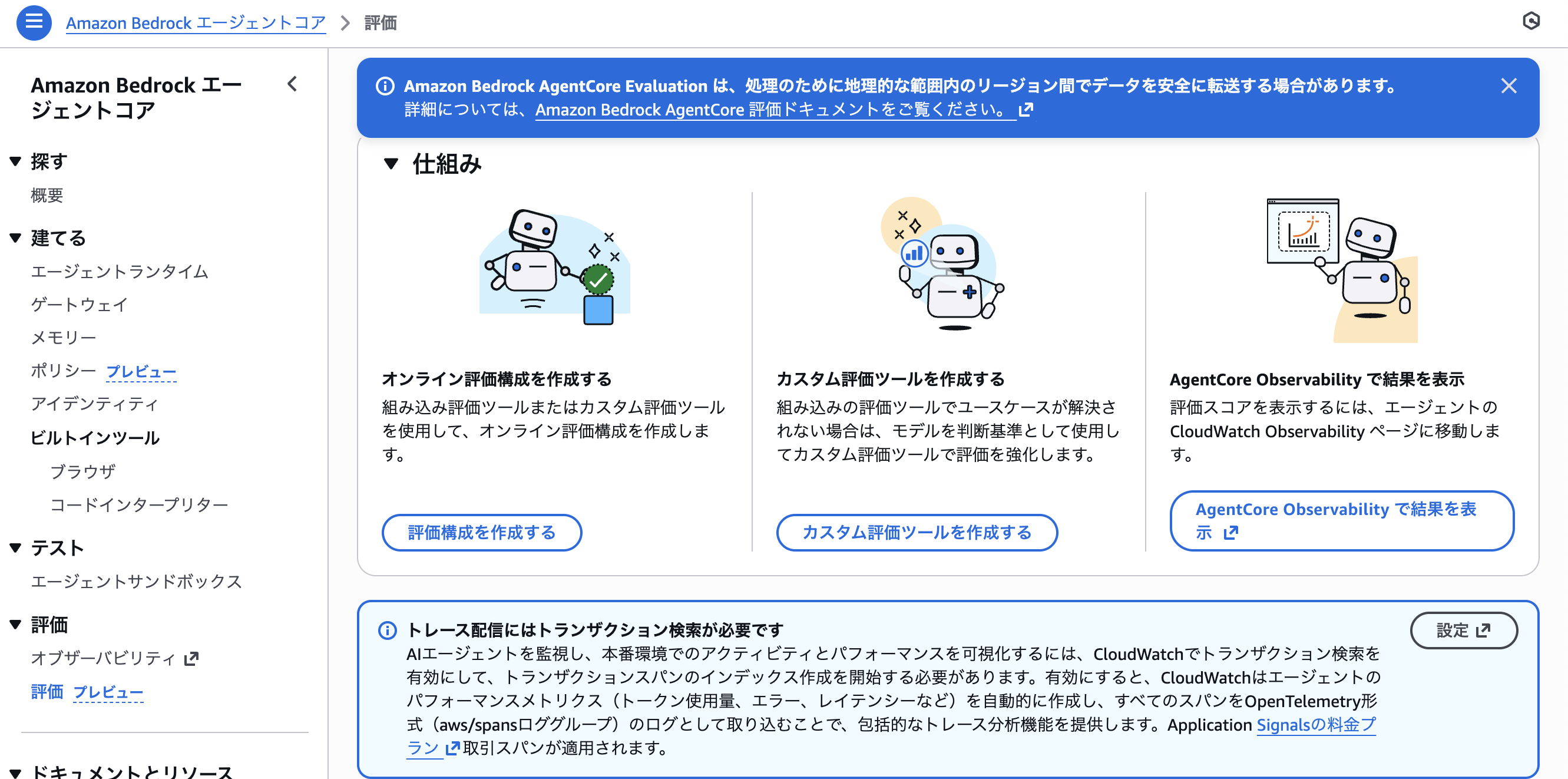

Evaluationsのページを日本語訳して表示してみます。オンラインで評価する仕組みや、評価内容のカスタマイズを行えるようです。

スクロールすると、評価の設定やカスタム評価を設定できます。

Create evaluation configurationで評価の作成を進めると、評価対象のエージェントをエンドポイントで設定するか、CloudWatch Log Groupで設定するか選べます。

さらにスクロールすると、どんな要素でAIエージェントを評価するかを選べます。AIエージェントの特性に合わせて、適切なものが選択できます。正確性が重要な領域であれば、正確さを評価対象に選択できます。

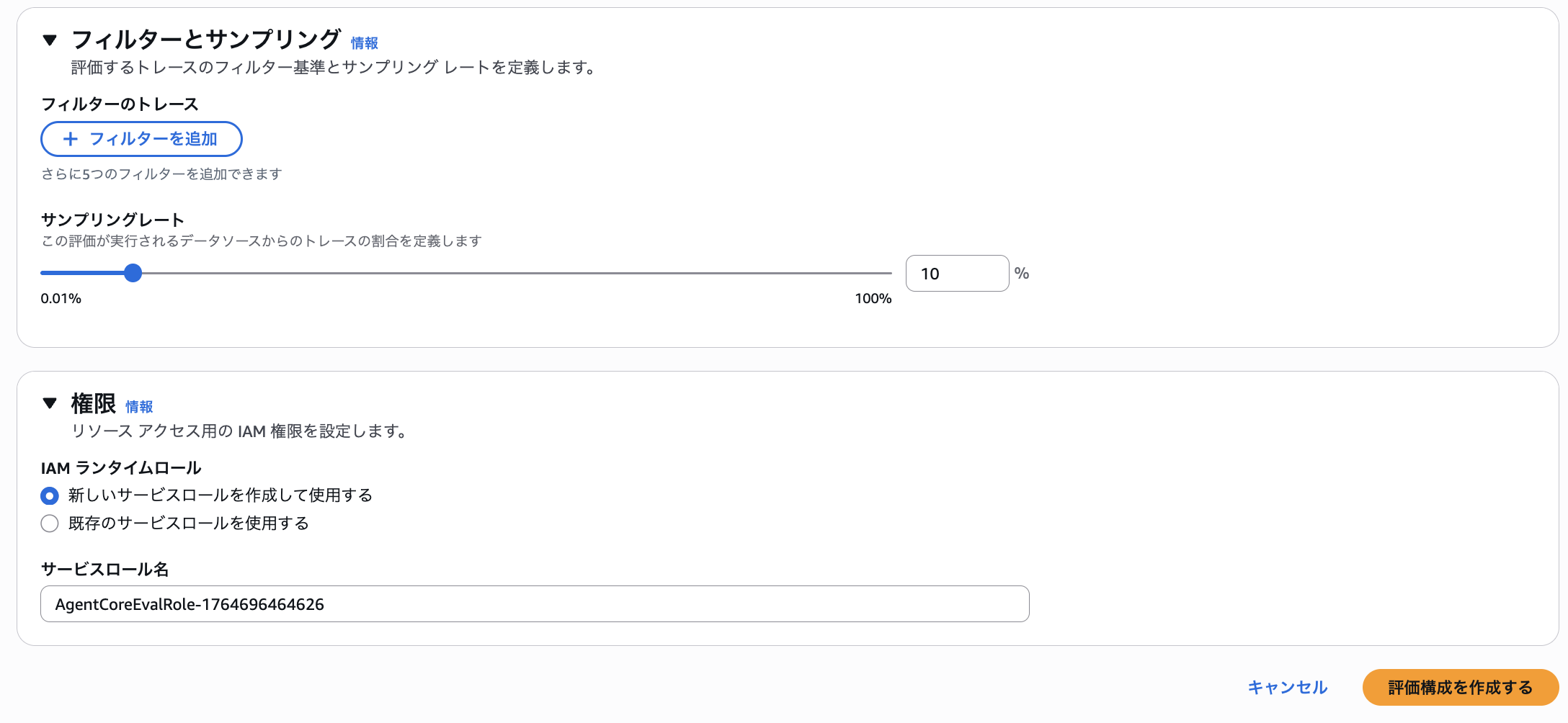

AIエージェントのどのぐらいのリクエストを評価対象とするか、サンプリングレートも設定できます。すべてのデータを操作すると、今後の金額設定によっては、高額になる可能性もあるので重要な項目です。またどんな権限をもたせるかも設定できます。

所感

速報として紹介あげました。個々で評価を実施している会社にとって、かなりよいアップデートとなる予感がしています。今後検証ブログも上げていこうと思います!