Amazon Connect生成AI自動評価機能で悪い対応事例の精度を日本語で検証してみた

はじめに

Amazon Connectのパフォーマンス評価機能では、事前に作成した評価フォームを利用し、機械学習を用いたスコアリングやエージェントの会話内容の評価を行うことができます。

エージェントが顧客対応完了後にコンタクトの評価フォームに回答すると、評価スコアが算出されます。これにより管理者(評価者)は、スコアの低いコンタクトを対応したエージェントに対して、迅速にフォローアップを行うことができます。

前回、生成AIを活用した自動評価機能は英語のみのサポートとなっていますが、日本語の会話でも自動評価が実行されるため、良い対応の場合の精度について検証しました。

今回は、同じ評価フォームを使用し、対応が悪かった場合の自動評価の精度を検証してみます。

生成AIの精度向上のための指針

生成AIの精度を向上させるためのガイドラインがAWSドキュメントに記載されています。まずは一度確認しておくことをおすすめします。

今回特に参考になった3つのポイントをご紹介します。

1. 統一された用語の使用

- 可能な限り「同僚」「従業員」「代表者」「代理人」「提携者」などの用語の代わりに「エージェント」を使用します

- 同様に「メンバー」「発信者」「ゲスト」「サブスクライバー」などの用語ではなく、「顧客」という用語を使用します

2. 主観的な質問の回避

「通話中、エージェントは注意深かったですか?」といった非常に主観的な質問に、生成AIを使用して答えるのは避けます。

3. 評価者向け手順の活用

[評価者向けの手順]ボックスに、評価者や生成AIが質問に答えるのに役立つ情報を追加します。評価フォームを設定する際、各質問に関連付けられた評価者向けの手順内に、質問に回答するための基準を提供することができます。これらの指示は、評価者による評価の一貫性を高めるだけでなく、生成AIを活用した評価を提供するためにも使用されます。

評価フォームの概要

今回使用した評価フォームの内容は、前回の記事と同じです。

検証用の悪い対応事例

前回の記事と同じ評価フォームを使用し、今回は対応品質の低い会話を評価対象としました。会話内容は生成AIで作成したサンプルです。

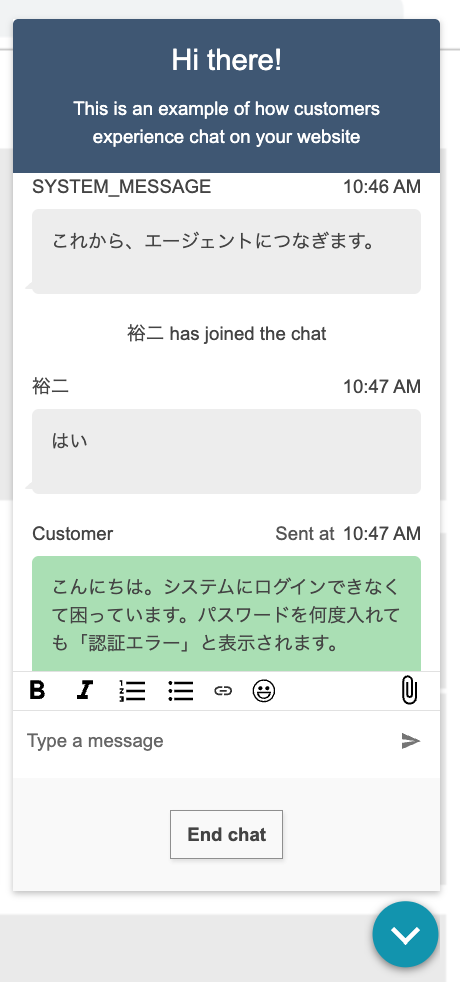

チャット対応例(悪い例):システムログインエラーの問い合わせ

エージェントがチャットに参加しました

エージェント: はい

顧客: こんにちは。システムにログインできなくて困っています。パスワードを何度入れても「認証エラー」と表示されます。

エージェント: パスワード間違ってるんじゃないですか?確認してください

顧客: いえ、確実に正しいパスワードを入力しています。昨日までは普通にログインできていました。

エージェント: だったらシステムの問題ですね。こっちでは分からないので

顧客: え?それだけですか?何か解決方法はないんでしょうか?

エージェント: うーん、とりあえずパスワードリセットしてみてください

顧客: パスワードリセットの方法を教えていただけますか?

エージェント: ログイン画面に「パスワードを忘れた方」みたいなリンクありませんか?それクリックして

顧客: 見つからないんですが...画面のどこにありますか?

エージェント: えーっと

[3分経過 - エージェントから応答なし]

顧客: すみません、まだいらっしゃいますか?

エージェント: すみません、ちょっと調べてました。そのリンクがないなら、アカウントが削除されてるかもしれませんね

顧客: 削除?そんなことあるんですか?有料会員なのに勝手に削除されるんですか?

エージェント: 分からないです。上の人に聞いてみます

[数分経過]

顧客: どうなりましたか?とても困っているので、早急に解決していただきたいのですが

エージェント: すみません、担当者が席外してて。明日また連絡してもらえますか?

顧客: 明日ですか?今日中に使えないと仕事に支障が出ます。他に方法はないんですか?

エージェント: うーん、こっちでできることは特にないので...

顧客: そんな対応はないでしょう!責任者の方はいらっしゃいませんか?

エージェント: 今日はもう帰りました。また明日電話してください

顧客: 納得できません。このままチャットを終了されるのは困ります。

エージェント: 時間なので失礼します

エージェントがチャットから退出しました

自動評価結果の詳細

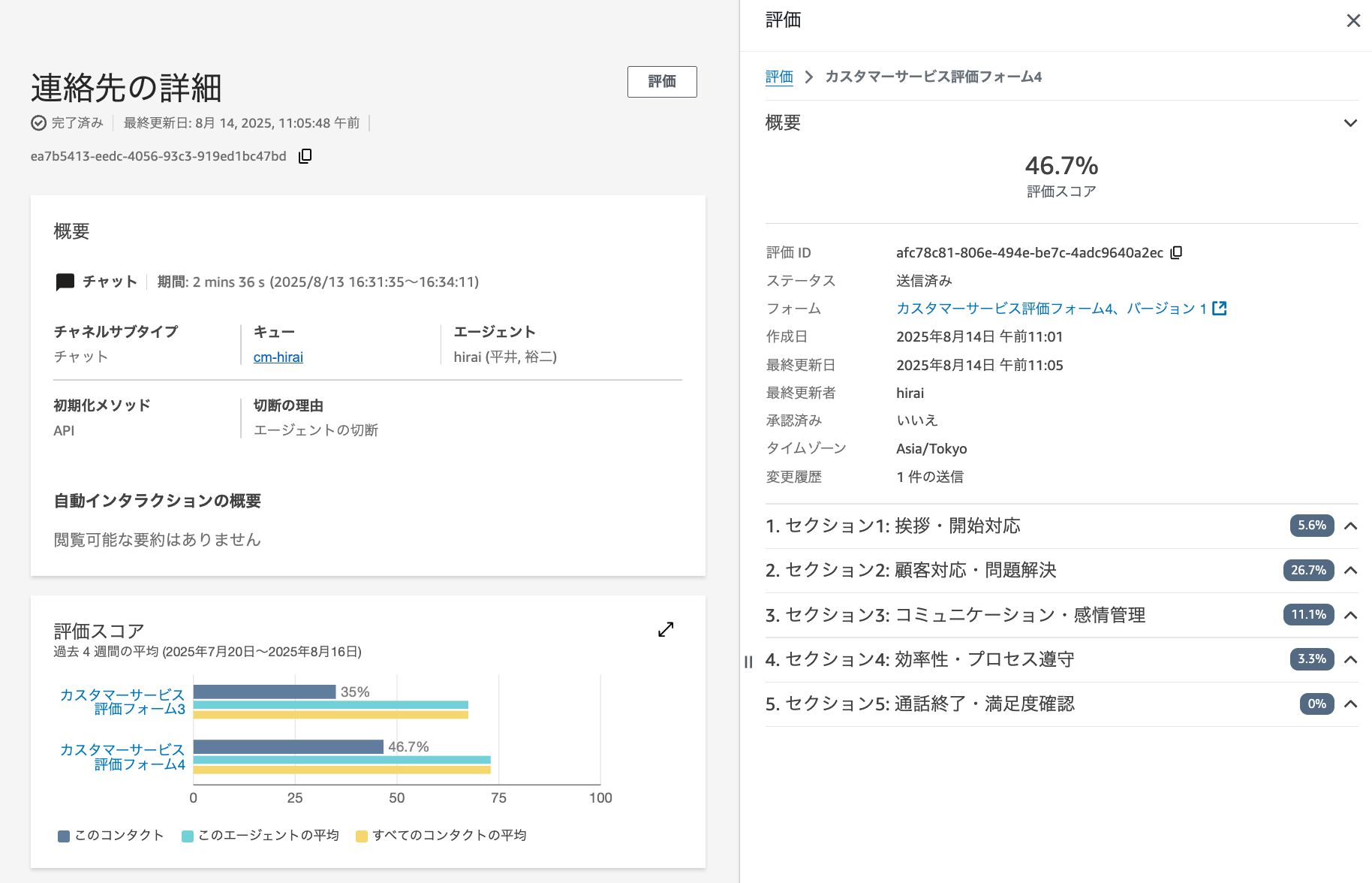

上記の悪い対応例に対して自動評価を実行した結果、総合スコアは46.7点となりました。

各項目の詳細な評価結果は以下のとおりです。

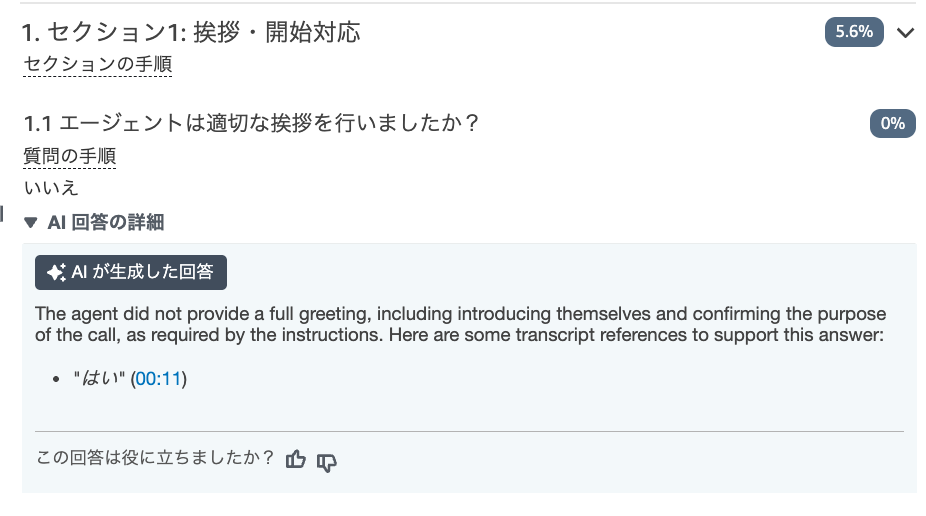

セクション1: 挨拶・開始対応

質問1.1: 適切な挨拶

評価結果: いいえ(0点)

生成AIが生成した回答(回答根拠): エージェントは、指示で要求されているとおりに、自己紹介と通話の目的の確認を含む完全な挨拶を行いませんでした。

この回答を支持する会話記録の参考例:

- "はい"

AIの評価は完全に正確です。エージェントは「はい」としか発言しておらず、挨拶、会社名、名前、用件確認のいずれも行っていません。0点は妥当な評価です。

生成AIが生成した回答自体は英語で出力されました。

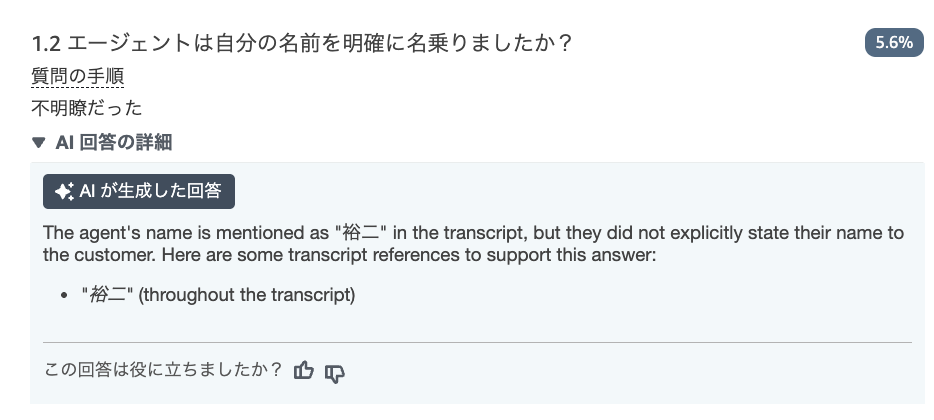

質問1.2: 名前の紹介

評価結果: 不明瞭だった(5点)

生成AIが生成した回答: エージェントの名前は文字起こし内容に"裕二"として記載されているが、顧客に対して明示的に名前を伝えませんでした。

この回答を支持する会話記録の参考例:

- (文字起こし内容全体を通して記載なし)

AIの評価は適切です。チャット画面上では顧客側からエージェント名を確認できるものの、実際の会話でエージェントが自分の名前を名乗らなかったことを正しく判定しています。チャット画面でエージェント名が表示されることを考慮し、「名乗らなかった(0点)」ではなく「不明瞭だった(5点)」と評価している点は妥当です。

チャット画面上では顧客側からエージェント名は確認できる

セクション2: 顧客対応・問題解決

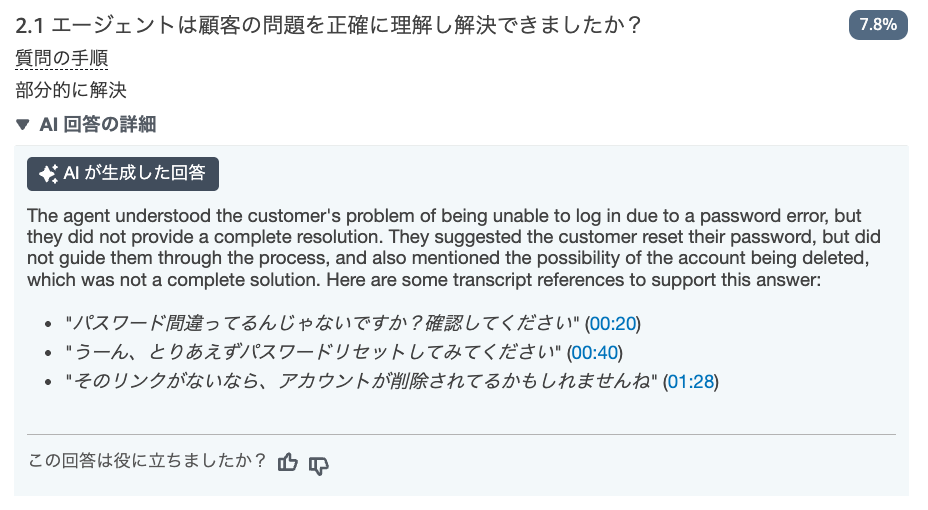

質問2.1: 問題解決能力

評価結果: 部分的に解決(7点)

生成AIが生成した回答: エージェントは、パスワードエラーによりログインできないという顧客の問題を理解しましたが、完全な解決策を提供しませんでした。顧客にパスワードのリセットを提案しましたが、そのプロセスを案内せず、また、アカウントが削除された可能性についても言及しましたが、これは完全な解決策ではありませんでした。。

この回答を支持する会話記録の参考例:

- "パスワード間違ってるんじゃないですか?確認してください"

- "うーん、とりあえずパスワードリセットしてみてください"

- "そのリンクがないなら、アカウントが削除されてるかもしれませんね"

AIの評価はやや甘めです。エージェントは問題を理解しましたが、解決に至らず最終的に「明日連絡してもらう」という結果になっています。「理解したが未解決(3点)」の方が適切な評価だったかもしれません。

質問2.2: 中断の回数

評価結果: 0回(10点)

生成AIは利用されていません。Contact Lensの「NUMBER_OF_INTERRUPTIONS」の値が自動的に設定されます。

通話の場合は中断回数(顧客の発話を遮った回数)がカウントされますが、チャットの場合は中断回数がカウントされず0になるため、この項目は満点となりました。

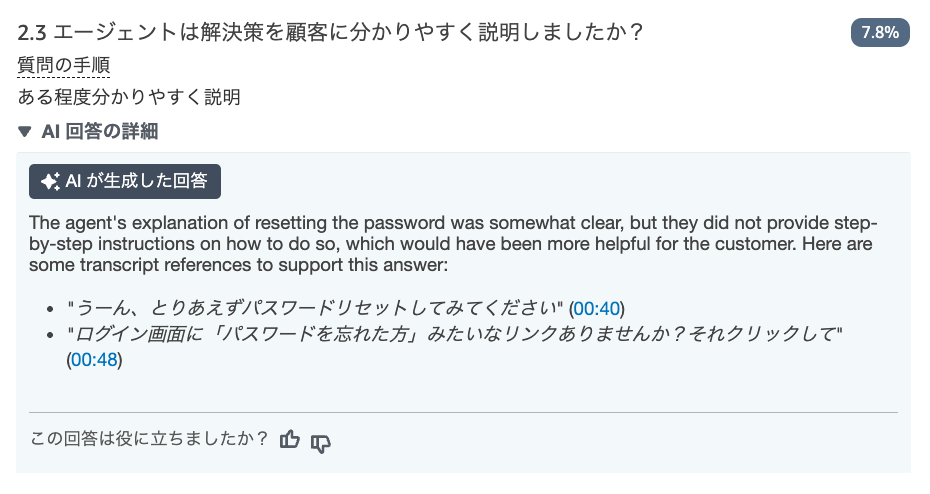

質問2.3: 解決策の説明

評価結果: ある程度分かりやすく説明(7点)

生成AIが生成した回答: エージェントのパスワードリセットに関する説明はある程度明確でしたが、具体的なステップバイステップの手順を提供しておらず、それがあれば顧客にとってより役立ったでしょう。

この回答を支持する会話記録の参考例:

- "うーん、とりあえずパスワードリセットしてみてください"

- "ログイン画面に「パスワードを忘れた方」みたいなリンクありませんか?それクリックして"

AIの評価は甘いです。

エージェントの説明は曖昧で不完全であり、顧客が「見つからない」と言った際にも適切なフォローができていません。「説明が不明瞭(3点)」が妥当な評価でしょう。

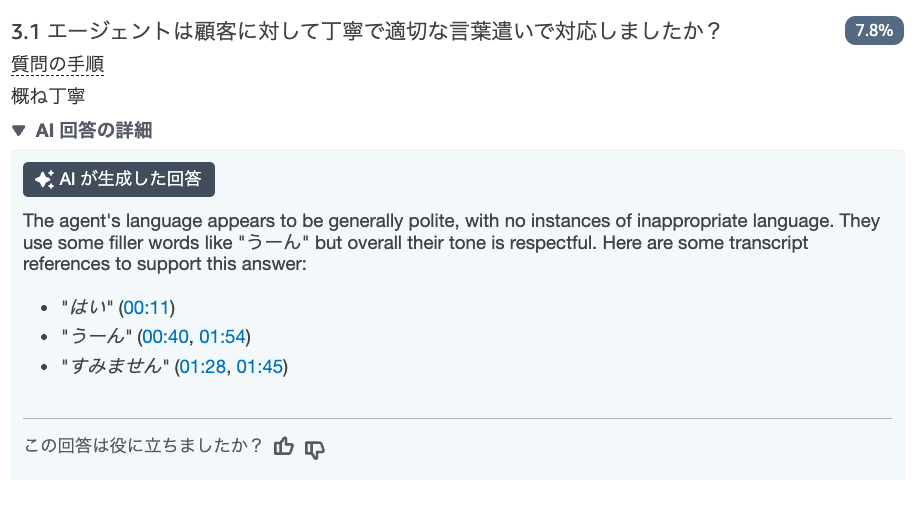

セクション3: コミュニケーション・感情管理

質問3.1: 言葉遣い

評価結果: 概ね丁寧(7点)

生成AIが生成した回答: エージェントの言葉遣いは概ね丁寧で、不適切な言葉の使用は見られませんでした。「ラーん」のような間投詞を使用していますが、全体的にトーンは敬意を示すものでした。

この回答を支持する会話記録の参考例:

- "はい"

- "うーん"

- "すみません"

AIの評価は甘いです。

「パスワード間違ってるんじゃないですか?」「こっちでは分からないので」「時間なので失礼します」など、不適切で冷たい表現が多数見られます。「時々不適切(3点)」が適切な評価でしょう。

質問3.2: 顧客感情評価

評価結果: -1.7(3点)

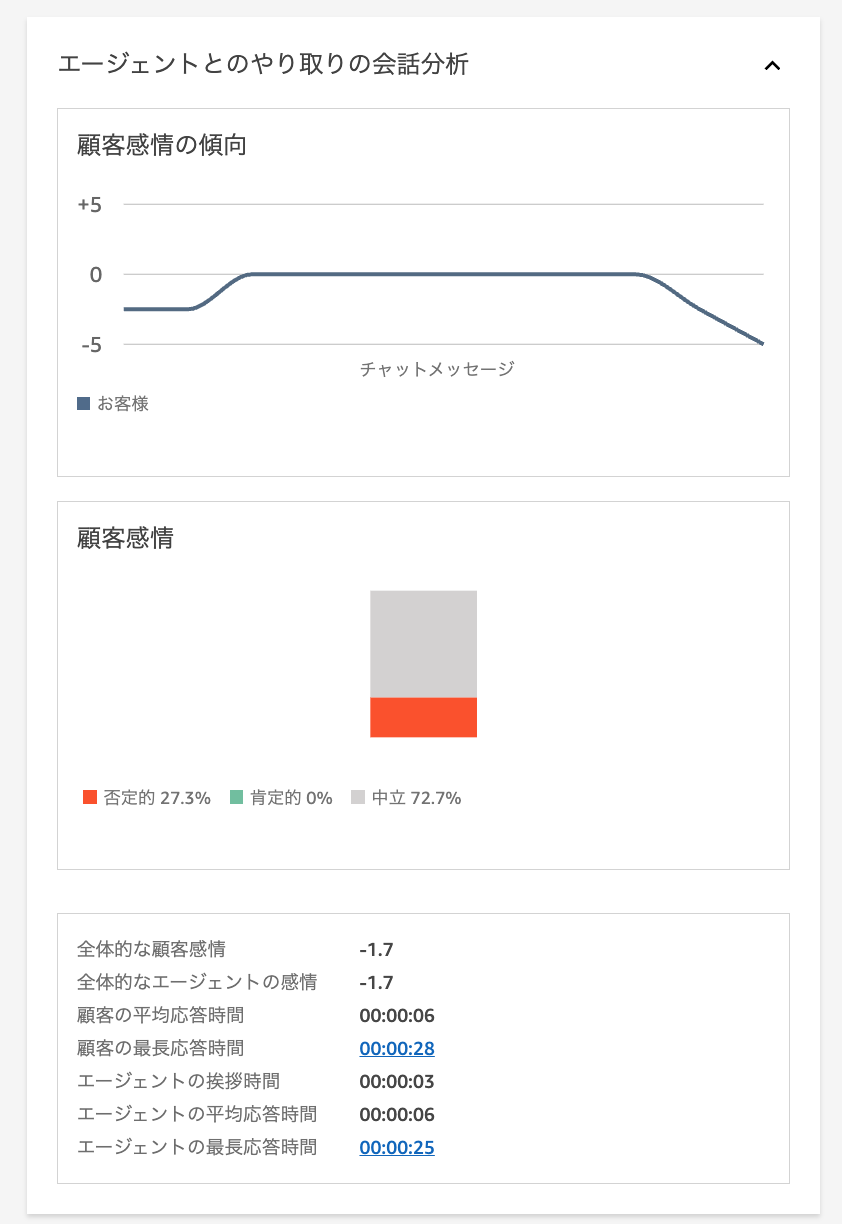

生成AIは利用されていません。Contact Lensの感情分析により、顧客の全体的な感情スコアは-1.7と算出されました。

セクション4: 効率性・プロセス遵守

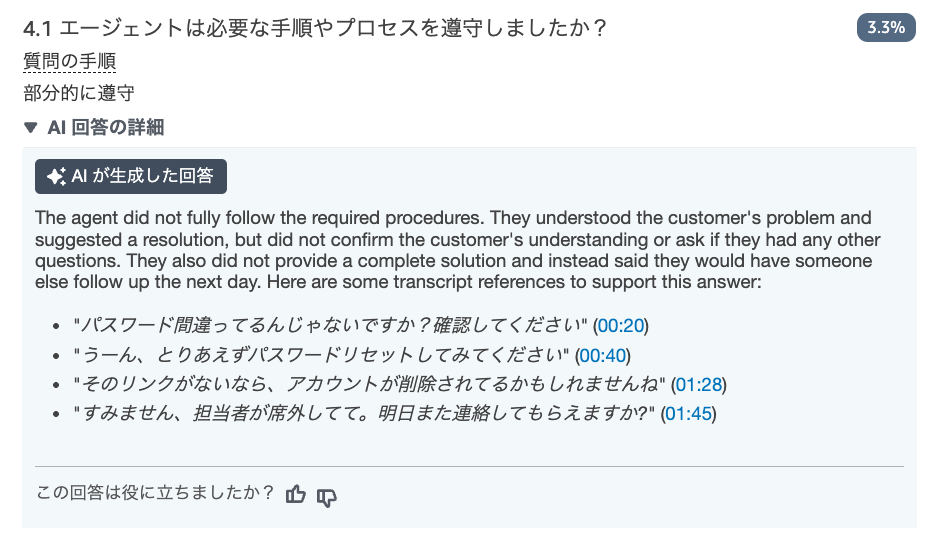

質問4.1: プロセス遵守

評価結果: 部分的に遵守(3点)

生成AIが生成した回答: エージェントは必要な手順を完全に従いませんでした。顧客の問題を理解し、解決策を提案しましたが、顧客の理解を確認したり、他に質問がないか尋ねませんでした。また、完全な解決策を提供せず、代わりに翌日に他の誰かがフォローアップすると述べました。

この回答を支持する会話記録の参考例:

- "パスワード間違ってるんじゃないですか?確認してください"

- "うーん、とりあえずパスワードリセットしてみてください"

- "そのリンクがないなら、アカウントが削除されてるかもしれませんね"

- "すみません、担当者が席外してて。明日また連絡してもらえますか?"

AIの評価は適切です。エージェントは基本的な手順をほとんど遵守しておらず、3点という低い評価は妥当です。

セクション5: 通話終了・満足度確認

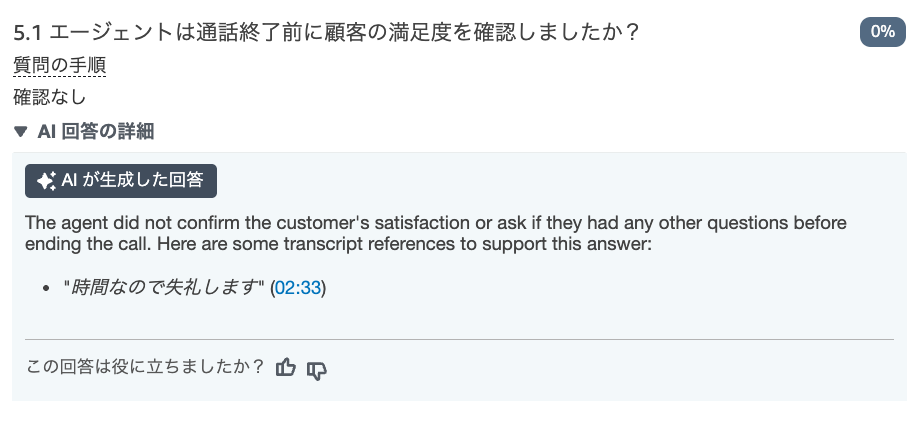

質問5.1: 顧客満足度確認

評価結果: 確認なし(0点)

生成AIが生成した回答: エージェントは通話終了前に顧客の満足度を確認したり、他に質問がないかを尋ねませんでした。

この回答を支持する会話記録の参考例:

- "時間なので失礼します"

AIの評価は正確です。エージェントは一方的にチャットを終了しており、満足度確認は一切行われていません。0点は妥当な評価です。

総合評価結果

総合スコア: 4.67/10点(46.7%)

セクション別スコア:

- セクション1(挨拶・開始対応): 25%

- セクション2(顧客対応・問題解決): 80%

- セクション3(コミュニケーション・感情管理): 50%

- セクション4(効率性・プロセス遵守): 30%

- セクション5(通話終了・満足度確認): 0%

全体を通して、生成AIによる評価は概ね適切でしたが、一部で甘めの評価が見られました。

特に「問題解決能力」「解決策の説明」「言葉遣い」の項目では、実際の対応内容に比べてやや高めの評価となっています。

これは生成AIが英語のみサポートのため、日本語のニュアンスや文脈を完全に理解できていない可能性があります。

一方で、挨拶や満足度確認などの明確な項目については、適切な評価が行われています。

まとめ

Amazon ConnectのAI評価機能を使用して、日本語での悪い対応事例を検証しました。

生成AIとContact Lensの組み合わせにより、不適切な顧客対応を検出し、全体的に適切な評価を行えることが確認できました。

今回の検証で確認できた点は以下のとおりです。

- 日本語の会話であっても、評価結果の根拠は正確で、実際の会話内容を適切に引用しています

- 今回の評価例では、エージェントの対応に多くの問題があり、46.7%という低いスコアが算出されました

- 明確な評価基準がある項目(挨拶、満足度確認など)については、AIの判定精度は非常に高いことが確認できました

- 一方で、主観的な要素を含む項目(言葉遣い、解決策の説明など)では、やや甘めの評価となる傾向が見られました。これは英語のみサポートのため、日本語のニュアンスを完全に理解できていない可能性があります

- 顧客の感情分析(-1.7スコア)は正確に機能し、不満を適切に検出できています

この検証により、Amazon ConnectのAI評価機能は日本語環境でも概ね適切に機能することが確認されましたが、より厳密な評価を求める場合は、評価基準の詳細化や配点の調整が有効でしょう。

AIの評価結果に不満がある場合は、以下の方法で調整してみましょう。

- 質問内容の見直し: より具体的で明確な質問に変更する

- [評価者向けの手順]の詳細化: 評価基準をより具体的に記載する

- 回答選択肢の調整: 選択肢を増やしたり、内容を変更したりする

- 配点の調整: 各回答選択肢の点数を変更する

なお、生成AI自体の判定ロジックは調整できませんが、上記の評価フォーム設定を調整することで、より適切な評価結果を得ることができます。

参考