![[アップデート] Amazon QuickSight の結合して作成した SPICE データセットの上限が 20 GB に引き上げれたので、上限エラーを発生させてみた](https://images.ctfassets.net/ct0aopd36mqt/wp-thumbnail-19e77b9a51519e08b94d0f688c125729/4f439c75e1ee56c70e315fa46fa45f81/amazon-quicksight?w=3840&fm=webp)

[アップデート] Amazon QuickSight の結合して作成した SPICE データセットの上限が 20 GB に引き上げれたので、上限エラーを発生させてみた

この記事は公開されてから1年以上経過しています。情報が古い可能性がありますので、ご注意ください。

いわさです。

Amazon QuickSight では複数のデータセットを結合して別のデータセットを作成することが出来ます。

単独の SPICE データセットにはエンタープライズエディションの場合は 1 TB までとういう上限があるのですが、複数から結合して作成したデータセットの場合は従来は 1 GB を超えることは出来ないという制限がありました。

が、先日のアップデートでこの上限が 20 倍の 20 GB まで拡張されました。

今回のアナウンスを受けてそもそも 1 GB を超える時の動きをちゃんと把握出来てなかったなと反省しつつ、サイズが超えた場合の挙動を改めて確認してみることにしました。

結合後のデータセットサイズが 20 GB を超える場合

今回は裏ルートから入手したこちらのドデカ CSV ファイルをアップロードしたいと思います。

5.7 GB あります。

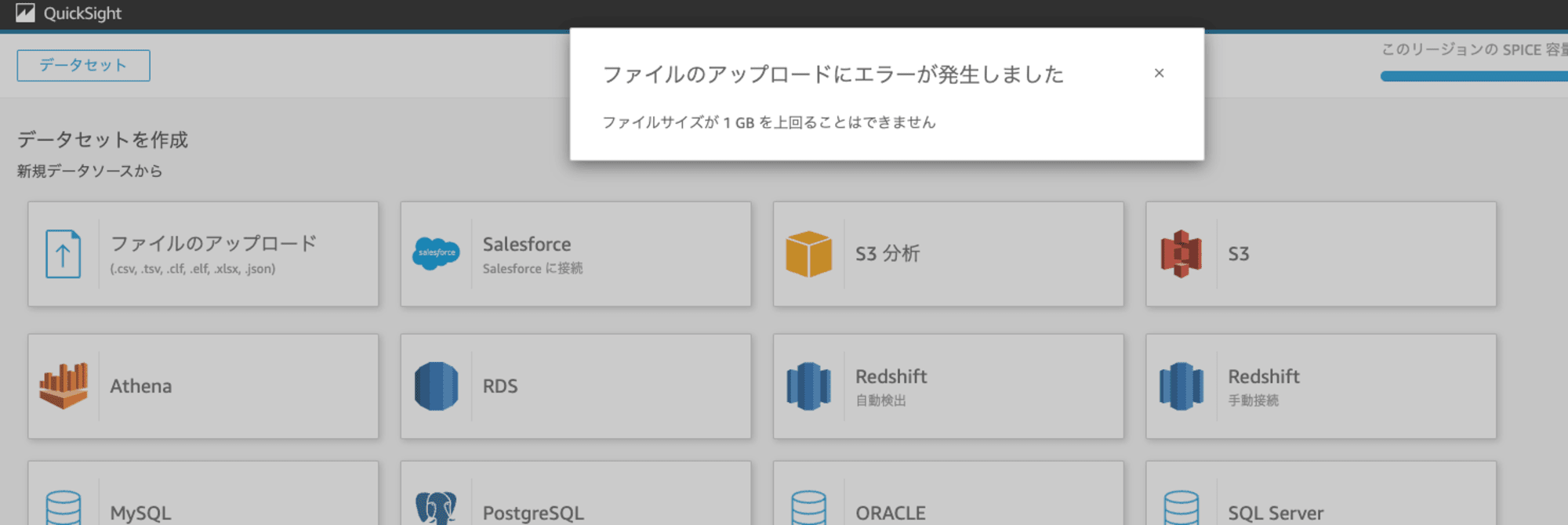

QuickSight のファイルアップロード機能は 1 GB の上限があるので、直接アップロードは出来ませんでした。

なので、S3 にアップデートしてマニフェストファイルを使ってデータセットへ取り込みを行います。

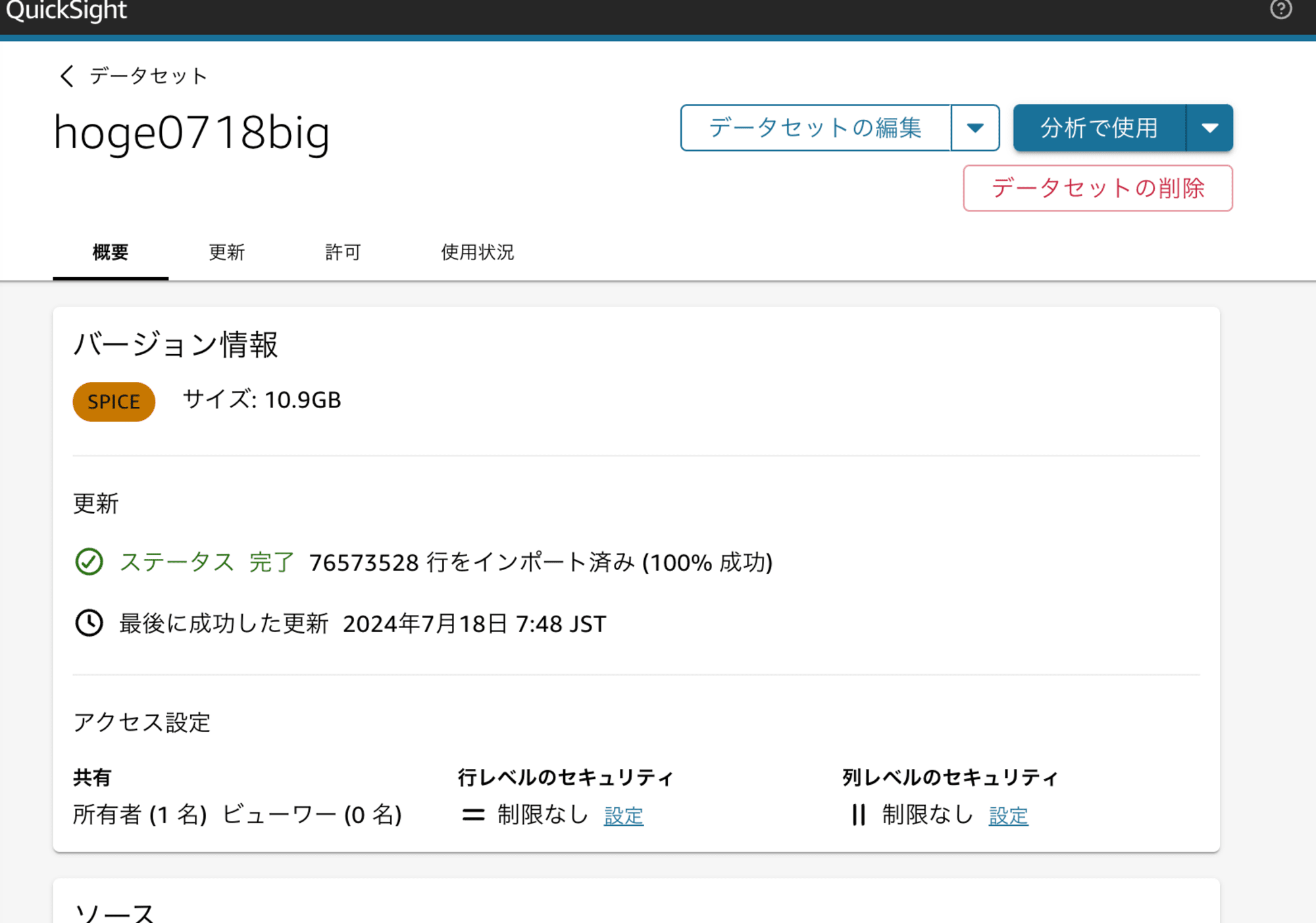

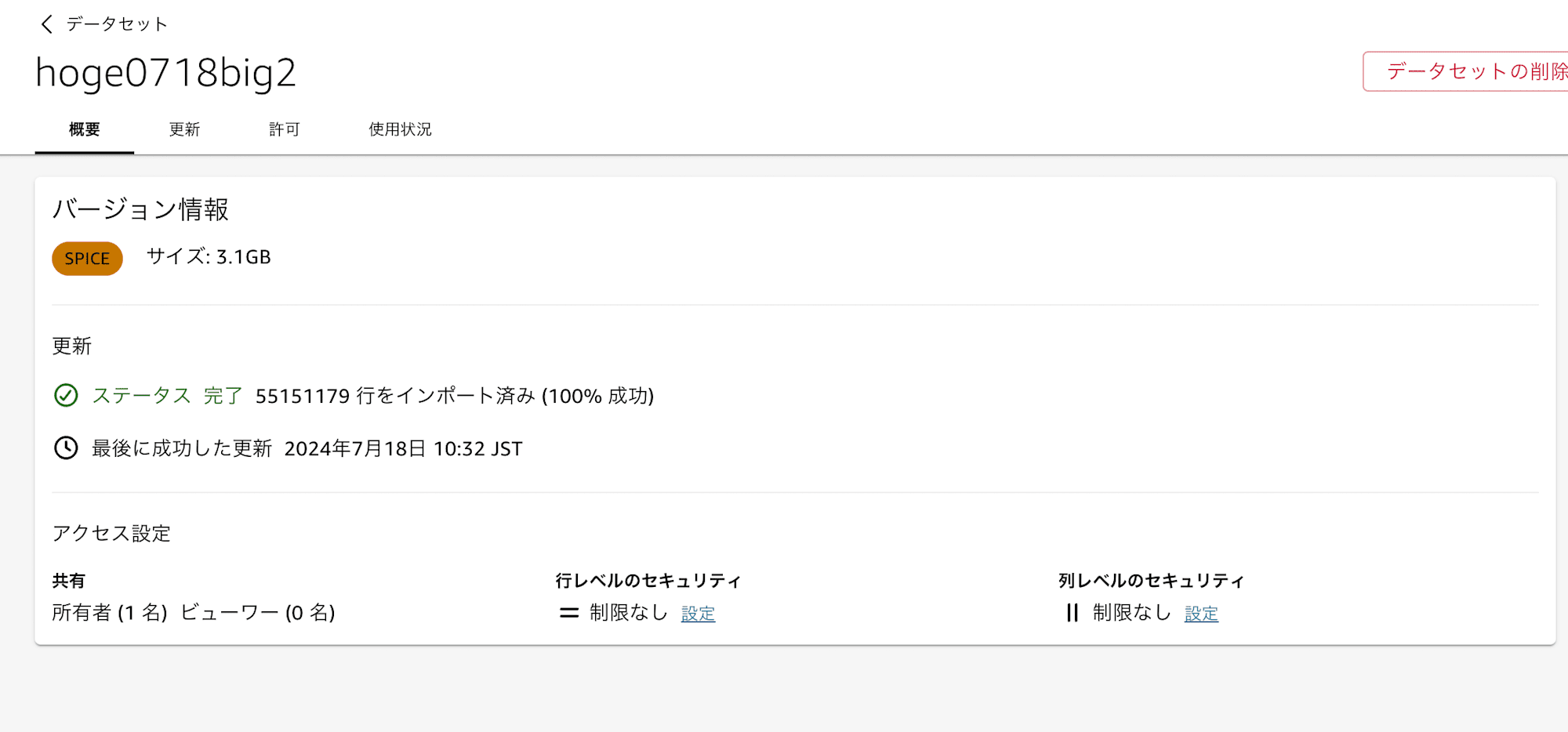

取り込むことが出来ました。

ただ、サイズがローカルファイルサイズよりもかなり大きくなっていますね。10.9 GB です。

このよに QuickSight の SPICE データサイズは独自の使用でフィールドサイズが算定されるので注意が必要です。

結合してみる

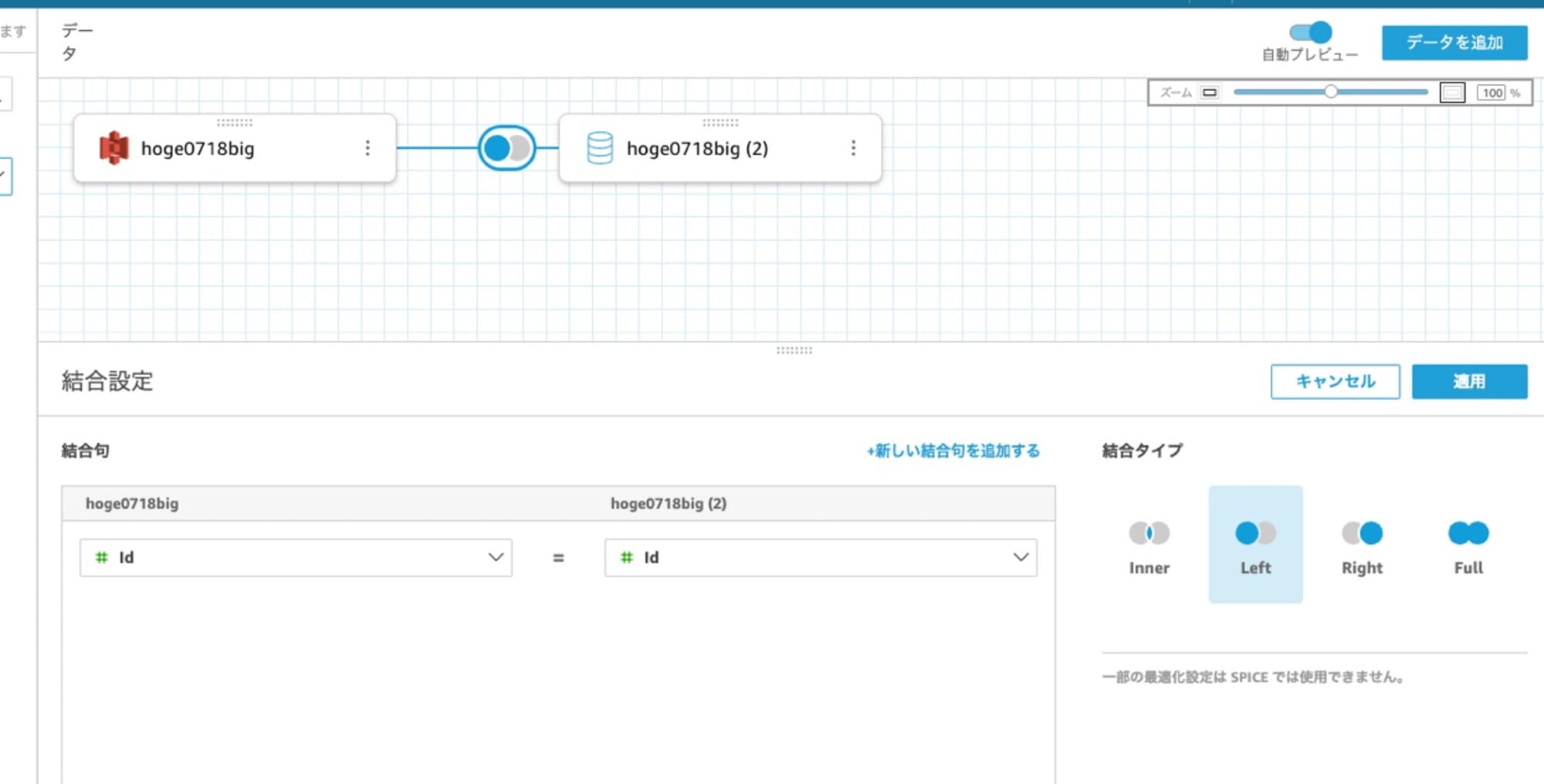

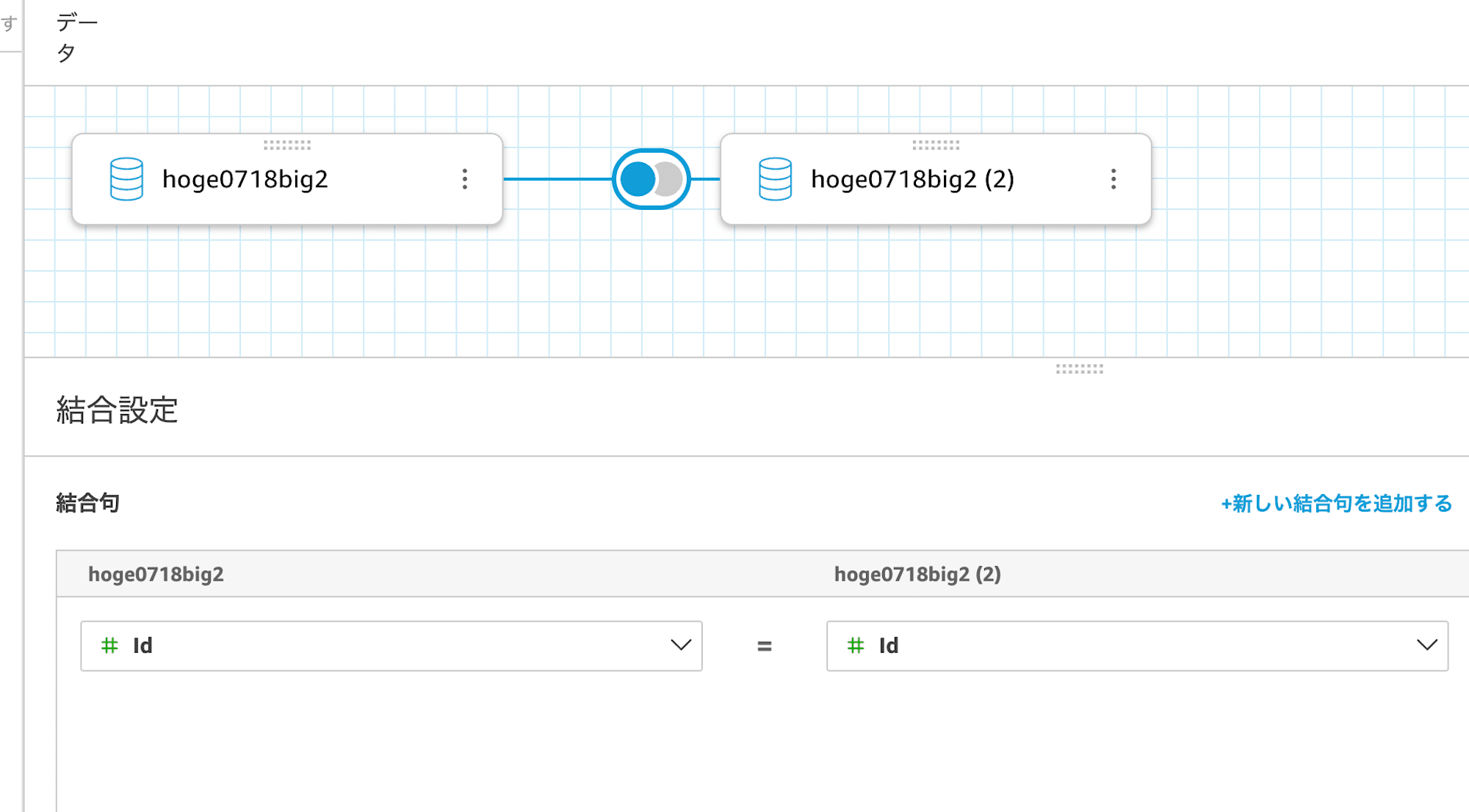

で、このデータセットを結合して新しいデータセットを作成してみます。

今回のアップデートでこの結合後のデータセットサイズが 20 GB を超えていなければ OK なはずです。

先ほど作成したデータセットをベースに、もう一つ同じデータセットを追加したものを作成します。

同じデータを ID で内部結合するので、データサイズは 2 倍程度(21.8 GB くらい?)になるはずです。

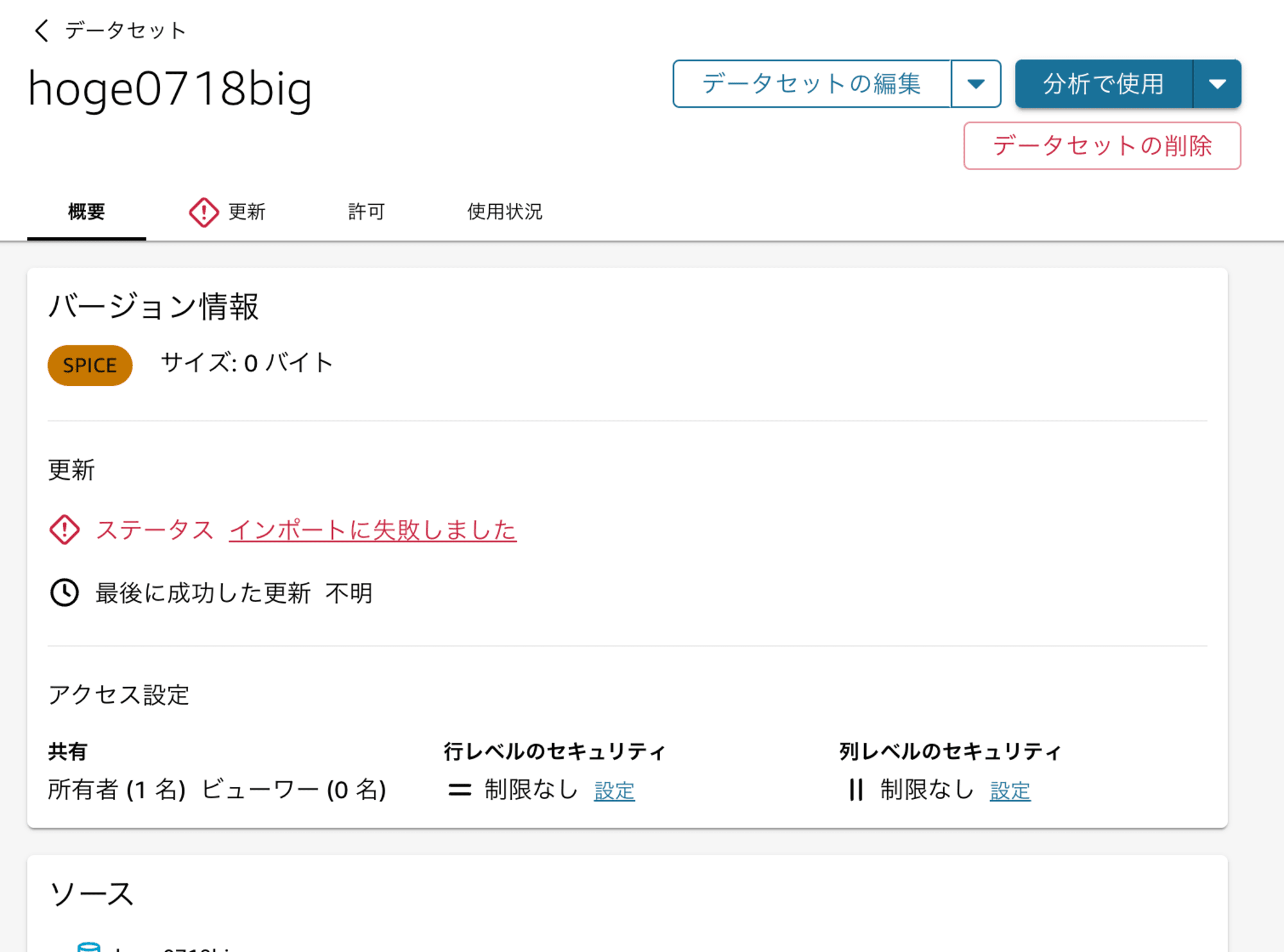

結合してデータのロード(更新)をしてみると、次のようにインポートに失敗しました。

エラー詳細を確認してみると、エラータイプはCUSTOMER_ERRORで、エラー詳細メッセージは次のようになっていました。

Memory capacity limitation exceeded for data sources in the join configuration.Breakdown of data source memory capacity in bytes by LogicalTableld at the point of failure

上限を超えてエラーになった旨と結合元の2つのデータセットのサイズについて説明されていますね。なるほど。

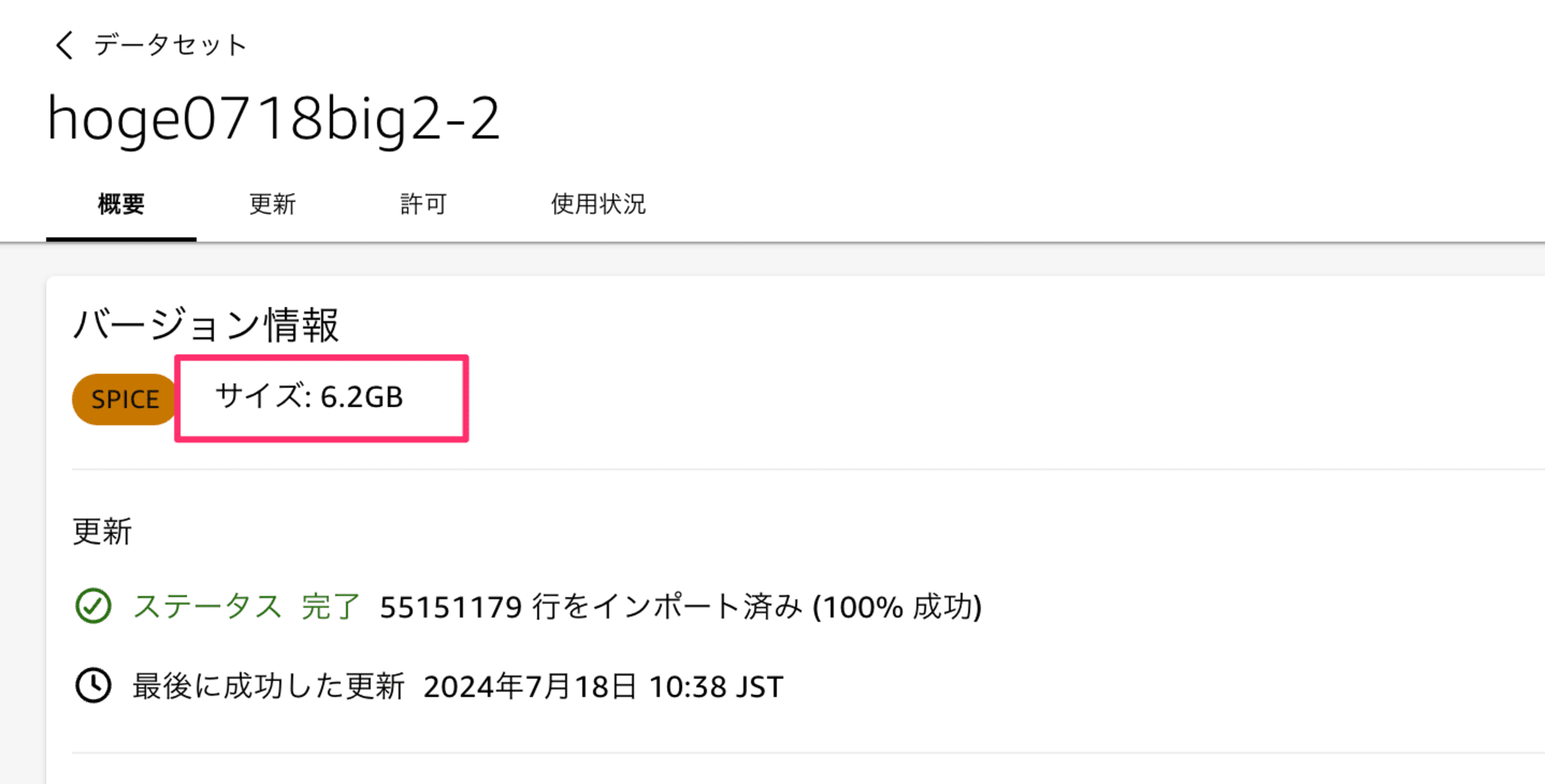

結合後のデータセットサイズが 20 GB を超えない場合

では今度は 20 GB を超えないかつ、1 GB は超えるデータで試してみます。

物理ファイルは 3.74 GB です。ステップは割愛しますが先ほど同じように S3 を経由して取り込みますからね。

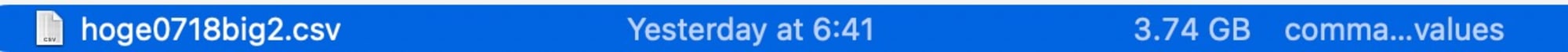

取り込み後、データセットのサイズは 3.1 GB になりました。

あれ?減ることもあるのですね。

こちらも先程と同じように結合してみます。

おっ、期待どおり 6.2 GB のデータセットが作成されました。

エラーも発生していませんね。

以前までは 1 GB が上限だったということなので、このサイズでも失敗していたということですね。多分。

さいごに

本日は Amazon QuickSight の結合して作成した SPICE データセットの上限が 20 GB に引き上げれたので、上限エラーを発生させてみました。

今まで結合 SPICE データセットの 1 GB 上限が問題になるケースが私の場合はたまたま無かったのですが、問題になっていた環境では嬉しいですね。