2026年のローカルLLM事情を整理してみた

はじめに

こんにちは、クラスメソッド製造ビジネステクノロジー部の森茂です。

2025 年から 2026 年にかけて、ローカル LLM 界隈の動きが激しすぎて追いつけなくなってきました。DeepSeek-R1 のインパクト、Ollama の機能拡充、Qwen2.5 の日本語性能向上、そして Claude Code がローカル LLM で動くようになったという話題。「そろそろちゃんとキャッチアップしないとマズい」と思い、自分の整理も兼ねてこの記事を書いてみました。

この記事では、普段 Claude Code や GitHub Copilot、Cursor などのコーディング AI を使っている開発者向けに、2026 年 1 月時点でのローカル LLM の選択肢を整理していきます。「どのモデルを選べばいいのか」「ライセンスは大丈夫なのか」「どれくらいのスペックが必要なのか」といった疑問に答えていきます。

API ユーザーがローカル LLM に移行する理由

オープンソース LLM の性能向上

2026 年に入り、オープンソース LLM の性能が急速に向上しています。特にコーディング領域では、一部のベンチマークで商用モデルに匹敵するスコアを出すモデルも登場しています。「オープンソースは商用モデルに比べて精度が低い」という認識は、徐々に過去のものになりつつあるかもしれません。

コスト構造の違い

API 課金と自前 GPU への投資では、コスト構造が大きく異なります。

API 課金は使った分だけ支払う形式で、利用量が少なければ安価です。一方、自前の GPU 環境は初期投資が大きいものの、利用量が増えるほど単価が下がります。月間のトークン処理量が一定を超えると、自前環境の方がトータルコストで有利になるケースもあります。

どちらが良いかは利用パターン次第ですが、「API 一択」ではなく「選択肢がある」という状況は嬉しいですね。

データ機密性への対応

「外部に出せないデータ」を扱う場合、ローカル LLM は有力な選択肢です。医療データ、金融データ、社内の機密情報など、コンプライアンス上クラウドに送信できないデータでも、ローカル環境なら安心して処理できます。

2026 年の主要モデル比較

ここからが本題です。2026 年 1 月時点で注目されている主要モデルを用途別に整理しました。

用途別おすすめモデル

| 用途 | 推奨モデル | 選定理由 |

|---|---|---|

| コーディング補完 | Qwen3 or Qwen2.5-Coder | JSON 出力が安定、Apache 2.0 ライセンス |

| コーディング(中型) | Devstral Small 2 | SWE-bench 68%、256K コンテキスト |

| 汎用チャット | Llama 3.3 | 128k コンテキスト対応、幅広いサイズ展開 |

| コスト効率重視 | Qwen3-30B-A3B | MoE 構造で実質 3B 稼働、Apache 2.0 |

| 軽量・エッジ | gpt-oss-20b or Qwen3-1.7B | 16GB/8GB で動作、推論モデル or 軽量汎用 |

| マルチモーダル | Gemma 3-27B | テキスト・画像・動画対応、140 言語 |

| 数学・推論 | Nemotron 3 Nano | AIME 89.1%、1M コンテキスト |

| 推論タスク | DeepSeek-V3.2 | GPT-5 レベル、推論・Agent 統合 |

モデル詳細比較

| モデル | 得意領域 | サイズ | ライセンス | 特徴 |

|---|---|---|---|---|

| Qwen3-14B | 汎用・日本語 | 14B | Apache 2.0 | Qwen2.5-32B 相当の性能 |

| Qwen3-30B-A3B | コスト効率 | 30B(稼働 3B) | Apache 2.0 | MoE で軽量動作 |

| Qwen2.5-Coder | コード生成・JSON | 0.5B〜32B | Apache 2.0 | 29 言語対応 |

| Qwen3-Coder | Agent・コード生成 | 480B(稼働 35B) | Apache 2.0 | 256K コンテキスト |

| Devstral Small 2 | コーディング | 24B | Apache 2.0 | SWE-bench 68%、256K コンテキスト |

| gpt-oss-20b | 推論 | 21B(稼働 3.6B) | Apache 2.0 | OpenAI 初のオープンウェイトモデル |

| GLM-4.7-Flash | 推論・高速生成 | 30B(稼働 3B) | MIT | 24GB 推奨、安定性に課題 |

| Gemma 3-27B | マルチモーダル | 27B | Gemma 独自 | 140 言語、128K コンテキスト |

| Nemotron 3 Nano | 数学・推論 | 31.6B(稼働 3.6B) | NVIDIA 独自 | Hybrid Mamba-Transformer MoE、20 言語対応 |

| DeepSeek-V3.2 | 推論・Agent 統合 | 671B(稼働 37B) | MIT | 推論・Agent 統合、R1 後継 |

| Kimi K2.5 | Agent・マルチモーダル | 1T(稼働 32B) | Modified MIT | Agent Swarm、256K コンテキスト |

| Llama 3.3 | 汎用チャット | 1B〜405B | Meta 独自 | 128k コンテキスト |

Qwen3 の登場で変わったこと

2025 年 4 月にリリースされた Qwen3 シリーズは、ローカル LLM の選択肢を大きく変えました。前世代の Qwen2.5 と比較して、同じパラメータ数でも性能が向上しています。ざっくり言うと、Qwen3-1.7B が Qwen2.5-3B 相当、Qwen3-14B が Qwen2.5-32B 相当の性能を発揮します。つまり、より少ない VRAM で同等の品質が得られるようになったわけです。

Qwen3 には Dense モデル(0.6B〜32B)と MoE モデル(30B-A3B、235B-A22B)があり、特に Qwen3-30B-A3B は総パラメータ 30B ながら実質 3B のみが稼働する MoE 構成で、16GB VRAM でも動作します。コスト効率を重視するなら有力な選択肢ですね。119 言語対応で日本語性能も高く、Qwen2.5 の日本語の強さをしっかり引き継いでいます。

また、2025 年 7 月にリリースされた Qwen3-Coder は、480B 総パラメータのうち 35B のみをアクティブにする MoE 構成で、SWE-Bench Verified で Claude Sonnet 4 に匹敵するスコアを記録しています。ただし、現時点では個人でローカル実行するのは現実的ではありません(要 290GB VRAM)。Coder 特化の小型バリアントについては今後のリリース待ちです。

個人的には、これからローカル LLM を始めるなら Qwen系から入るのが良いかなと思っています。

GLM-4.7-Flash が海外で話題になっている

2026 年 1 月 19 日、清華大学発の GLM-4.7-Flash がリリースされ、海外の AI コミュニティで注目を集めています。30B 総パラメータ(稼働 3B)の MoE 構成で、SWE-bench で 59.2%という高いスコアを記録しています(Qwen2.5-Coder の約 2.7 倍)。

注目されている理由は以下の通りです。

- 完全オープンソース(MIT ライセンス)

- 24GB〜 VRAM で動作(RTX 4090 や M3 Max で現実的)

- OpenAI/Claude API 互換で既存ツール(Cursor 等)に即対応

- API 料金が極端に安い(入力 $0.07/1M、出力 $0.40/1M)

ローカル実行も容易で、llama.cpp や text-generation-webui で動作確認されています。Qwen2.5-Coder と並んで、個人のローカル環境での有力な選択肢になりそうです。

日本語環境での注意点

ここで気になるのが日本語性能です。上記のモデルは英語中心で学習されているものが多く、日本語での利用には向き不向きがあります。

| モデル | 日本語性能 | 備考 |

|---|---|---|

| Qwen3 系 | ◎ | 119 言語対応、Qwen2.5 の強さを継承 |

| Qwen2.5 系 | ◎ | 業界最高クラス、GPT-4 を超えるスコアも |

| Qwen3-Coder | ◎ | Qwen3 ベースで 119 言語対応、日本語も良好 |

| Gemma 3 | ○ | 140 言語対応、日本語追加学習版あり |

| Nemotron 3 | ◎ | 20 言語対応、日本語 682.8B tokens で訓練。JCommonsenseQA 92.5%(1035/1119) |

| DeepSeek-V3.2 | ○ | V3 以降日本語正式対応 |

| Kimi K2.5 | ○ | 多言語対応、日本語専用ベンチマークは未公開 |

| gpt-oss | ○ | 多言語対応、日本語もそれなりに使える |

| GLM-4.7-Flash | ◎ | 日本語性能が高い、DeepSeek より上との評価 |

| Devstral Small 2 | △ | 英語・コード中心、日本語は限定的 |

| Llama 3.3 | △ | 英語中心、日本語で質問しても英語で返答も |

日本語で使う場合は、Qwen3 系を軸に検討するのが現実的です。「汎用チャット」用途で Llama 3.3 を挙げましたが、日本語環境では Qwen3-8B や Qwen3-14B の方が良い結果を得られそうです。(日本語性能については私の主観多めです・・・)

Nemotron 3 Nano は 20 言語対応で日本語訓練データも 682.8B tokens と豊富です。実際に DGX Spark 上で JCommonsenseQA(1,119 問、3-shot)を実施したところ、92.5%(1035/1119)という結果でした。Gemma 3 12B(91.8%)や gpt-oss:20b(92.7%)と同等クラスで、3.6B のアクティブパラメータでこの精度はすごいですね。NVIDIA は日本向けに Nemotron-Personas-Japan という合成ペルソナデータセット(100 万レコード、CC BY 4.0)も公開しており、日本語 LLM のファインチューニング用データとして活用が進んでいます。

また、Llama 系を使いたい場合は、ELYZA-Llama-3-JP-8B や Swallow などの日本語追加学習版も選択肢になります。Hugging Face で公開されており、Ollama でも利用可能です。

ライセンスで気をつけたいポイント

オープンソース LLM を商用利用する場合、ライセンスについても気をつけておきたいところ。「フリー」と言っても条件が異なるため、整理しておきましょう。

ライセンス分類

| ライセンス | 代表モデル | 商用利用 | 改変・再配布 |

|---|---|---|---|

| Apache 2.0 | Qwen、Mistral、gpt-oss | 完全フリー | 自由 |

| Meta 独自 | Llama 系 | 基本 OK(条件付き) | 条件付き |

| その他フリー | DeepSeek、GLM 等 | 基本フリー(規約確認推奨) | 規約による |

迷ったら Apache 2.0(Qwen/Mistral 系)を選んでおけば間違いないです。Llama も実質問題ないケースが多いですが、将来大規模化する可能性があるなら最初から Apache 2.0 ライセンスのモデルが安心ですね。

ハードウェア要件と選定の目安

「自分の環境でどのモデルが動くのか」は気になるポイントだと思います。VRAM 容量別に動かせるモデルの目安を整理しました。

VRAM 別モデル選定ガイド

| VRAM | 動かせるモデル | 量子化 | 用途 |

|---|---|---|---|

| 8GB | Qwen3-1.7B、Qwen 7B | 4bit | 軽い用途、実験 |

| 16GB | gpt-oss-20b、Qwen3-14B、Nemotron 3 Nano、Llama 8B | 8bit | 個人開発、コード補完 |

| 24GB | Devstral Small 2、Gemma 3-27B、GLM-4.7-Flash | 4bit | コーディング、推論 |

| 24GB | Llama 70B | 4bit | 本格利用、RAG |

| 48GB+ | Llama 405B | 8bit | 大規模プロダクション |

| 150GB+ | Qwen3-Coder-480B(量子化) | 4bit | エンタープライズ |

量子化について

「量子化」は、モデルの精度をある程度犠牲にして、必要なメモリを削減する手法です。4bit 量子化を使えば、本来 48GB 必要なモデルを 24GB で動かせることもあります。品質への影響は用途次第ですが、コーディング支援程度なら 4bit でも十分実用的です。

ツール選定ガイド

ローカル LLM を動かすためのツールはいくつかありますが、2026 年時点でのおすすめを整理しました。

主要ツール比較

| ツール | おすすめ度 | 特徴 | CPU MoE 対応 | 向いている人 |

|---|---|---|---|---|

| Ollama | ★★★★★ | 1 コマンドで動く、API 互換 | ✗ | まずCLI手軽に触ってみたい人 |

| vLLM | ★★★★☆ | 高スループット、プロダクション最適化 | △(補助的) | 大量リクエスト処理が必要な本番環境 |

| LM Studio | ★★★★☆ | GUI で視覚的に操作可能 | ◎ | 非エンジニア、GUI 好きな人 |

| llama.cpp | ★★★☆☆ | 軽量でカスタマイズ性が高い | ◎ | 上級者、エッジデバイス向け |

MoE モデルと CPU MoE Offloading の話

MoE モデル(Qwen3-30B-A3B、gpt-oss-120b など)は各トークン処理時に一部の Expert のみを活性化します。llama.cpp の --n-cpu-moe オプションを使うと、Expert 重みを CPU RAM に配置し、Attention 層を GPU VRAM に残すことで、限られた VRAM でも大規模 MoE モデルを実用的な速度で動かせます。LM Studio も v0.3.23 から GUI で同機能に対応しています。

コミュニティの報告では、gpt-oss-120b で Ollama の約 3.5 倍の速度が出たケースもあります(GitHub Issue #11772)。MoE モデルを本格的に使うなら、llama.cpp か LM Studio も検討してみてください。

なお、Apple Silicon の Mac や NVIDIA DGX Spark のような統合メモリ環境では、CPU と GPU が同じメモリプールを共有しているため、CPU MoE Offloading によるメモリ節約効果はありません。一方で、Expert の読み込みに PCIe 転送のボトルネックがないため、統合メモリは構造的に MoE モデルと相性が良いとも言えます。

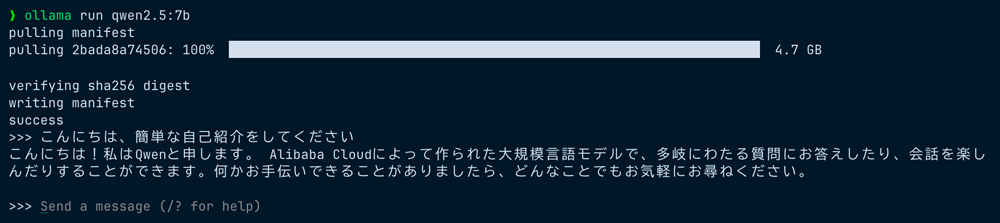

Ollama をおすすめする理由

初めてローカル LLM を試すなら、Ollama が簡単です。本格的なプロダクション環境で大量の同時リクエストを捌く必要がある場合は、vLLM が選択肢になります(セットアップは Ollama ほど簡単ではありませんが、高負荷時のスループットは Ollama の数倍〜20 倍近くになることもあるようです)。

# インストール(Mac/Linux)

curl -fsSL https://ollama.com/install.sh | sh

# モデル取得と実行

ollama pull qwen2.5-coder:7b

ollama run qwen2.5-coder:7b

ollama run を実行するとモデルの取得も自動で行われます。日本語での応答もスムーズ。

これだけでローカル LLM が動きます。Homebrew でのインストールにも対応しています。

# Homebrew でインストール

brew install ollama

Ollama は OpenAI 互換の API エンドポイントも提供しているため、既存のコードからの移行も容易です。「まずは Ollama で感触を掴む」というアプローチがおすすめですね。

なお、Web UI でモデルの管理やチャットを行いたい方には LM Studio もおすすめです。モデルの検索・ダウンロード・実行を GUI で完結でき、OpenAI 互換のローカルサーバー機能も備えています。CLI よりも視覚的に操作したい方は試してみてください。

API 互換性について

Ollama は OpenAI API 互換のエンドポイント(/v1/chat/completions)に加えて、Anthropic API 互換のエンドポイント(/v1/messages)も提供しています。v0.15 以降では ollama launch claude コマンドも追加され、Claude Code との連携も試せるようになりました。

ただし、Claude Code との連携については、現時点では課題もあります。詳細は関連記事「Ollama v0.15 で Claude Code をローカル実行できるか試してみた」で検証結果をまとめていますので、参考にしてみてください。

まとめ

最後に、ローカル LLM を始めるための具体的なステップをまとめます。

ステップ 1:モデルを選ぶ

| 用途 | 推奨モデル |

|---|---|

| コーディング(24GB+) | Devstral Small 2 or Qwen2.5-Coder |

| コーディング(16GB) | Qwen3-14B or gpt-oss-20b |

| 汎用チャット(日本語) | Qwen3-14B |

| 汎用チャット(英語) | Llama 3.3 |

| 軽量・お試し | Qwen3-1.7B or gpt-oss-20b |

ステップ 2:ハードウェアを確認する

VRAM 16GB 未満の場合は、4bit または 8bit 量子化モデルを選びましょう。MacBook の統合メモリでも動きますが、推論速度は専用 GPU に比べると遅くなります。

ステップ 3:Ollama で始める

# インストール

curl -fsSL https://ollama.com/install.sh | sh

# 汎用チャット(日本語)を試すなら

ollama pull qwen3:8b

ollama run qwen3:8b

# コーディング補完を試すなら

ollama pull qwen2.5-coder:7b

ollama run qwen2.5-coder:7b

今年は、オープンソース LLM が「趣味の実験」から「実務ツール」に移行するタイミングだと感じています。API 経験があれば、ローカル LLM への移行は想像より簡単です。

日本語環境では Qwen3 系が現時点ではおすすめです。Qwen3-14B は Qwen2.5-32B 相当の性能を半分以下の VRAM で動かせるので、コストパフォーマンスの面でも優秀です。まずは Ollama で Qwen3 を動かしてみて、感触を掴んでみてはいかがでしょうか。コスト削減やデータ機密性の確保など、ローカル LLM ならではのメリットを実感できるかもしれません。

参考リンク

- Ollama 公式サイト

- LM Studio 公式サイト

- vLLM 公式ドキュメント

- Hugging Face Open LLM Leaderboard

- Qwen3 公式ブログ

- Qwen2.5-Coder モデルカード

- Qwen3-Coder 公式ブログ

- Qwen3-Coder GitHub

- gpt-oss Hugging Face

- Devstral Small 2 公式ブログ

- GLM-4.7-Flash 公式(Z.AI)

- GLM-4.7-Flash Hugging Face

- Llama 3.3 公式ページ

- DeepSeek-V3.2 公式ブログ

- Kimi K2.5 Hugging Face

- Gemma 3 公式ブログ

- Gemma 3 Hugging Face

- Nemotron 3 Nano 公式ブログ

- Nemotron-Personas-Japan(HuggingFace)

- ELYZA 公式サイト