![[2025年9月3日号]個人的に気になったModern Data Stack情報まとめ](https://images.ctfassets.net/ct0aopd36mqt/wp-thumbnail-4c47f61cc8c1b97c00c0efcc68eab01b/ebc4f0c0223a249eae2f9de257dedbcd/eyecatch_moderndatastack_1200_630.jpg?w=3840&fm=webp)

[2025年9月3日号]個人的に気になったModern Data Stack情報まとめ

さがらです。

Modern Data Stack関連のコンサルタントをしている私ですが、Modern Data Stack界隈は日々多くの情報が発信されております。

そんな多くの情報が発信されている中、この2週間ほどの間で私が気になったModern Data Stack関連の情報を本記事でまとめてみます。

※注意事項:記述している製品のすべての最新情報を網羅しているわけではありません。私の独断と偏見で気になった情報のみ記載しております。

Modern Data Stack全般

The Vision of Vibe Data Modeling: Are Organisations Ready

Modern Data 101より、AIを活用した新しいデータモデリング「Vibe Data Modeling」のビジョンと、その実現に向けた組織の課題や具体的な準備方法について論じた記事が出ていました。

具体的には以下のような点について言及しています。(要約に生成AIを使用しています。)

- 「Vibe Data Modeling」を実現するためには、まず組織が強固な基盤を築く必要があり、特にLLMが理解しやすいKimballのStar SchemaやOBT(One Big Table)のようなDenormalizedなアプローチを推奨

- 具体的な実現ビジョンとして、以下の3ステップを提案している

- Level 1: Extend Your AI IDE

- CursorのようなAI対応IDEを拡張し、チームが採用しているデータモデリング手法(例:Kimball)を学習させ、依存関係のスキャンやドキュメント作成を自動化・支援させる方法について説明

- Level 2: Add MCP Power

- Level 1のIDEにMCP(Multi-modal Conversation Platform)の能力を追加するアプローチです。Google Meetの議事録やAWS S3に保存されたdbtのcatalog.jsonなどをAIが参照できるようにし、より豊かなビジネスコンテキストをモデルに与えることについて説明

- Level 3: More Tools

- さらにSlackのチャンネル履歴、Confluenceの過去ドキュメント、SQLクエリの直接実行といったツールを連携させることで、AIが手動での情報入力なしに、より深く、自律的にコンテキストを理解し、データモデリングを実行できるようにするビジョンについて説明

- Level 1: Extend Your AI IDE

Data Extract/Load

Omnata

新しいUIをパブリックベータ版としてリリース

Omnataの新しいUIがパブリックベータ版としてリリースされました。

これまではStreamlitの制約によりフィールドマッピング機能など使いにくい点があったのですが、新しいUIではより高速かつデータ型のチェックも行える仕様となっているようです。

Data Warehouse/Data Lakehouse

全般

SnowflakeとDatabricksのデータ共有サービス比較記事

Taroさんにより、Snowflake Secure Data SharingとDatabricks Delta Sharingに関する比較記事が出ていました。

技術的仕様や制限事項も含めて、非常に網羅された内容ですのでこの2製品のデータ共有サービスの違いを知りたい方には必読の記事だと思います。

個人的には特に以下の記述が印象に残りました。実際にSnowflakeとDatabricks間でのデータ共有が簡単に実装できると、プラットフォームを超えたデータビジネスが世界全体で推進しやすくなると思いますので、期待したいところです!!

我々もDatabricksで生成したデータをS2Sでデータ共有したり、またその逆にSnowflakeからDelta Table化してD2Dでデータ共有を行う事例もあります。我々がハイブリッドなデータ基盤を構築しているがゆえの考えかもしれませんが、一元的なデータ共有基盤構築そのものに価値を感じる事は少なく、2つのデータ共有方式を使い分けながら、よりスピーディによりセキュアに、ビジネスに貢献するデータ共有を一つでも多く生み出すことが最も重要な価値と考えています。提案させてもらったようにS2D/D2Sができるとさらに多くのビジネス価値を生み出すデータ共有がより簡単に実装できると考えています。

Snowflake

日本語文書から文字を抽出できるAI_EXTRACTとAI_PARSE_DOCUMENTがリリース

Snowflakeの新機能として、日本語文書から文字を抽出できるAI_EXTRACT関数(プレビュー)とAI_PARSE_DOCUMENT関数(一般提供)がリリースされました。

実際に試された記事としては、以下のMasato Takadaさんの記事が大変参考になります。この記事からの引用ですが、各種類似機能について、このような使い分けが出来そうです。

AI_EXTRACTは項目抽出に特化しており、定型文書の処理に最適です。

AI_PARSE_DOCUMENTは文書構造の理解に強みがあり、非定型文書の全文解析に適しています。

Q)AI_EXTRACTはDocument AIの違いとは?

A)とは類似してますが、異なるサービスです。AI_EXTRACTはSQLでの操作を対応している一方で、Document AIはSnowsightUI/ファインチューニング/Table Extractionまでもサポートしております。

Snowflake MLにおける分散処理機能としてMany Model Trainingと Distributed Partition Functionがリリース

Snowflakeの新機能として、Many Model TrainingとDistributed Partition Functionがリリースされました。

この機能については、たきこみさんの記事がとても参考になります。Many Model Trainingを用いて特定の列の値でデータを分割した上で並列で学習を行い、Distributed Partition Functionを用いて構築した複数のモデルに対して並列で推論を行っております。

Snowflakeのコスト最適化に関する記事

2025/8/10の記事にはなりますが、Snowflakeのコスト最適化に関する記事が出ていました。

ウェアハウスのサイジング、AUTO_SUSPENDの設定、パーティションプルーニングの活用、Transientテーブルの活用、など広い観点でコスト最適化に関する手法が述べられています。

PrivateLink経由でSnowflakeとセルフホスト版のGitLabリポジトリの統合

私と同じチームの安原より、PrivateLink経由でSnowflakeからセルフホスト版のGitLabリポジトリに接続することを試した記事が投稿されました。

今後はWorkspaceやdbt Projects on Snowflakeを用いてSnowflake上でGitを用いた

BigQuery

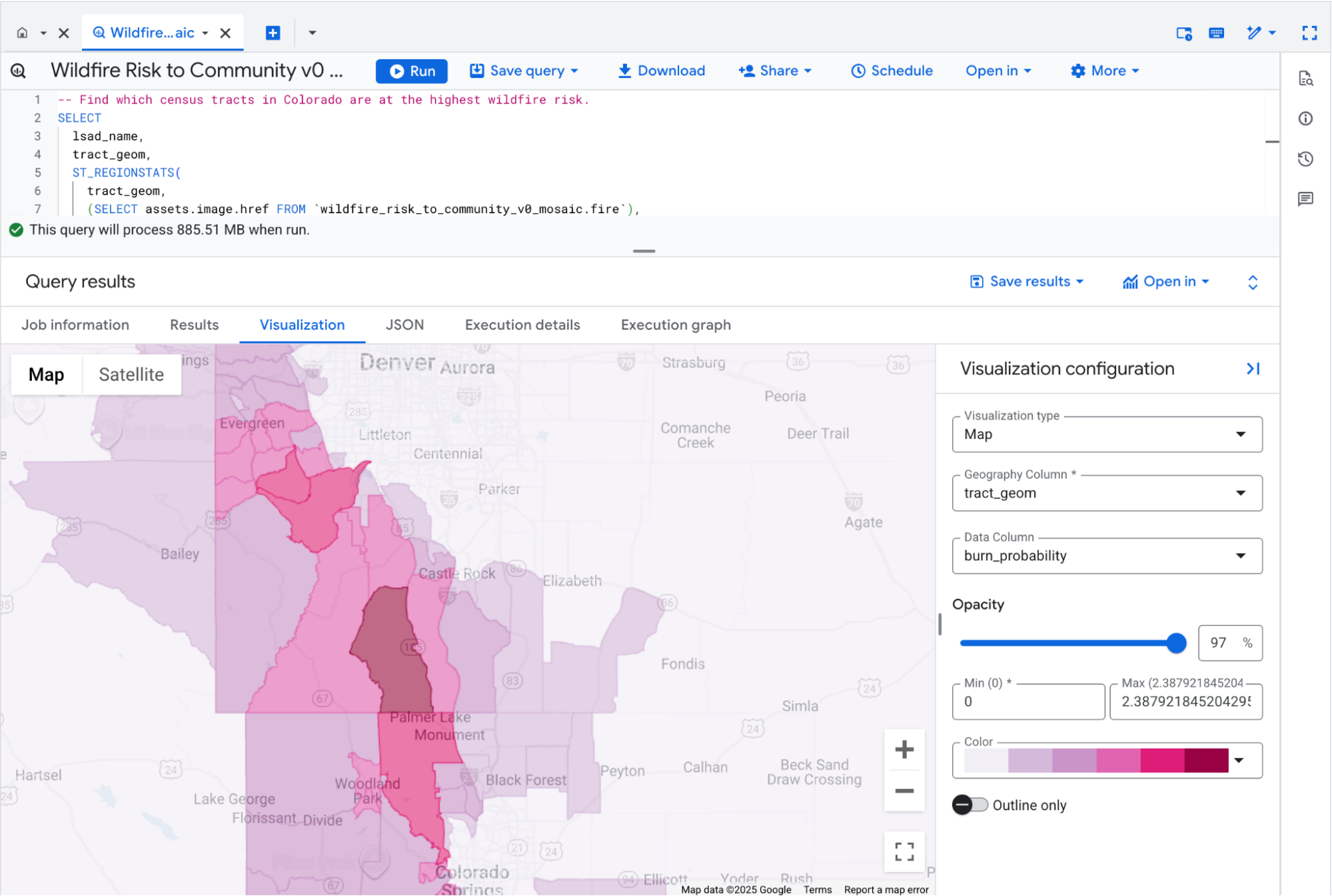

Earth Engineの一般提供

BigQueryで地理空間分析を行うための機能としてEarth Engineがありますが、こちらの機能が一般提供になったと以下のブログで言及がありました。(2025年9月3日時点、BigQueryのリリースノート上では記載なし)

今回の一般提供に伴い、BigQuery Studioの新しい地理空間可視化機能もプレビューとなっています。(下図は上記のリンク先から引用)

Databricks

外部のMCP Serverと接続できる機能をBeta版としてリリース

Databricksが外部のMCP Serverと接続できる機能をBeta版としてリリースしました。

これにより、Databricksのデータを元にして、外部のMCP Serverを提供しているソフトウェアと接続したエージェントの開発がよりしやすくなると思います。

Data Transform

dbt

dbt CloudにホストされたRemote dbt MCP Serverがリリース

dbt Cloudの新機能として、dbt CloudにホストされたRemote dbt MCP Serverがリリースとなりました。(現時点ではBeta版)

実際に私も試してみました!私が悪い可能性も大いにあるのですがまだ思うように動かせない点もあった一方で、RemoteのMCP Serverのためセットアップが非常に簡単でした!

dbt Cloudのジョブをyamlで定義できるdbt-jobs-as-code

私のブログで恐縮ですが、dbt Cloudのジョブをyamlで定義できるdbt-jobs-as-codeを試してみました。

CI Jobの定義が難しそうなど機能的な制限はありますが、dbt CloudのジョブはデフォルトだとGUIベースでしか定義できないため、コードで管理したい方にはピッタリの機能だと思います。

SQLMesh(Tobiko Cloud)

SQLMeshとSpice AIを用いたローカルでのAI活用

SQLMeshのブログより、SQLMeshとSpice AIを用いたローカルでのAI活用について言及したブログが出ていました。データソースの管理にはDuckDBを使っています。

Spice AIは私も初耳だったのですが、OSSとSaaSの2種で提供されている「AI + SQLのエンジンを統合したサービス」のようです。

Business Intelligence

Hex

Notebook環境に直接組み込まれたAIアシスタント「Notebook Agent」をリリース

Hexの新機能として、Notebookで直接利用できるAIアシスタントである「Notebook Agent」がリリースされました。

Notebook AgentはClaude Sonnet 4を活用し、自然言語での質問から分析計画、データ検索、SQLやPythonによるコード生成、可視化、結果の要約までを行えるとのことです。ユーザーは@メンションでコンテキストを指定したり、セル単位でコードの変更を確認・修正、ということも可能です。

Lightdash

one to many結合時のfan outにLightdashが対応

いつのリリースか私も認識していないのですが、harryさんのXでの投稿を見て、Lightdashがone to many結合時のfan outにLightdashが対応したことを発表していました。

以下がこのfan out対応について触れたドキュメントですが、たくまんさんのXでの投稿の通りといいますか、LookerとTableauそれぞれのfan out対策の間のような実装をされていて、興味深かったです!

Data Catalog

OpenMetadata

OpenMetadata 1.9がリリース

リリース自体は2025/8/8なのですが、Open Metadataの1.9がリリースされました。目玉機能としてはData Contracts機能の提供が挙げられます。Open Metadataは元々Data Quality rulesという機能でデータ品質を管理するための機能を提供していましたが、これを拡張した機能がData Contractsとなっています。

Data Orchestration

Kestra

2025/9/9にKestra 1.0がリリース予定

Kestraの初めてのメジャーバージョンリリースとなる1.0が2025/9/9にリリース予定であると、公式ブログにおいて投稿がありました。

Data Security

Satori

Commvault社がSatori社を買収

Commvault社が、データセキュリティとAIガバナンスのプロバイダーであるSatori社の買収を完了したことを発表しました。

Satoriについて弊社の過去ブログの引用ですが、このような製品となっております。

Satoriは2019年に創業された DataSecOps Platform を提供するイスラエルのスタートアップです。SatoriはSnowflakeやRedshiftといったクラウドDWHに対して、透過的なコントロール層として機能することで、企業のデータ基盤へセキュリティやプライバシーのベストプラクティスの適応を実現します。

主な機能は、利用状況の監視、DBユーザーの権限管理、データ利用のポリシーの設定、タグベースのマスキング機能です。これらの機能を透過的にSatori上で設定することができるので、ターゲットとなるRedshiftやSnowflakeとは分離して管理できる点が特徴的です。