Amazon Bedrock で利用可能になった OpenAIの gpt-oss-120b と gpt-oss-20bを試してみた

2025年8月5日、OpenAI社が オープンウェイト言語モデル「gpt-oss-120b」と「gpt-oss-20b」をリリースしました。同日、AWSのAmazon BedrockとAmazon SageMakerでも、これらのモデルが利用可能になったと発表されました。

今回は、北米オレゴンリージョン(us-west-2)のAmazon Bedrockで、これらのモデルのアクセスを有効化し、チャットプレイグラウンドで動作検証を行った結果を紹介します。

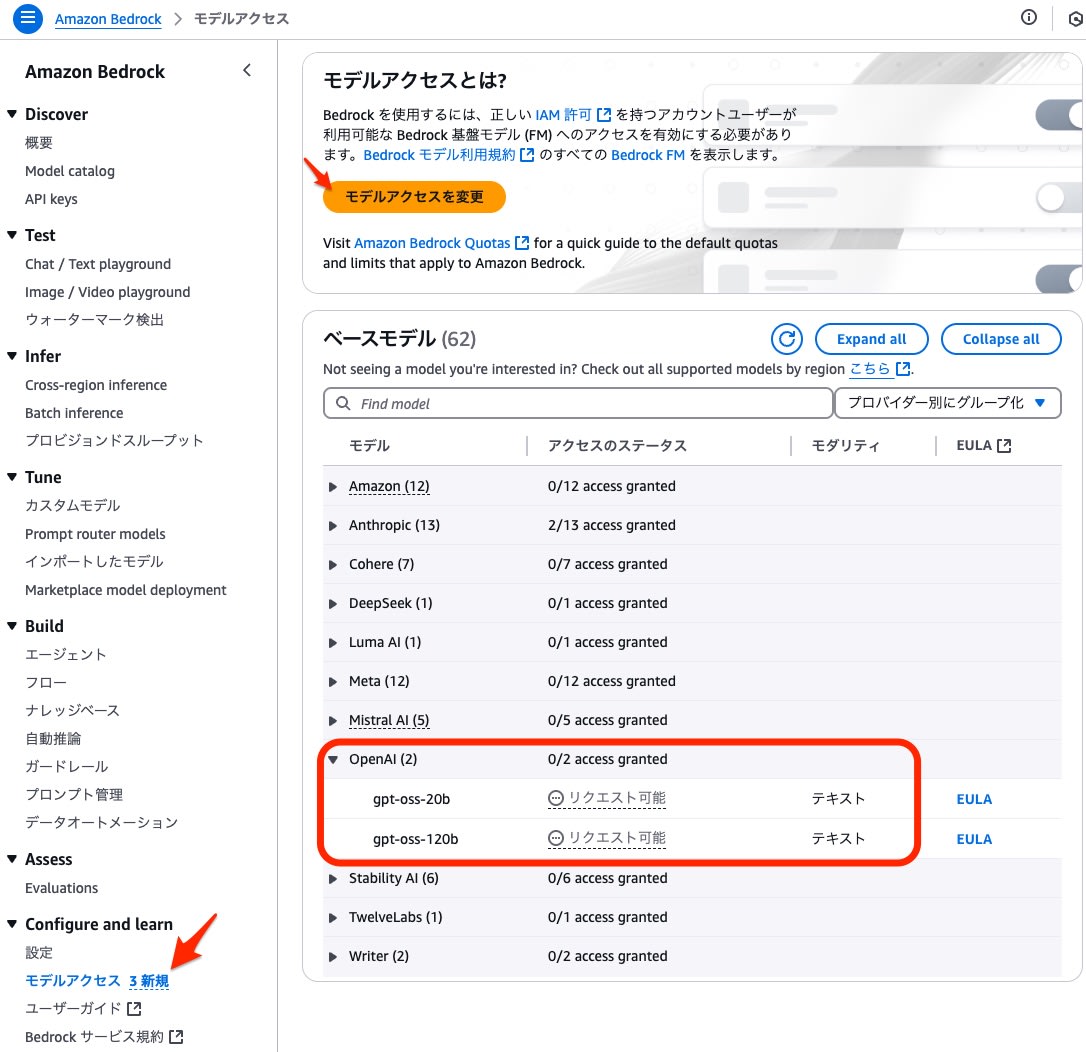

モデルアクセス設定

まず、オレゴンリージョン(us-west-2) のBedrockのダッシュボードで、プロバイダーとして「OpenAI」を選択し、「gpt-oss-120b」と「gpt-oss-20b」の利用をリクエストしました。

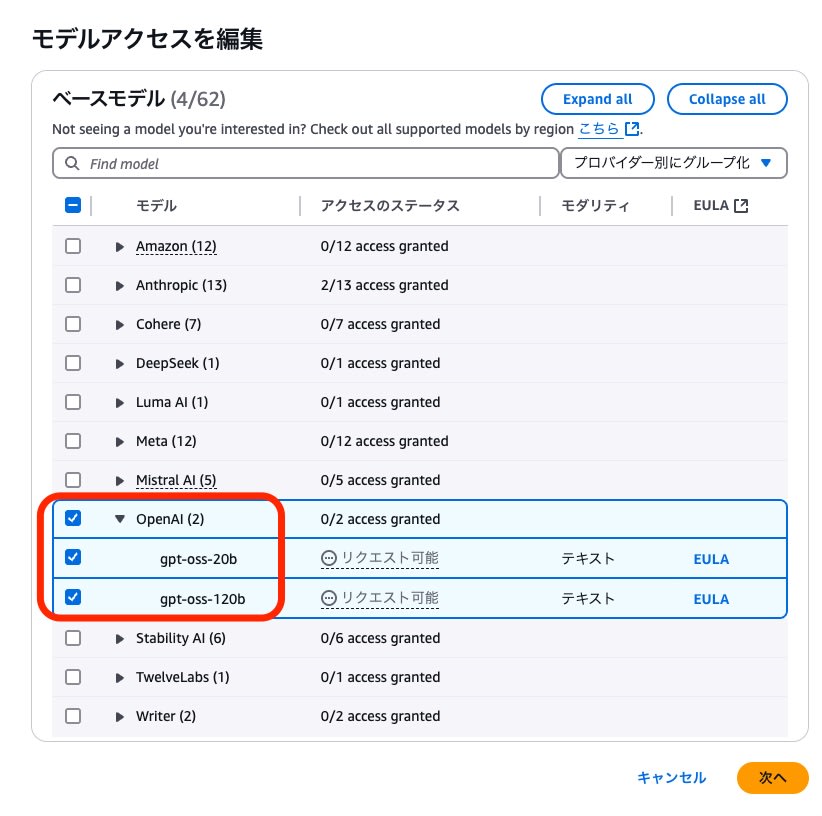

モデルアクセスを編集する画面で、これらのモデルをリクエストしました。

AWS CLIを使って、us-west-2リージョンでgpt-ossを含むモデルを検索したところ、以下の情報が取得できました。

$ aws bedrock list-foundation-models --region us-west-2 --query "modelSummaries[?contains(modelName, 'gpt-oss')]"

[

{

"modelArn": "arn:aws:bedrock:us-west-2::foundation-model/openai.gpt-oss-120b-1:0",

"modelId": "openai.gpt-oss-120b-1:0",

"modelName": "gpt-oss-120b",

"providerName": "OpenAI",

"inputModalities": [

"TEXT"

],

"outputModalities": [

"TEXT"

],

"responseStreamingSupported": false,

"customizationsSupported": [],

"inferenceTypesSupported": [

"ON_DEMAND"

],

"modelLifecycle": {

"status": "ACTIVE"

}

},

{

"modelArn": "arn:aws:bedrock:us-west-2::foundation-model/openai.gpt-oss-20b-1:0",

"modelId": "openai.gpt-oss-20b-1:0",

"modelName": "gpt-oss-20b",

"providerName": "OpenAI",

"inputModalities": [

"TEXT"

],

"outputModalities": [

"TEXT"

],

"responseStreamingSupported": false,

"customizationsSupported": [],

"inferenceTypesSupported": [

"ON_DEMAND"

],

"modelLifecycle": {

"status": "ACTIVE"

}

}

]

CLIの実行結果から、現時点では 入力・出力がTEXTのみで、"responseStreamingSupported": falseとなっているため、ストリーミング形式の応答には対応していないことがわかりました。

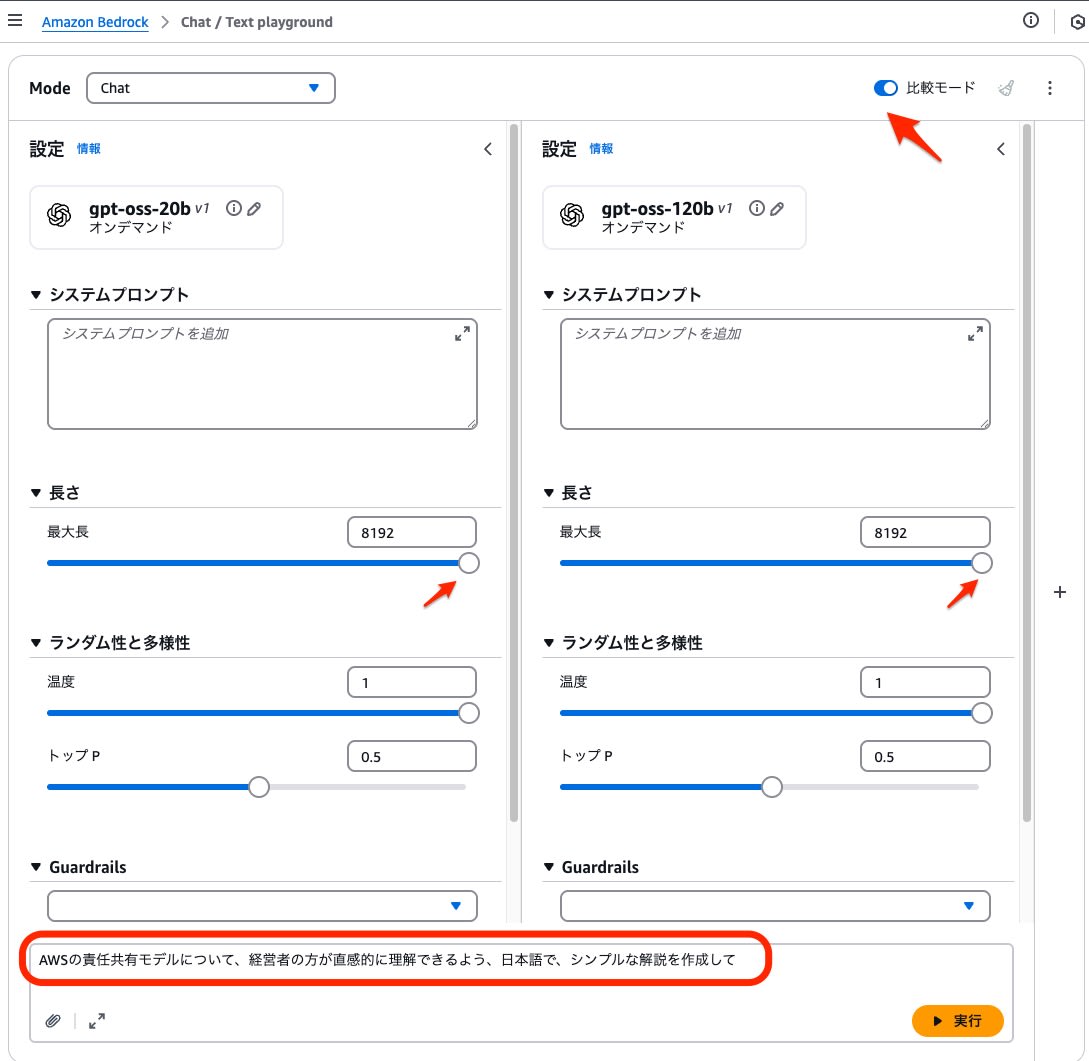

動作確認

Bedrockのチャットプレイグラウンドで、両モデルの動作を確認しました。

出力トークンの最大値(Maximum output tokens)は8192に設定し、その他の設定値はデフォルトのまま比較モードで実行しました。

以下のプロンプトを使用し、応答内容と所要時間を比較しました。

AWSの責任共有モデルについて、経営者の方が直感的に理解できるよう、日本語で、シンプルな解説を作成して。

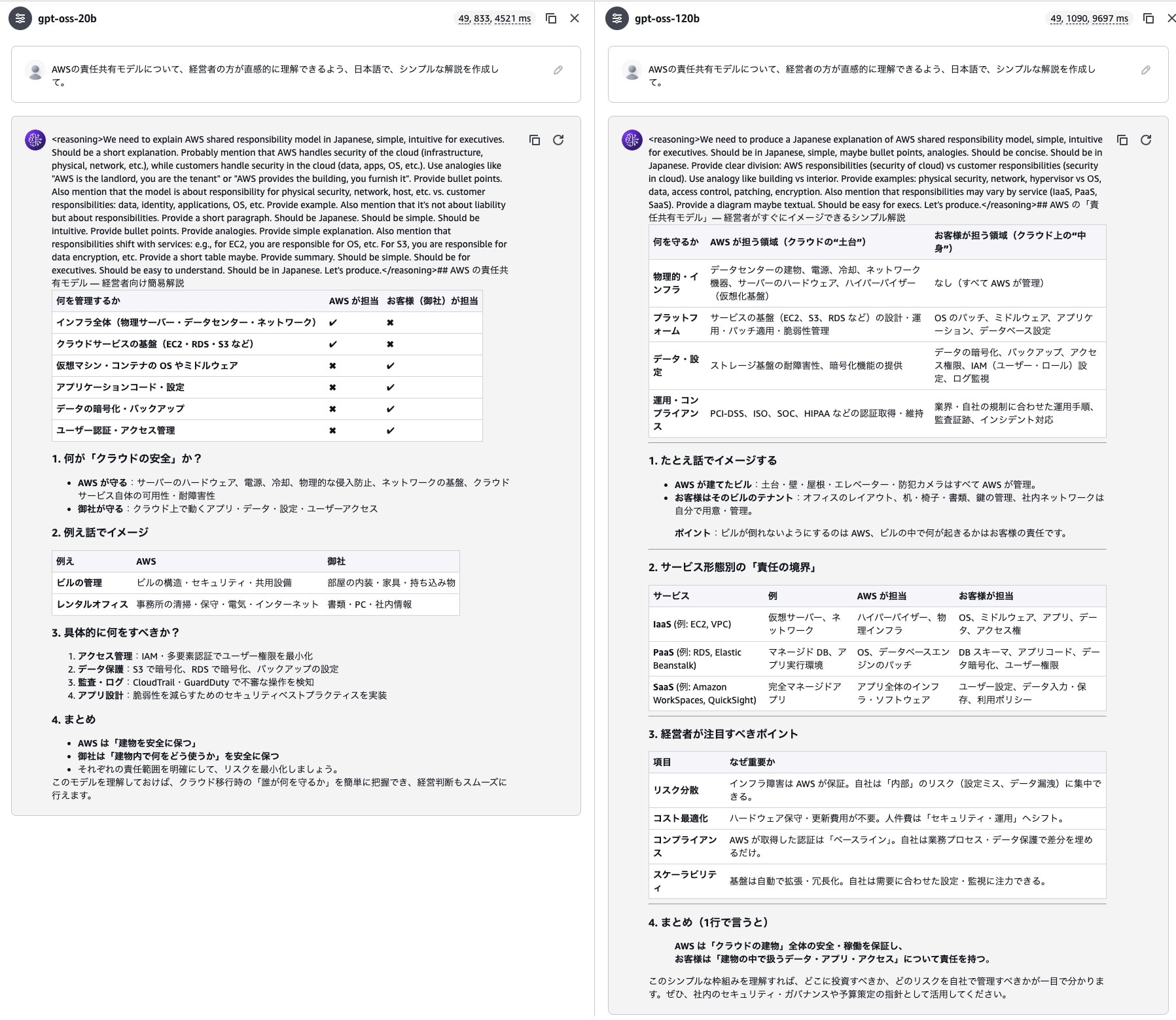

結果として、最初の見出し(H2要素)に一部崩れはあったものの、日本語のマークダウン形式で適切な回答を得ることができました。

価格の比較

Bedrockで利用可能な主要モデルと、gpt-ossシリーズの出力トークンあたりの課金単価を比較しました。

- オレゴンリージョンのBedrockをオンデマンド利用時の単価

| プロバイダ | models | Price per 1,000 output tokens | Sonnet4との比較値 |

|---|---|---|---|

| Amazon | Amazon Nova Micro | 0.00014 | 1% |

| Amazon | Amazon Nova Lite | 0.00024 | 2% |

| OpenAI | gpt-oss-20b | 0.00030 | 2% |

| OpenAI | gpt-oss-120b | 0.00060 | 4% |

| Anthropic | Claude 3 Haiku | 0.00125 | 8% |

| Amazon | Amazon Nova Pro | 0.00320 | 21% |

| Anthropic | Claude 3.5 Haiku | 0.00400 | 27% |

| Amazon | Amazon Nova Premier | 0.01250 | 83% |

| Anthropic | Claude Sonnet 4 | 0.01500 | 100% |

| Anthropic | Claude Opus 4.1 | 0.07500 | 500% |

この比較から、gpt-oss-20bは「Amazon Nova Lite」とほぼ同等の価格設定であり、上位モデルのgpt-oss-120bは「Claude 3 Haiku」の約半額で利用できることがわかりました。コストを重視するユースケースで、非常に有力な選択肢となりそうです。

スループット性能比較

他の主要モデルでも、先に利用したAWS責任モデルを尋ねるプロンプトを実行して、トークン数と所要時間を測定。1秒あたりに出力可能なトークン数(スループット)を比較しました。

| models | Output tokens | Latency (ms) | 出力トークン/秒 |

|---|---|---|---|

| gpt-oss-20b | 833 | 4521 | 184.3 |

| gpt-oss-120b | 1090 | 9697 | 112.4 |

| Amazon Nova Micro | 494 | 2646 | 186.7 |

| Amazon Nova Lite | 756 | 4744 | 159.4 |

| Amazon Nova Pro | 550 | 5640 | 97.5 |

| Amazon Nova Premier | 220 | 4407 | 49.9 |

| Claude 3 Haiku | 344 | 4972 | 69.2 |

| Claude 3.5 Haiku | 319 | 6410 | 49.8 |

| Claude Sonnet 4 | 580 | 13968 | 41.5 |

| Claude Opus 4.1 | 627 | 32731 | 19.2 |

gpt-oss-20bは最速クラスの「Amazon Nova Micro」に匹敵するスループット性能を持ち、gpt-oss-120bは「Amazon Nova Pro」を上回ることが確認できました。価格だけでなく、応答速度の面でも高いパフォーマンスが期待できます。

ローカルLLMとの比較

参考として、「gpt-oss-20b」をAmazon Bedrockで実行した場合と、ローカル環境(M4 Pro Mac上のLM Studio)で実行した場合のスループットを比較しました。

| models | Output tokens | Latency (秒) | 出力トークン/秒 |

|---|---|---|---|

| Bedrock | 833 | 4521 | 184.3 |

| ローカル(M4 mac) | 813 | 36172 | 22.4 |

ローカル環境の最適化設定が不十分な可能性はありますが、Amazon Bedrockはgpt-oss-20bの実行環境として、非常に優れたパフォーマンスを提供することが分かりました。

まとめ

新しくリリースされたオープンウェイトモデル「gpt-oss-20b」と「gpt-oss-120b」は、コストとパフォーマンスの両面で非常に優れた選択肢であることが確認できました。

特に、低コストかつ高速な処理が求められるタスクにおいて、これらのモデルは有効な候補となる可能性があります。

現時点では、Bedrockで提供されているOpenAIモデルは、リージョンや利用可能な機能に制限がありますが、今後のサービス拡張に期待したいと思います。