Claude Codeで他社 LLM を使う方法:OpenAIのgpt-5.2-proで実践

はじめに

お疲れ様です。あかつきです。

本記事では、Claude Code から Anthropic 以外の LLM を使えるようにする手順を紹介します。

設定例として OpenAI の gpt-5.2-pro を使います。

作業は次の3つです。

- 利用したい LLM の API キーを用意する

- LiteLLM Proxy を設定し、起動する

- Claude Code の接続先を変更する

なぜ LiteLLM Proxy が必要か

Claude Code は Anthropic の API 形式を前提にしています。

一方、Anthropic 以外の API はエンドポイントやリクエスト形式が異なるため、

そのまま接続すると動きません。

そこで、LiteLLM Proxy を API の窓口として挟むことで、

Claude Code が求める形式に合わせつつ、裏側で他社の LLM へルーティングできます。

事前準備

次を用意します。

- Claude Code

- 利用したい LLM の API キー

- LiteLLM Proxy 用の

master_key(任意の文字列で構いません) - Proxy の起動手段 (どちらか)

- Docker

- または

uv+ Python 実行環境

API キーの取得手順は本記事では扱いません。

手順

1. config.yaml を作成

作業ディレクトリに config.yaml を作成します。

今回は gpt-5.2-pro を例にします。

model_list:

- model_name: gpt-5.2-pro

litellm_params:

model: openai/gpt-5.2-pro

api_key: "YOUR_OPENAI_API_KEY"

general_settings:

master_key: "YOUR_PROXY_MASTER_KEY"

別のモデルで試す場合は、model と api_key を差し替えます。

識別しやすいように model_name も変更してください。

2. LiteLLM Proxy を起動

Docker で起動する方法と、ローカル CLI で起動する方法があります。

Docker で起動

外部公開を避けるため、ポートはローカルホストにバインドします。

docker run --rm -p 127.0.0.1:4000:4000 \

-v "$PWD/config.yaml:/app/config.yaml:ro" \

docker.litellm.ai/berriai/litellm:main-stable \

--config /app/config.yaml

ローカル CLI で起動

まず uv で litellm をインストールします。

uv tool install 'litellm[proxy]'

uv tool update-shell

ターミナルを再起動し、ローカルホストに限定して起動します。

litellm --config config.yaml --host 127.0.0.1 --port 4000

3. Proxy の動作確認

別のターミナルでヘルスチェックします。

curl http://127.0.0.1:4000/health \

-H "Authorization: Bearer YOUR_PROXY_MASTER_KEY"

ステータスが ok であれば、次へ進みます。

この段階でもモデルの疎通を確認できますが、念のため個別に疎通を確認します。

curl -s http://127.0.0.1:4000/v1/chat/completions \

-H "Authorization: Bearer YOUR_PROXY_MASTER_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-5.2-pro",

"messages": [{"role":"user","content":"hello"}]

}'

成功すると、OpenAI 互換のレスポンスが返ってきます。

jq で整形すると確認しやすいです。

Claude Code で使用

~/.claude/settings.json に設定すると永続化できます。

ただし、普段の Claude Code の挙動も一緒に変わります。

ここでは、環境変数で一時的に切り替える方法を推奨します。

export ANTHROPIC_BASE_URL="http://127.0.0.1:4000"

export ANTHROPIC_AUTH_TOKEN="YOUR_PROXY_MASTER_KEY"

export ANTHROPIC_MODEL="gpt-5.2-pro"

claude

普段の設定に戻す場合は、次で解除できます。

unset ANTHROPIC_BASE_URL ANTHROPIC_AUTH_TOKEN ANTHROPIC_MODEL

運用では、alias化しておくと切り替えが簡単です。

動作例

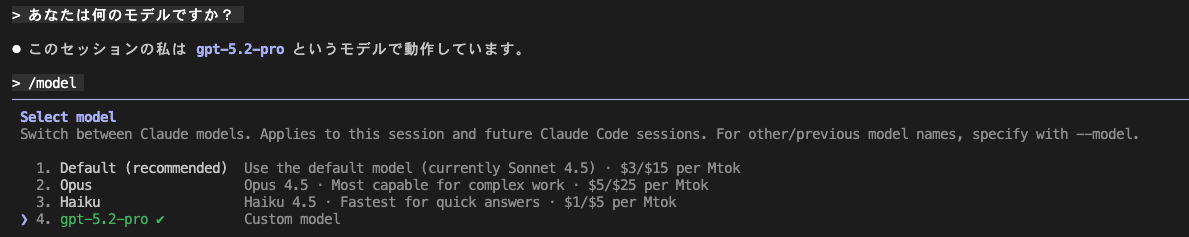

gpt-5.2-pro を Claude Code に入れてみた画面です。

料金の注意点

モデルによって料金体系が大きく変わります。

特に今回紹介した gpt-5.2-pro は高額になりやすいので注意してください。

まとめ

Claude Code から他社の LLM を使うには、

API 形式の差を埋める必要があります。

そのため、LiteLLM Proxy を挟み、接続先を切り替える必要があります。

同じような手順で、別のモデルも追加できます。

config.yaml の model_list にモデルを増やし、

ANTHROPIC_MODEL を切り替えるだけです。

ただし、API 利用のためコストに気をつけつつ、

必要な場面で目的に合った LLM を使い分ける必要があります。

参考資料

- Claude Code の LLM Gateway 設定: https://code.claude.com/docs/en/llm-gateway

- Cline と LiteLLM Proxy: https://dev.classmethod.jp/articles/cline-litellm-proxy-bedrock

- LiteLLM Proxy CLI 入門:

https://dev.classmethod.jp/articles/getting-started-with-litellm-proxy-cli/ - LiteLLM 公式ドキュメント: https://docs.litellm.ai/#step-1-create-configyaml

クラスメソッドオペレーションズ株式会社について

クラスメソッドグループのオペレーション企業です。

運用・保守開発・サポート・情シス・バックオフィスの専門チームが、IT・AIをフル活用した「しくみ」を通じて、お客様の業務代行から課題解決や高付加価値サービスまでを提供するエキスパート集団です。

当社は様々な職種でメンバーを募集しています。

「オペレーション・エクセレンス」と「らしく働く、らしく生きる」を共に実現するカルチャー・しくみ・働き方にご興味がある方は、クラスメソッドオペレーションズ株式会社 コーポレートサイト をぜひご覧ください。※2026年1月 アノテーション㈱から社名変更しました