OpenAIの「gpt-oss-20b」を Mac Mini (M4 Pro) で試してみた

2025年8月5日、OpenAI社が オープンウェイト言語モデルの gpt-oss-120b と gpt-oss-20b をリリースしました。

OpenAI o3-miniに匹敵するとされ、16GB程度のVRAMで 動作するオープンモデル「gpt-oss-20b」を、

ローカルLLMの実行環境として LM Studio をインストールしたMac Mini(M4)環境で試す機会がありましたので、その手順と性能を紹介します。

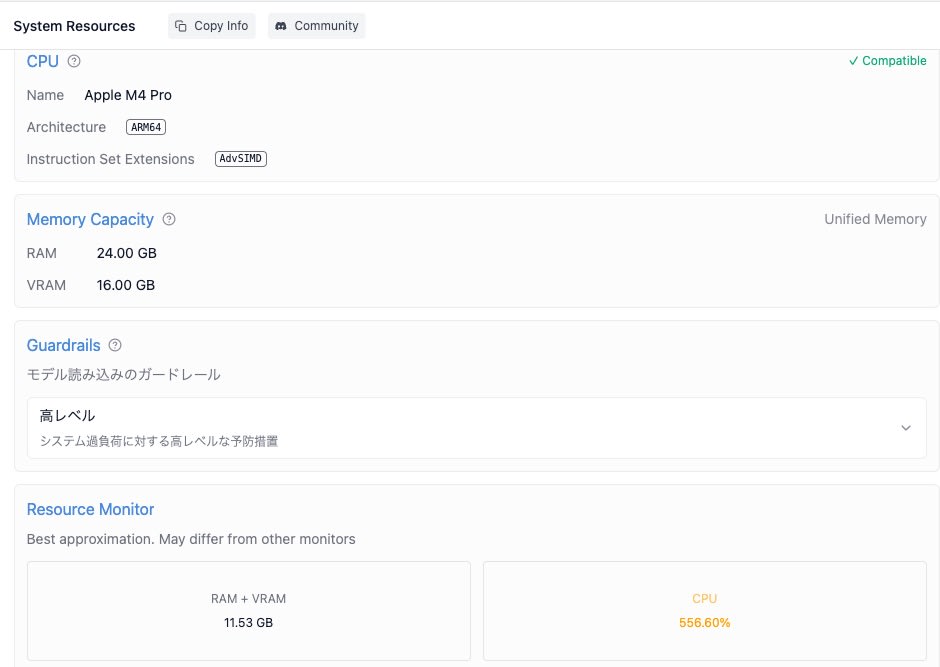

実行環境

以下スペックの Mac mini 2024 を利用しました。

-

チップ Apple M4 Pro

- 12コアCPU

- 16コアGPU

-

メモリ 24GBユニファイドメモリ

- RAM 24.00 GB

- VRAM 16.00 GB

-

macOS Sequoia 15.6

LM Studio

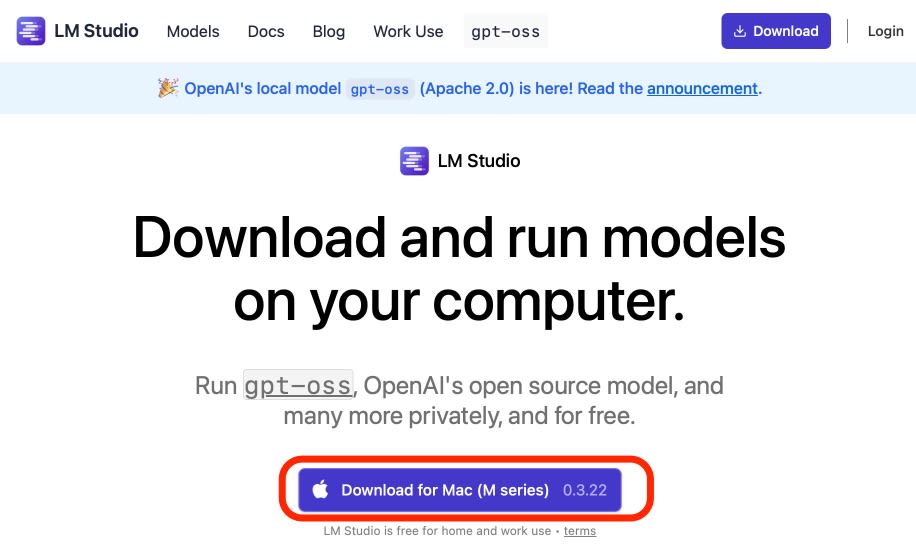

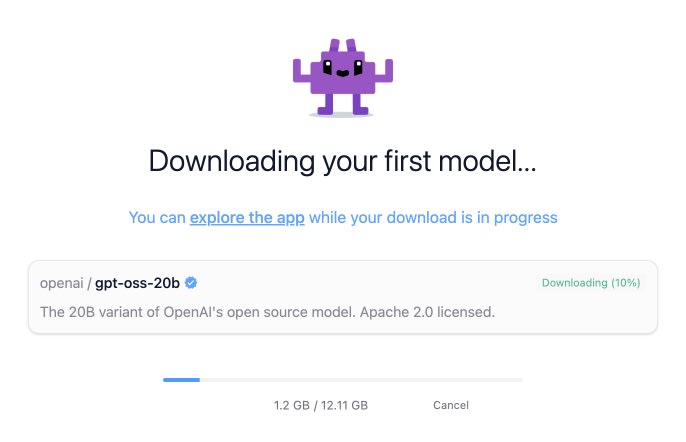

ダウンロード

LM Studioの公式サイトから、Mac用のインストーラ(0.3.22)をダウンロード

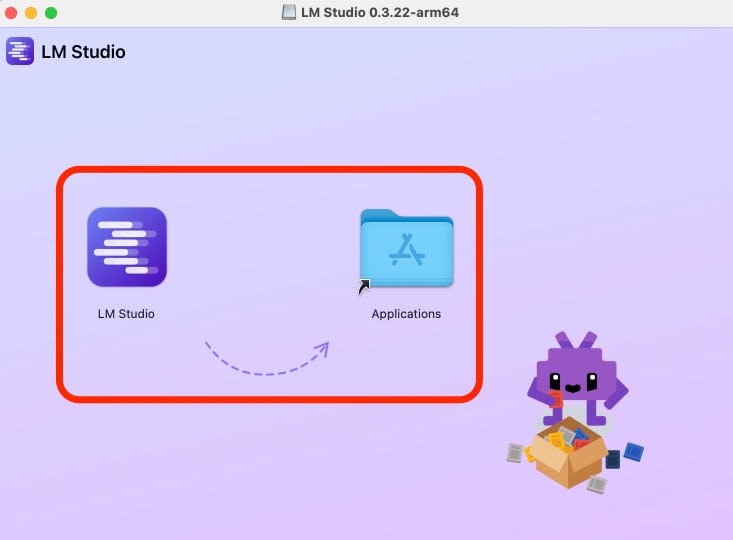

インストール

アプリケーションフォルダにインストールして実行

初期設定

レベルの選択は「User」

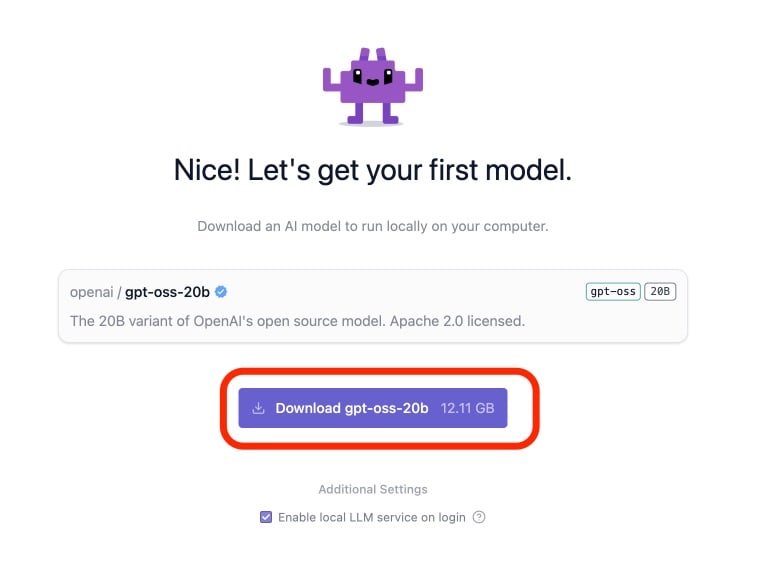

初期モデルとして案内された、「openai / gpt-oss-20b」をダウンロード

他の設定のカスタマイズは実施せず、「Start a New Chat」よりチャット動作を確認しました。

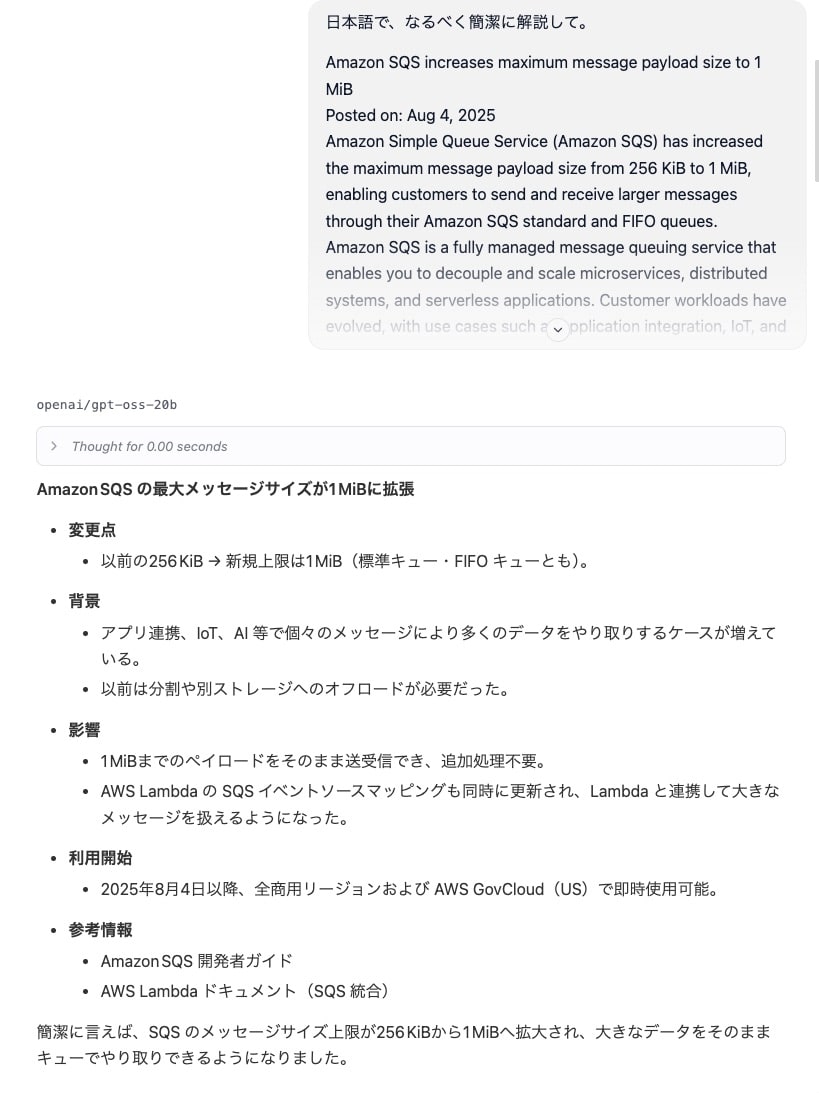

先日のSQSのペイロードサイズが1MiBに拡張されたアップデートの英文記事テキストから、日本語での解説を求めるプロンプトを試しました。

短い文書でしたが、自然な日本語で的を射た回答を得る事ができました。

動作中のキャプチャ動画

リソース消費

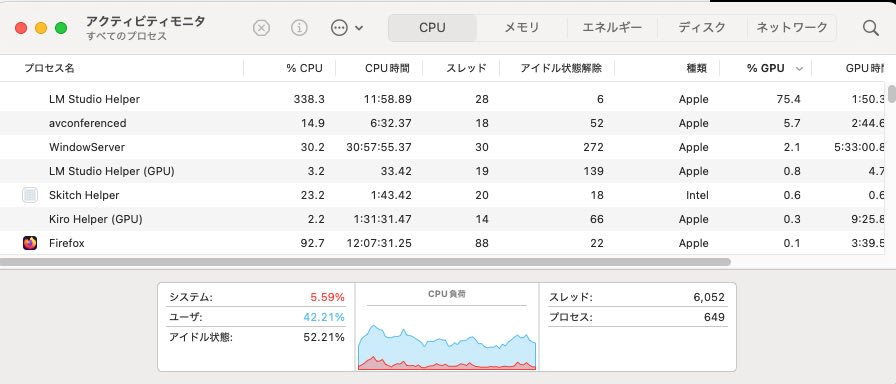

要約処理を実行中のCPU使用率は300〜500%、搭載コアの1/2前後、メモリはRAMを11.5GBほどの消費でした。

まとめ

従来リリースされていたローカルLLMと比較して高性能とされる 「gpt-oss-20b」、メモリ24GB搭載のMac環境で使える事が確認できました。

80GBのGPUを必要とする 「gpt-oss-120b」も、より多くのユニファイドメモリが利用できる Mac Studioなどであれば、実用できる可能性があると思われます。

最新のAppleシリコンを搭載したMac、ローカルで高性能なLLMを動かすための非常に優れたプラットフォームであることを改めて確認できました。今後のオープンモデルの進化にも期待したいと思います。